- SYNTHÈSE

- I. COMPRENDRE LES TECHNOLOGIES D'INTELLIGENCE

ARTIFICIELLE

- A. UNE BRÈVE HISTOIRE DE L'INTELLIGENCE

ARTIFICIELLE

- B. LES PROGRÈS DE L'APPRENTISSAGE PROFOND

DANS LES ANNÉES 2010 ET L'ARCHITECTURE TRANSFORMER

- C. LES QUESTIONS TECHNOLOGIQUES ET LES PERSPECTIVES

D'AVENIR

- D. LA CONJUGAISON ENTRE LA LOGIQUE DE L'IA

SYMBOLIQUE ET L'EFFICACITÉ DE L'IA CONNEXIONNISTE

- E. LA LONGUE ET COMPLEXE CHAÎNE DE VALEUR DE

L'IA

- A. UNE BRÈVE HISTOIRE DE L'INTELLIGENCE

ARTIFICIELLE

- II. LES ENJEUX POLITIQUES, ÉCONOMIQUES,

SOCIÉTAUX, CULTURELS ET SCIENTIFIQUES

- III. LA GOUVERNANCE ET LA RÉGULATION DE

L'INTELLIGENCE ARTIFICIELLE

- IV. LES PROPOSITIONS DE L'OFFICE

- I. COMPRENDRE LES TECHNOLOGIES D'INTELLIGENCE

ARTIFICIELLE

- AVANT-PROPOS

- PREMIÈRE PARTIE

COMPRENDRE LES TECHNOLOGIES D'INTELLIGENCE ARTIFICIELLE

- I. HISTOIRE DE LA NOTION D'INTELLIGENCE

ARTIFICIELLE

- A. LA PRÉHISTOIRE DE L'INTELLIGENCE

ARTIFICIELLE ET SES REPRÉSENTATIONS CULTURELLES

- B. LES AVANCÉES DEPUIS UN

SIÈCLE : DU BAPTÊME DE 1956 À LA CONFIRMATION DE

2017

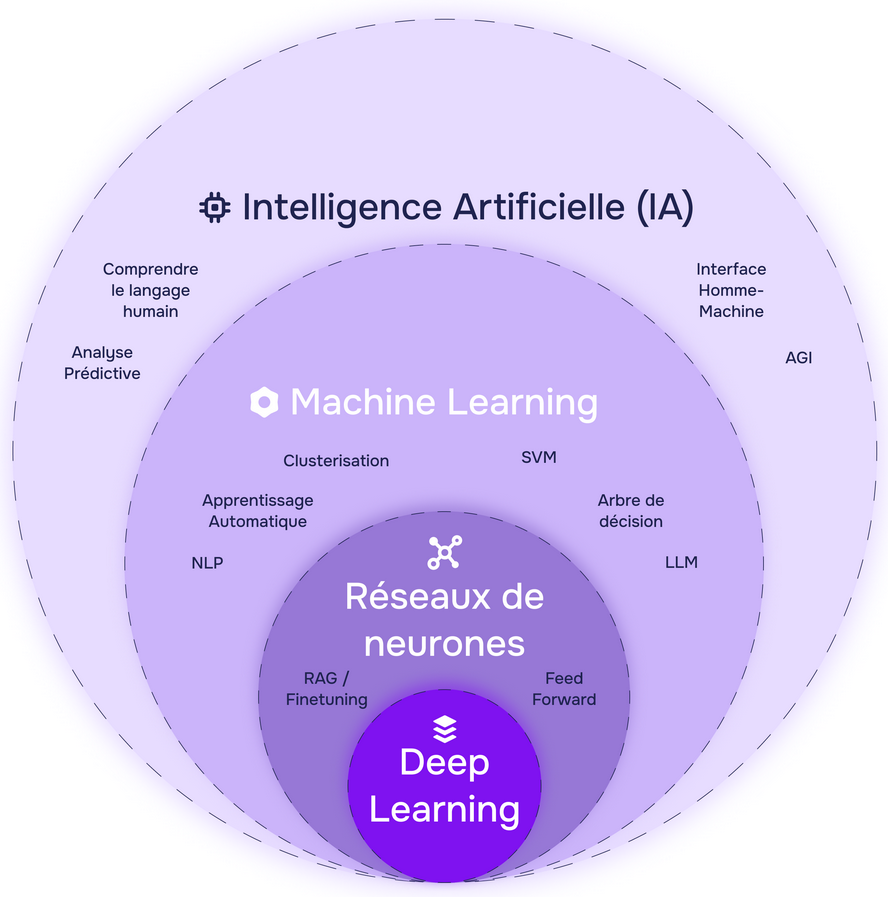

- C. LA SUMMA DIVISIO DE L'IA : INTELLIGENCE

ARTIFICIELLE SYMBOLIQUE ET INTELLIGENCE ARTIFICIELLE CONNEXIONNISTE

- 1. L'intelligence artificielle symbolique

- 2. L'intelligence artificielle

connexionniste

- a) Cadre et définition de ces

« superstatistiques »

- (1) À l'origine de tous ces

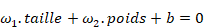

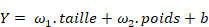

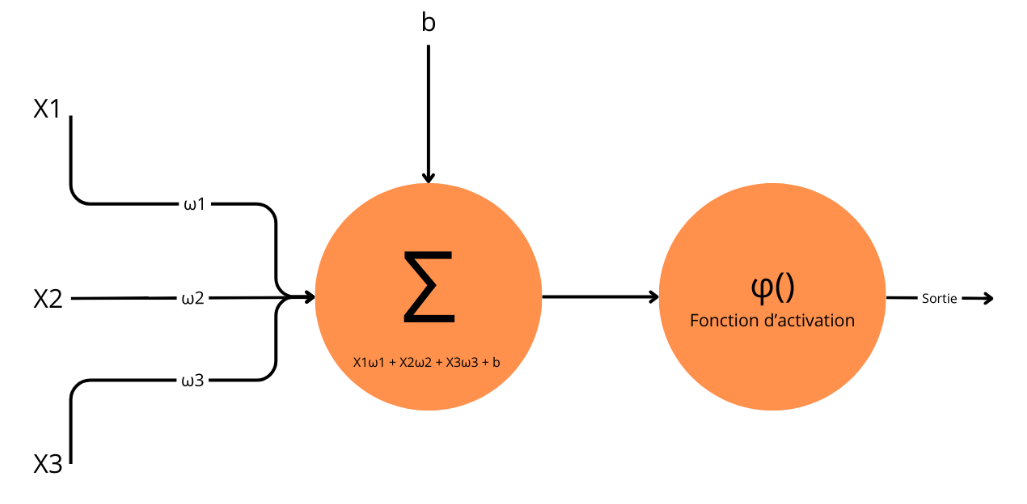

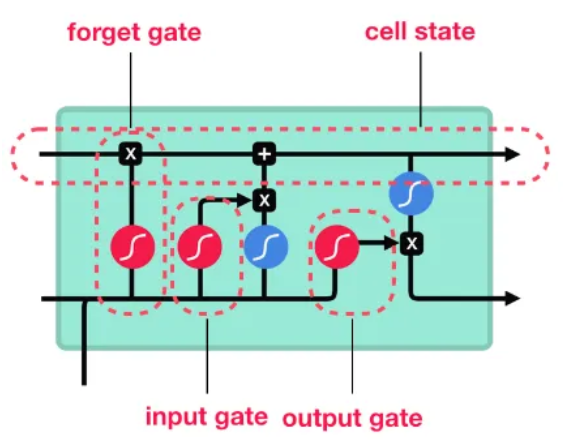

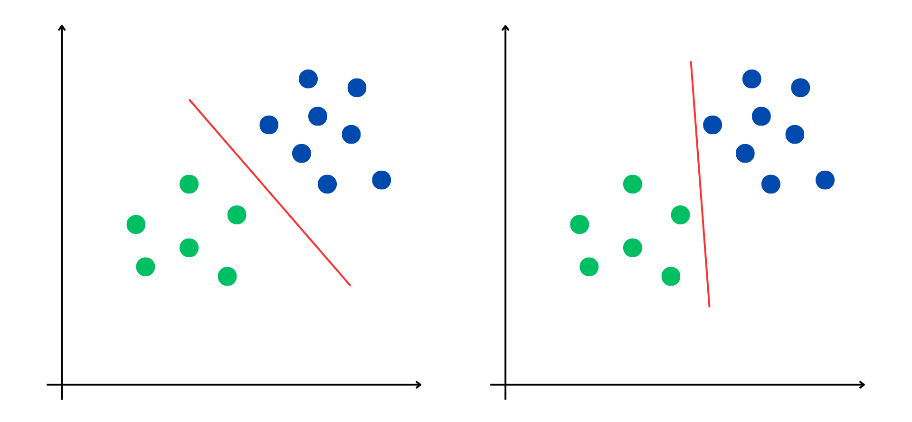

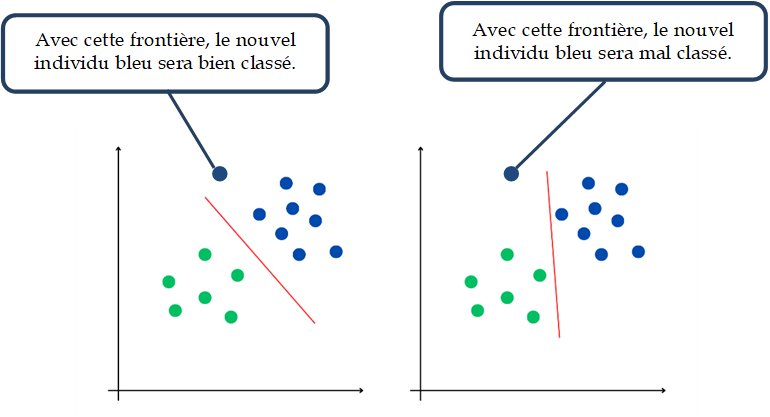

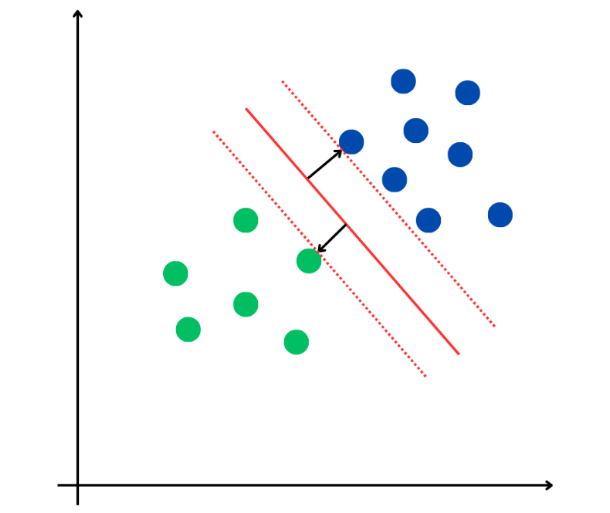

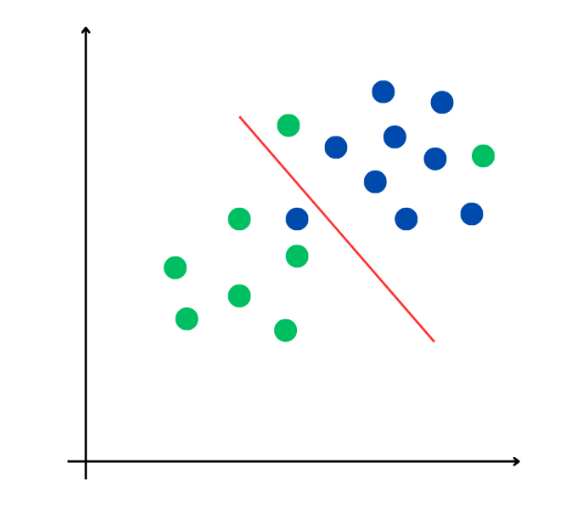

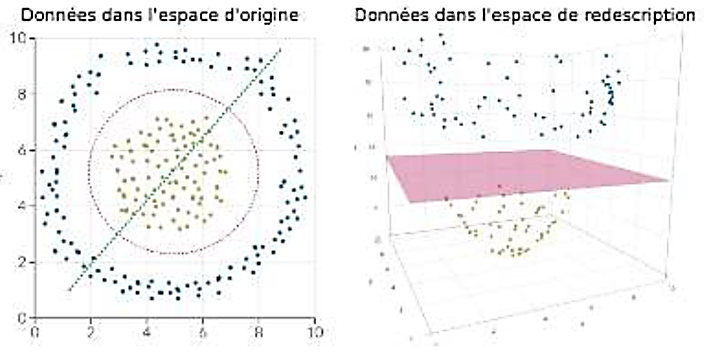

systèmes : les classifieurs linéaires

- (2) La pierre angulaire théorique : le

théorème d'approximation universelle

- b) Les réseaux de neurones

artificiels : aux origines de l'apprentissage profond ou Deep

Learning

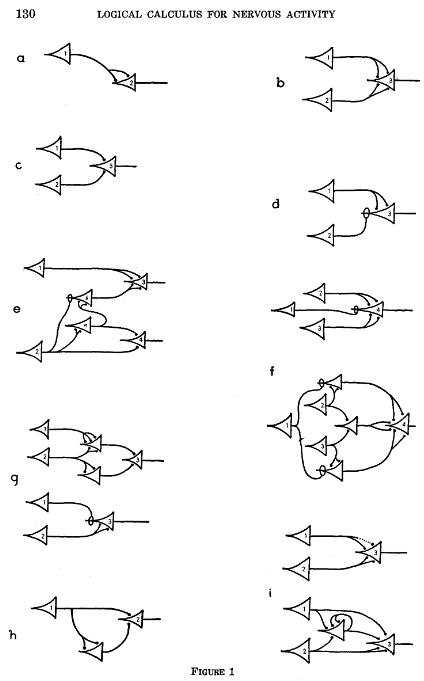

- (1) Les premières théories dans les

années 1940

- (2) Les premiers perceptrons

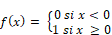

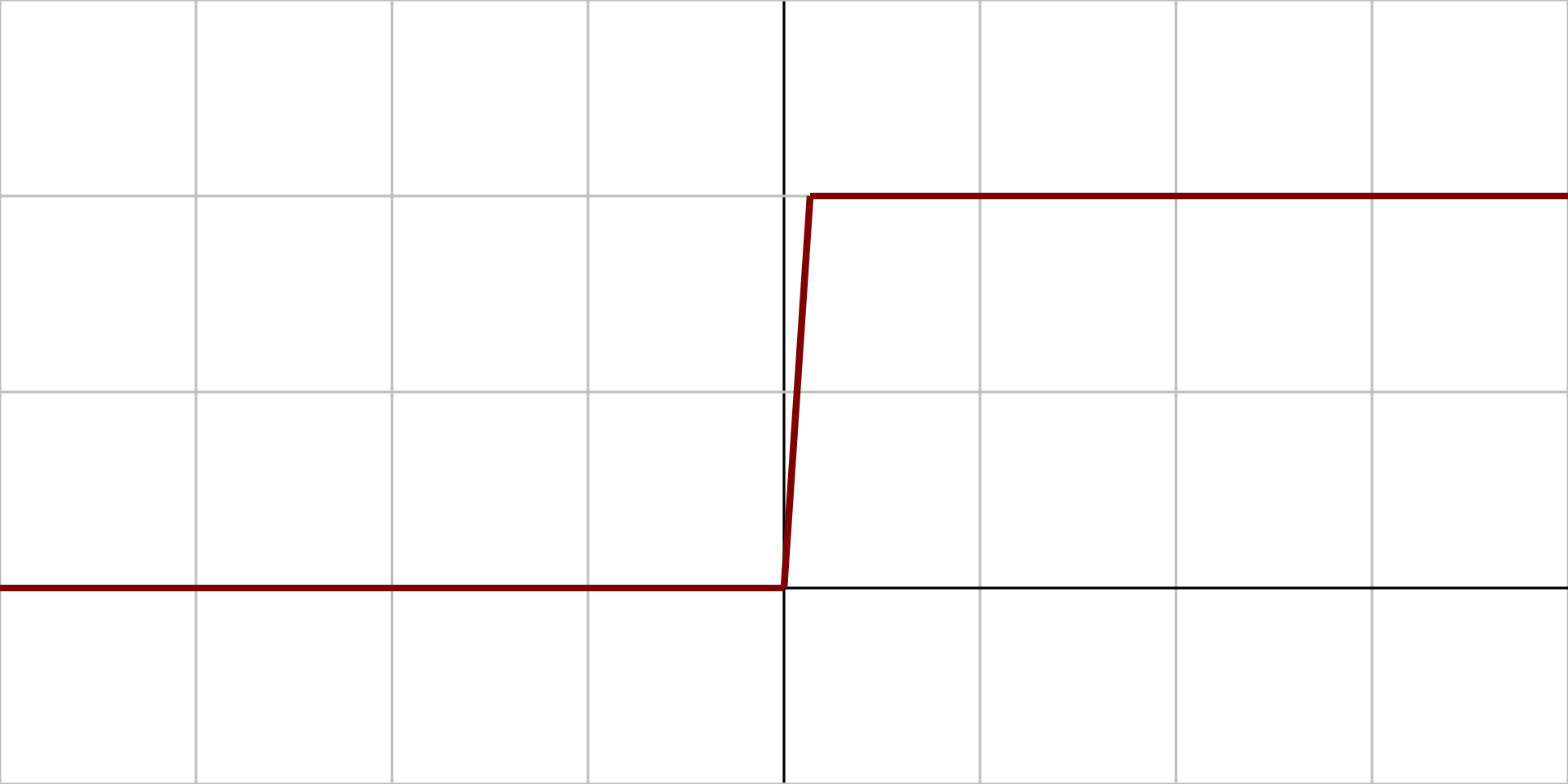

- (a) Les perceptrons monocouches

- (b) Les perceptrons multicouches (MLP) et les

réseaux de neurones à propagation avant (FNN)

- (3) La rétropropagation du gradient

(Back-propagation)

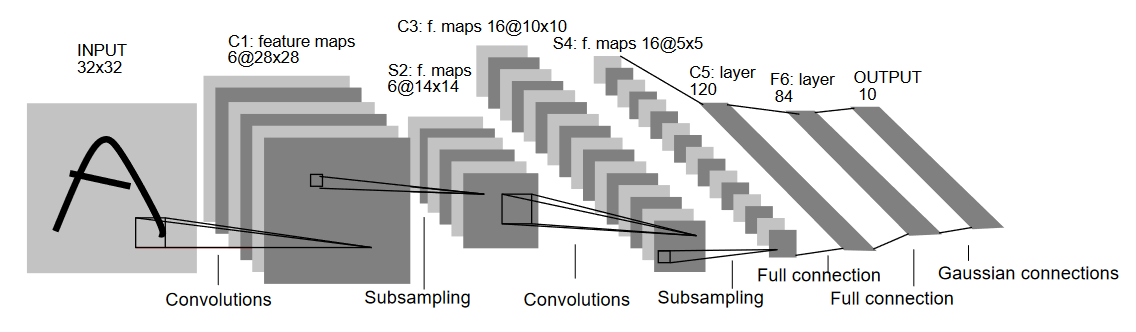

- (4) Les réseaux de neurones convolutifs

(CNN)

- (5) Les réseaux de neurones

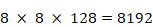

récurrents (RNN)

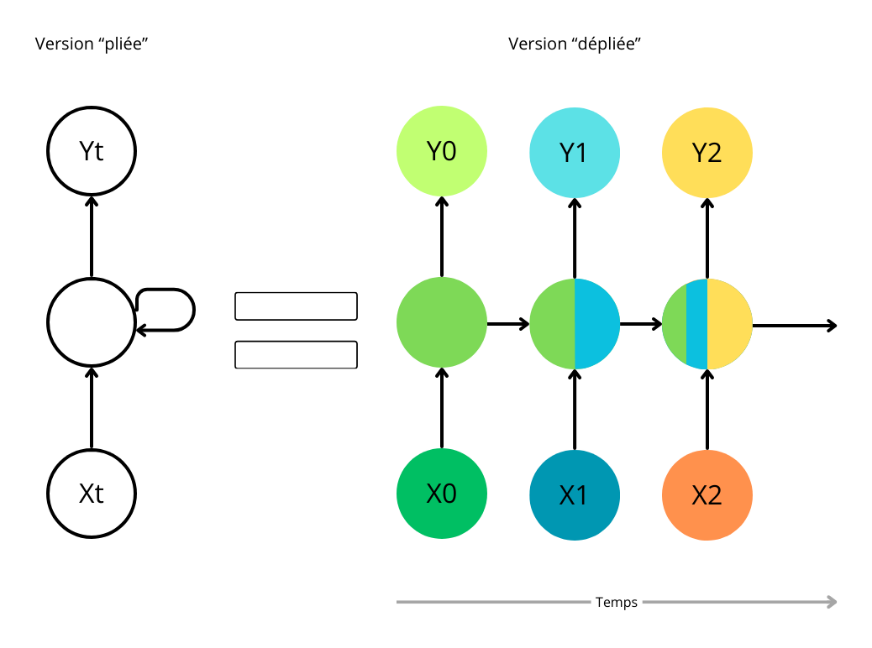

- (6) Les réseaux de neurones à

mémoire court et long terme (LSTM)

- c) Les autres systèmes

d'apprentissage

- (1) Les machines à vecteurs de support

(SVM)

- (2) Les modèles markoviens ou

« chaînes de Markov »

- (3) La contribution des réseaux

bayésiens à l'IA

- (4) L'apport de la

« régularisation statistique » de Vapnik

- a) Cadre et définition de ces

« superstatistiques »

- 1. L'intelligence artificielle symbolique

- A. LA PRÉHISTOIRE DE L'INTELLIGENCE

ARTIFICIELLE ET SES REPRÉSENTATIONS CULTURELLES

- II. LES IA GÉNÉRATIVES :

PRINCIPALE INNOVATION TECHNOLOGIQUE EN INTELLIGENCE ARTIFICIELLE DEPUIS

2017

- A. LES PRINCIPALES AVANCÉES EN

MATIÈRE DE GÉNÉRATION DE CONTENU CES DERNIÈRES

ANNÉES

- 1. « Attention is all you

need » : la technologie Transformer inventée en

2017

- 2. Distinguer les « modèles de

fondation » des systèmes d'intelligence artificielle

- 3. D'autres innovations récentes que la

technologie Transformer en matière d'IA générative

- a) La Génération par

diffusion : une innovation de pointe pour la création de contenus

visuels

- b) Générer du contenu avec des

réseaux de neurones convolutifs : les auto-encodeurs variationnels

(VAE)

- c) Les réseaux génératifs

antagonistes (GAN)

- d) La dernière innovation de 2024 :

l'architecture Mamba et son association avec un Transformer dans le

modèle Jamba

- a) La Génération par

diffusion : une innovation de pointe pour la création de contenus

visuels

- 1. « Attention is all you

need » : la technologie Transformer inventée en

2017

- B. LES GRANDES QUESTIONS TECHNOLOGIQUES ET LES

POSSIBLES ÉVOLUTIONS À VENIR

- 1. Les problématiques technologiques de

l'intelligence artificielle

- 2. Les tendances de la recherche et les

principales perspectives technologiques

- a) Moins halluciner : la

« Retrieval Augmented Generation » (RAG) par les

« Retrieval Augmented Transformers » (RAT)

- b) Manipuler en entrée et en sortie des

données de nature variée : les IA génératives

multimodales

- c) Faire des systèmes d'IA des interfaces

devenant la principale plateforme d'accès aux services

numériques

- d) Aller vers plus d'autonomie : le

défi de l'agentivité

- e) Faire plus avec moins : vers une IA

frugale et efficace

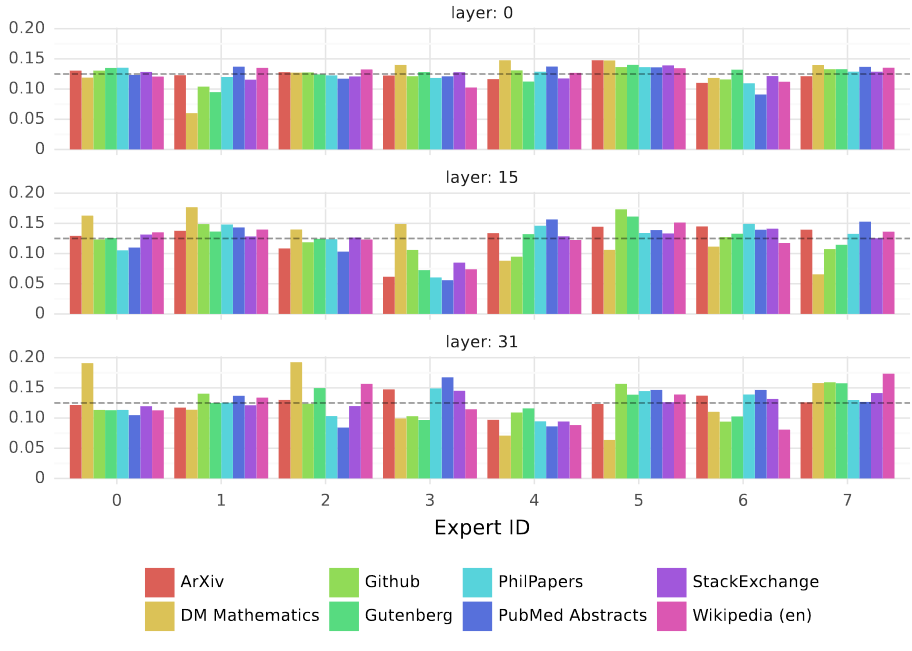

- f) L'exemple de la méthode

« Mixture of Experts » (MoE)

- a) Moins halluciner : la

« Retrieval Augmented Generation » (RAG) par les

« Retrieval Augmented Transformers » (RAT)

- 3. Synthèse et articulations entre les

modèles d'IA

- a) Des technologies enchâssées et

souvent conjuguées

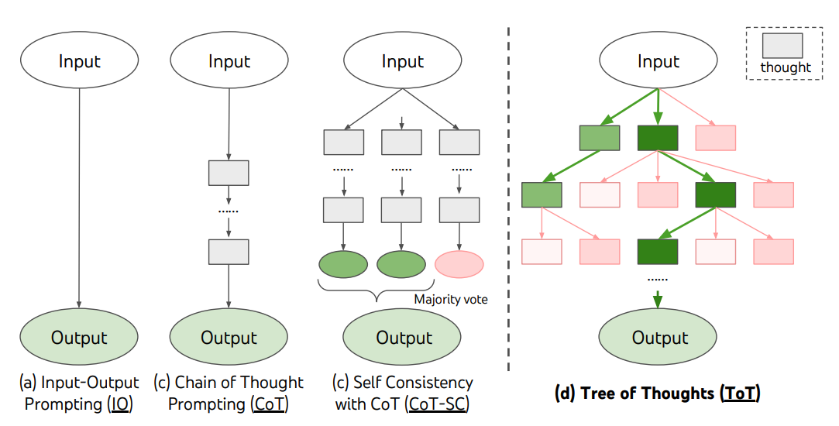

- b) Les Arbres de pensées ou Trees of

Thought (ToT) : l'IA

« symboliconnexionniste »

- c) La fécondité des hybridations IA

symboliques/IA connexionnistes, notamment pour doter ces systèmes d'une

représentation du monde réel

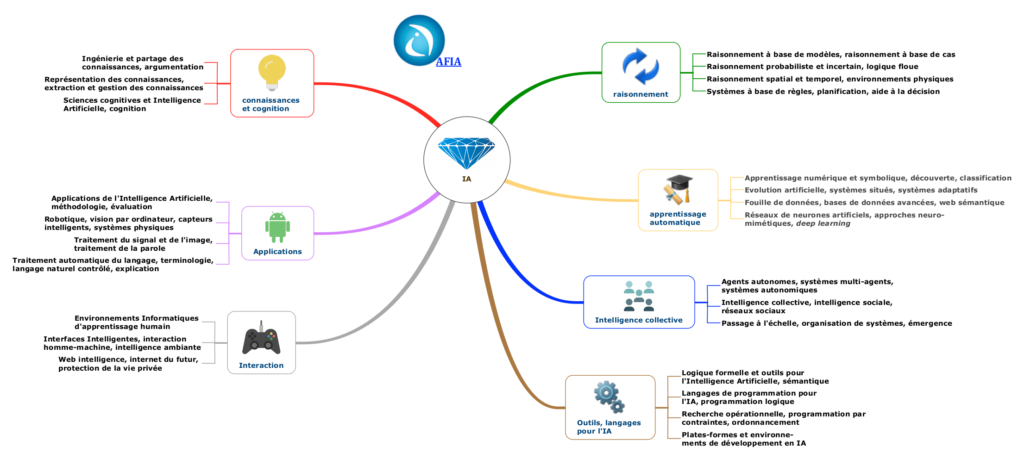

- d) La variété des domaines de

l'intelligence artificielle

- a) Des technologies enchâssées et

souvent conjuguées

- 1. Les problématiques technologiques de

l'intelligence artificielle

- A. LES PRINCIPALES AVANCÉES EN

MATIÈRE DE GÉNÉRATION DE CONTENU CES DERNIÈRES

ANNÉES

- III. LE GRAND MARCHÉ DE L'IA : UNE

CHAÎNE DE VALEUR ÉTENDUE DES MATIÈRES PREMIÈRES AUX

CONSOMMATEURS

- I. HISTOIRE DE LA NOTION D'INTELLIGENCE

ARTIFICIELLE

- DEUXIÈME PARTIE

LES ENJEUX DE L'INTELLIGENCE ARTIFICIELLE

- I. DES PROBLÉMATIQUES POLITIQUES

PRÉOCCUPANTES, SURTOUT À L'HEURE DE L'IA

GÉNÉRATIVE

- A. UNE SOUVERAINETÉ DE PLUS EN PLUS

MENACÉE : LES ENJEUX GÉOPOLITIQUES DE LA CHAÎNE DE

VALEUR DE L'IA

- B. DES RISQUES DE MANIPULATIONS POLITIQUES VOIRE

DE DÉSTABILISATION

- C. LA SINGULARITÉ ET LE RISQUE

EXISTENTIEL : DE L'IAG AUX SCÉNARIOS À LA TERMINATOR

- 1. Que sont l'intelligence artificielle

générale (IAG) et la Singularité ?

- a) La perspective possible mais pas certaine de

l'intelligence artificielle générale rend la singularité

et le risque existentiel encore moins probables

- b) L'hypothèse des lois d'échelle ou

scaling laws

- c) Quelques jalons sur les évolutions en

cours : des capacités croissantes et la probabilité de

plateaux

- a) La perspective possible mais pas certaine de

l'intelligence artificielle générale rend la singularité

et le risque existentiel encore moins probables

- 2. L'espace des positions face à

l'intelligence artificielle générale et au risque

existentiel

- a) Les techno-pessimistes : l'IA est un

risque existentiel et l'alternative un moratoire ou le transhumanisme

- b) Les pessimistes modérés :

l'IA est une menace, les mesures de prévention une solution

- c) Les techno-optimistes : l'absence de

menace, la poursuite du développement tranquille de l'IA avec un

encadrement pragmatique

- a) Les techno-pessimistes : l'IA est un

risque existentiel et l'alternative un moratoire ou le transhumanisme

- 1. Que sont l'intelligence artificielle

générale (IAG) et la Singularité ?

- A. UNE SOUVERAINETÉ DE PLUS EN PLUS

MENACÉE : LES ENJEUX GÉOPOLITIQUES DE LA CHAÎNE DE

VALEUR DE L'IA

- II. DES EFFETS GLOBALEMENT POSITIFS POUR LA

SOCIÉTÉ MALGRÉ DES IMPACTS ÉCONOMIQUES

CONTRASTÉS

- III. DES DÉFIS SANS PRÉCÉDENT

POUR LA SPHÈRE CULTURELLE ET LE MONDE SCIENTIFIQUE

- A. DE LA DOMINATION CULTURELLE ANGLO-SAXONNE

À L'UNIFORMISATION COGNITIVE

- B. LA CRÉATION AU DÉFI DE L'IMPACT

DE L'INTELLIGENCE ARTIFICIELLE SUR LA PROPRIÉTÉ INTELLECTUELLE ET

LES DROITS D'AUTEUR

- C. DES BÉNÉFICES

CONSIDÉRABLES POUR LA RECHERCHE

- 1. La fertilisation des autres disciplines

scientifiques par l'IA

- 2. Les cas emblématiques de l'analyse du

repliement des protéines en 2018 et de la génomique

en 2024

- 3. Les jumeaux numériques et le

perfectionnement des simulations

- 4. Adapter nos politiques de recherche aux

perspectives ouvertes par l'IA

- 1. La fertilisation des autres disciplines

scientifiques par l'IA

- A. DE LA DOMINATION CULTURELLE ANGLO-SAXONNE

À L'UNIFORMISATION COGNITIVE

- I. DES PROBLÉMATIQUES POLITIQUES

PRÉOCCUPANTES, SURTOUT À L'HEURE DE L'IA

GÉNÉRATIVE

- TROISIÈME PARTIE

LA GOUVERNANCE ET LA RÉGULATION DE L'INTELLIGENCE ARTIFICIELLE

- I. LES DISPOSITIFS NATIONAUX OU

RÉGIONAUX

- A. UNE POLITIQUE FRANÇAISE DE

L'INTELLIGENCE ARTIFICIELLE EN DEMI-TEINTE

- B. D'AUTRES DISPOSITIFS NATIONAUX DANS L'UNION

EUROPÉENNE

- 1. L'Allemagne : le pays le plus proche du

nôtre

- 2. L'Italie : une stratégie de soutien

et de vigilance

- 3. L'Espagne : un cadre complet avec un riche

volet culturel

- 4. Les Pays-Bas : une coalition

public-privé efficace et une régulation précoce

- 5. L'Estonie : un État

numérique préoccupé par la sécurité de

l'IA

- 6. La Finlande : une stratégie

tournée vers l'appropriation de l'IA et l'éducation

- 1. L'Allemagne : le pays le plus proche du

nôtre

- C. LA GOUVERNANCE EUROPÉENNE DE

L'INTELLIGENCE ARTIFICIELLE

- 1. Le travail préparatoire conduit par les

institutions européennes entre 2018 et 2020

- 2. De la proposition de règlement du

21 avril 2021 à la juxtaposition de deux dispositifs à la

suite des amendements adoptés

- a) Le volet issu du projet initial d'AI Act en

2021 : une régulation des usages selon leurs risques plutôt

qu'une régulation de la technologie elle-même

- b) Le volet ajouté par les

co-législateurs : la régulation des modèles de

fondation assortie d'un régime spécifique pour les modèles

les plus puissants, dits « à risque

systémique »

- c) Les autres aspects de l'AI Act : une

polysynodie institutionnelle, une portée extraterritoriale, un

calendrier très complexe et une normalisation désinvestie

- a) Le volet issu du projet initial d'AI Act en

2021 : une régulation des usages selon leurs risques plutôt

qu'une régulation de la technologie elle-même

- 3. Une gouvernance européenne de l'IA

à compléter

- a) Mobiliser les entreprises et élaborer de

la Soft Law : l'AI Pact et les bonnes pratiques

- b) Deux projets de directive

complémentaires à l'AI Act : l'intelligence artificielle

comme produit sur le marché unique

- c) Le soutien européen à la

recherche et à l'innovation en IA au-delà du dispositif

EuroHPC

- a) Mobiliser les entreprises et élaborer de

la Soft Law : l'AI Pact et les bonnes pratiques

- 1. Le travail préparatoire conduit par les

institutions européennes entre 2018 et 2020

- D. PANORAMA D'AUTRES RÉGULATIONS NATIONALES

DANS LE RESTE DU MONDE

- A. UNE POLITIQUE FRANÇAISE DE

L'INTELLIGENCE ARTIFICIELLE EN DEMI-TEINTE

- II. UNE DIZAINE DE PROJETS DE GOUVERNANCE

INTERNATIONALE NON COORDONNÉS

- A. LA RÉFLEXION TECHNIQUE LA PLUS

ABOUTIE : LES PRINCIPES, RECOMMANDATIONS ET MÉTRIQUES DE

L'OCDE

- B. LE CADRE MULTILATÉRAL EN

CONSTRUCTION

- C. LES FORUMS FERMÉS DU G7, DU PARTENARIAT

MONDIAL SUR L'INTELLIGENCE ARTIFICIELLE ET DU CONSEIL DU COMMERCE ET

DES TECHNOLOGIES UE-ÉTATS-UNIS

- D. LES INITIATIVES NON OCCIDENTALES

- E. LES AUTRES PROJETS DE GOUVERNANCE

MONDIALE : CONSEIL DE L'EUROPE, FORUM ÉCONOMIQUE MONDIAL,

INITIATIVES ÉMANANT DU SECTEUR PRIVÉ...

- 1. La Convention-cadre sur l'IA du Conseil de

l'Europe

- 2. L'Alliance pour la gouvernance de l'IA

proposée par le Forum économique mondial

- 3. Des principes et bonnes pratiques

proposés par les entreprises au Partnership on AI lancé en 2016

par sept géants de l'IA

- 4. Le Forum sur les modèles de pointe ou

Frontier Model Forum et les autres initiatives

- 1. La Convention-cadre sur l'IA du Conseil de

l'Europe

- F. LE CADRE EN CONSTRUCTION DES SOMMETS POUR LA

SÉCURITÉ DE L'INTELLIGENCE ARTIFICIELLE ET DES INSTITUTS DE

SÉCURITÉ DE L'IA

- A. LA RÉFLEXION TECHNIQUE LA PLUS

ABOUTIE : LES PRINCIPES, RECOMMANDATIONS ET MÉTRIQUES DE

L'OCDE

- III. LES PROPOSITIONS DE L'OFFICE

- A. LES PROPOSITIONS À SOUTENIR DANS LE

CADRE DU FUTUR SOMMET DE L'IA

- 1. Faire reconnaître le principe d'une

approche transversale de l'IA et renoncer à l'approche exclusivement

tournée vers les risques

- 2. Proposer de placer la gouvernance mondiale de

l'IA sous l'égide d'une seule organisation internationale

- 3. Initier le cadre d'une régulation

globale et multidimensionnelle de l'IA en s'inspirant des travaux de l'OCDE et

de l'UE

- 4. Annoncer un programme européen de

coopération en IA, associant plusieurs pays dont au moins la France,

l'Allemagne, les Pays-Bas, l'Italie et l'Espagne

- 5. Associer le Parlement à l'organisation

du sommet

- 1. Faire reconnaître le principe d'une

approche transversale de l'IA et renoncer à l'approche exclusivement

tournée vers les risques

- B. LES PROPOSITIONS VISANT À FONDER UNE

VÉRITABLE POLITIQUE NATIONALE DE L'IA

- 6. Développer une filière

française ou européenne autonome sur l'ensemble de la

chaîne de valeur de l'intelligence artificielle

- 7. Mettre en place une politique publique de l'IA

avec des objectifs, des moyens et des outils de suivi et

d'évaluation

- 8. Organiser le pilotage stratégique de la

politique publique de l'intelligence artificielle au plus haut niveau

- 9. Former les élèves de

l'école à l'Université, former les actifs et former le

grand public à l'IA

- 10. Accompagner le déploiement de ces

technologies dans le monde du travail et la société, notamment

par la formation permanente

- 11. Lancer un grand dialogue social autour de

l'intelligence artificielle et de ses enjeux

- 12. Mobiliser et animer l'écosystème

français de l'IA

- 13. Reconduire le programme

« Confiance.ai » ou mettre en place un projet

équivalent

- 14. Soutenir la recherche publique en intelligence

artificielle selon des critères de transversalité et de

diversification des technologies

- 15. Relever le défi de la normalisation en

matière d'intelligence artificielle

- 16. S'assurer du contrôle souverain des

données issues de la culture française et des cultures

francophones et créer des jeux de données autour des cultures

francophones

- 17. Préparer une réforme des droits

de propriété intellectuelle dont le droit d'auteur pour les

adapter aux usages de l'IA générative

- 18. Confier à l'OPECST le suivi et

l'évaluation régulière de la politique publique conduite

par le Gouvernement en la matière

- 6. Développer une filière

française ou européenne autonome sur l'ensemble de la

chaîne de valeur de l'intelligence artificielle

- A. LES PROPOSITIONS À SOUTENIR DANS LE

CADRE DU FUTUR SOMMET DE L'IA

- I. LES DISPOSITIFS NATIONAUX OU

RÉGIONAUX

- EXAMEN DU RAPPORT PAR L'OFFICE

- LISTE DES PERSONNES ENTENDUES

- ANNEXES

|

N° 642 |

N° 170 |

|

|

ASSEMBLÉE NATIONALE |

SÉNAT |

|

|

CONSTITUTION DU 4 OCTOBRE 1958 DIX-SEPTIÈME LÉGISLATURE |

SESSION ORDINAIRE 2024 - 2025 |

|

|

Enregistré à la présidence de l'Assemblée nationale |

Enregistré à la présidence du Sénat |

|

|

le 29 novembre 2024 |

le 28 novembre 2024 |

RAPPORT

au nom de

L'OFFICE PARLEMENTAIRE D'ÉVALUATION

DES CHOIX SCIENTIFIQUES ET TECHNOLOGIQUES

sur

les nouveaux développements de l'intelligence artificielle

par

M. Alexandre Sabatou, député, M. Patrick

Chaize et Mme Corinne Narassiguin, sénateur et sénatrice

|

Déposé sur le Bureau de l'Assemblée nationale par M. Pierre HENRIET, Premier vice-président de l'Office |

Déposé sur le Bureau du Sénat par M. Stéphane PIEDNOIR, Président de l'Office |

Composition de l'Office parlementaire

d'évaluation des choix scientifiques

et technologiques

Président

M. Stéphane PIEDNOIR, sénateur

Premier vice-président

M. Pierre HENRIET, député

Vice-présidents

|

M. Jean-Luc FUGIT, député M. Gérard LESEUL, député M. Alexandre SABATOU, député |

Mme Florence LASSARADE, sénatrice Mme Anne-Catherine LOISIER, sénatrice M. David ROS, sénateur |

|

DÉPUTÉS |

SÉNATEURS |

|

M. Alexandre ALLEGRET-PILOT M. Maxime AMBLARD M. Philippe BOLO M. Éric BOTHOREL M. Joël BRUNEAU M. François-Xavier CECCOLI M. Maxime LAISNEY M. Aurélien LOPEZ-LIGUORI Mme Mereana REID ARBELOT M. Arnaud SAINT-MARTIN M. Jean-Philippe TANGUY Mme Mélanie THOMIN M. Stéphane VOJETTA Mme Dominique VOYNET |

M. Arnaud BAZIN Mme Martine BERTHET Mme Alexandra BORCHIO FONTIMP M. Patrick CHAIZE M. André GUIOL M. Ludovic HAYE M. Olivier HENNO Mme Sonia de LA PROVÔTÉ M. Pierre MÉDEVIELLE Mme Corinne NARASSIGUIN M. Pierre OUZOULIAS M. Daniel SALMON M. Bruno SIDO M. Michaël WEBER |

ChatGPT, et après ?

Bilan et

perspectives de l'intelligence artificielle

« Le

progrès n'est plus dans l'homme, il est dans la technique,

dans le

perfectionnement des méthodes capables de permettre

chaque jour une

utilisation plus efficace du matériel humain »

Georges Bernanos, La France et les

Robots,

Éditions de la France libre, 1946, page 11.

SYNTHÈSE

ChatGPT, et

après ?

Bilan et perspectives de l'intelligence

artificielle

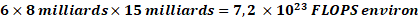

Un spectre hante le monde, le spectre de l'intelligence artificielle. Il alimente des angoisses irrationnelles autant que des attentes démesurées. Les technologies d'IA semblent à la fois omniprésentes et insaisissables, pourtant leur diffusion reste encore toute relative et leurs contours sont assez connus des spécialistes. L'IA devient un phénomène de plus en plus politique qui appelle une maîtrise démocratique. Le futur président des États-Unis, Donald Trump, a même déclaré le 28 novembre 2024 qu'il comptait nommer un « tsar de l'intelligence artificielle » qui siègerait à ses côtés à la Maison-Blanche. Aussi, faire le point sur ces technologies et leurs enjeux apparaît aujourd'hui indispensable.

Saisi en juillet 2023 par les bureaux de l'Assemblée nationale et du Sénat pour étudier les nouveaux développements de l'intelligence artificielle dans le contexte de la révolution de l'IA générative, l'Office présente un rapport qui tente, à la fois, de dresser un bilan des technologies d'intelligence artificielle et d'anticiper les tendances qui se dégagent. Ce rapport retrace les développements technologiques des différents modèles d'IA et le détail de leur fonctionnement, identifie leurs enjeux politiques, économiques, sociétaux, culturels et scientifiques, et aborde les questions de régulation, comparant la stratégie nationale française en IA à près de 20 autres, six dans l'Union européenne et onze dans le reste du monde, et en analysant une dizaine de projets de gouvernance mondiale de l'intelligence artificielle. Il propose en conclusion 18 recommandations, dont cinq à soutenir dans le cadre du Sommet pour l'action sur l'IA qui se tiendra à Paris les 10 et 11 février 2025.

I. COMPRENDRE LES TECHNOLOGIES D'INTELLIGENCE ARTIFICIELLE

A. UNE BRÈVE HISTOIRE DE L'INTELLIGENCE ARTIFICIELLE

Dans le prolongement du rapport de l'Office de mars 2017, ce nouveau rapport revient sur l'histoire et même la préhistoire de l'intelligence artificielle ainsi que sur sa présence forte dans la science-fiction, qui explique pourquoi l'IA suscite à la fois des espoirs excessifs et des craintes pas toujours justifiées.

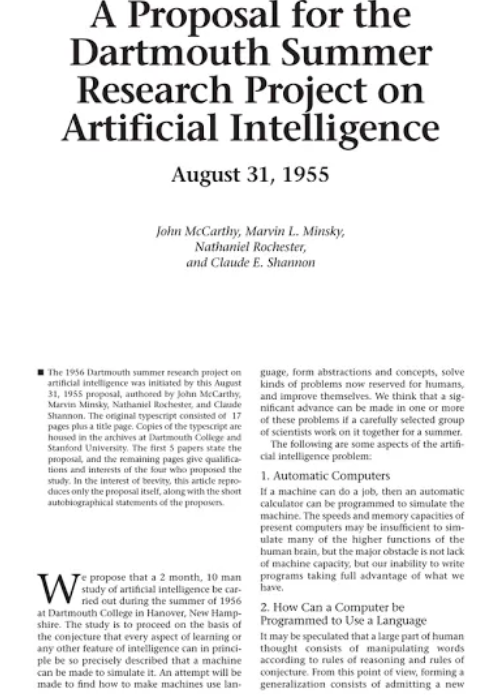

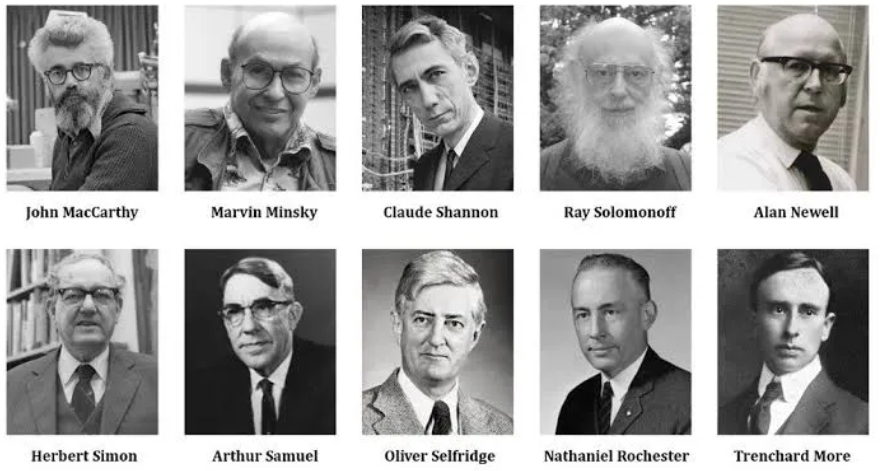

L'IA n'est pas nouvelle. Elle est liée à la naissance de l'informatique, il s'agit d'ailleurs d'un domaine de l'informatique, une sorte d'informatique avancée dont la frontière fluctue avec le temps. Sa naissance officielle a lieu en 1956 lors d'une école d'été du Dartmouth College.

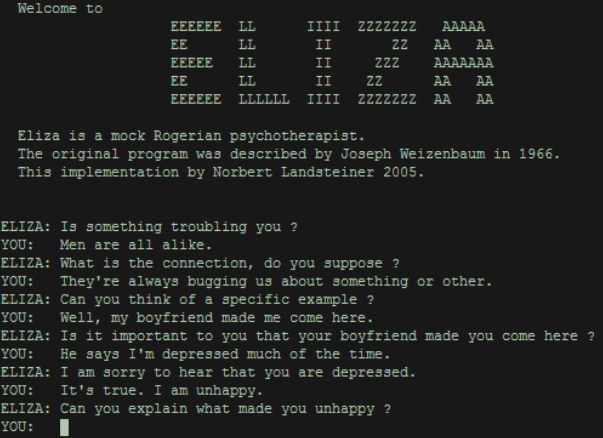

John McCarthy y introduit le concept d'intelligence artificielle et la définit comme une science visant à simuler les fonctions cognitives humaines. Marvin Minsky précise qu'il s'agit de construire des programmes capables d'accomplir des tâches relevant habituellement de l'intelligence humaine. Depuis, l'IA a connu des périodes de grands espoirs, comme les premières découvertes des années 1960 ou les systèmes experts des années 1980, chacune de ces périodes étant suivie de phases de désillusions, les « hivers de l'IA ».

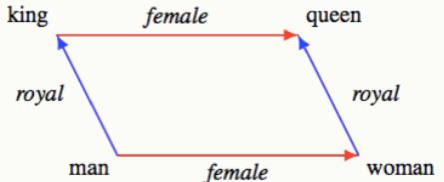

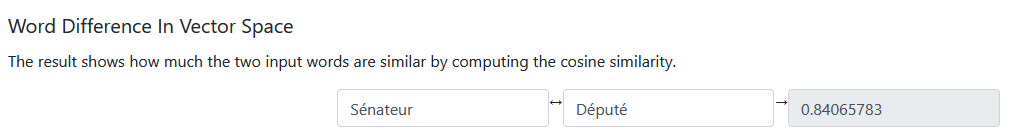

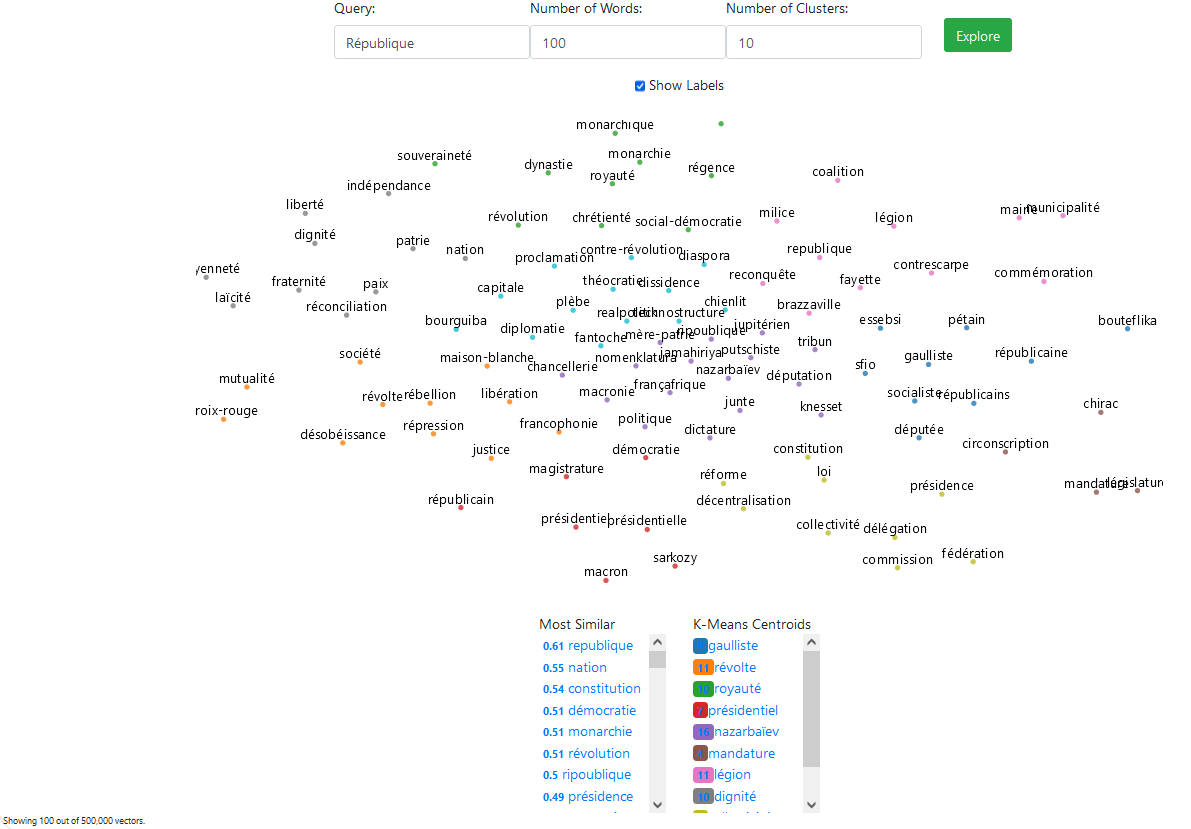

On distingue deux grandes approches : l'IA symbolique, caractérisée par l'utilisation de règles logiques pour résoudre des problèmes, simulant un raisonnement déductif, et l'IA connexionniste, qui se fonde sur une analyse probabiliste de données, simulant un raisonnement inductif.

B. LES PROGRÈS DE L'APPRENTISSAGE PROFOND DANS LES ANNÉES 2010 ET L'ARCHITECTURE TRANSFORMER

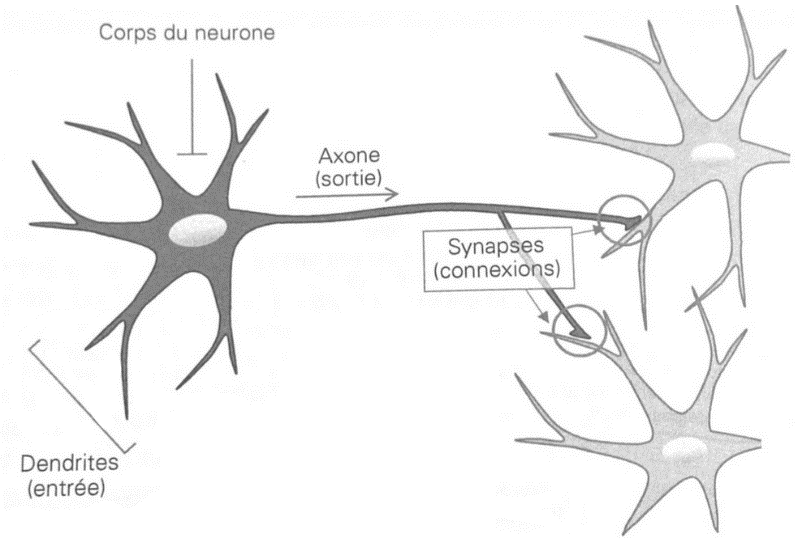

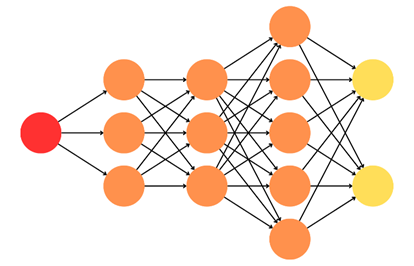

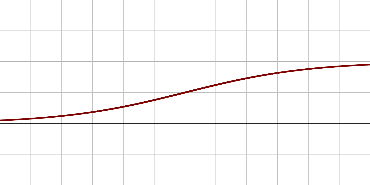

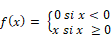

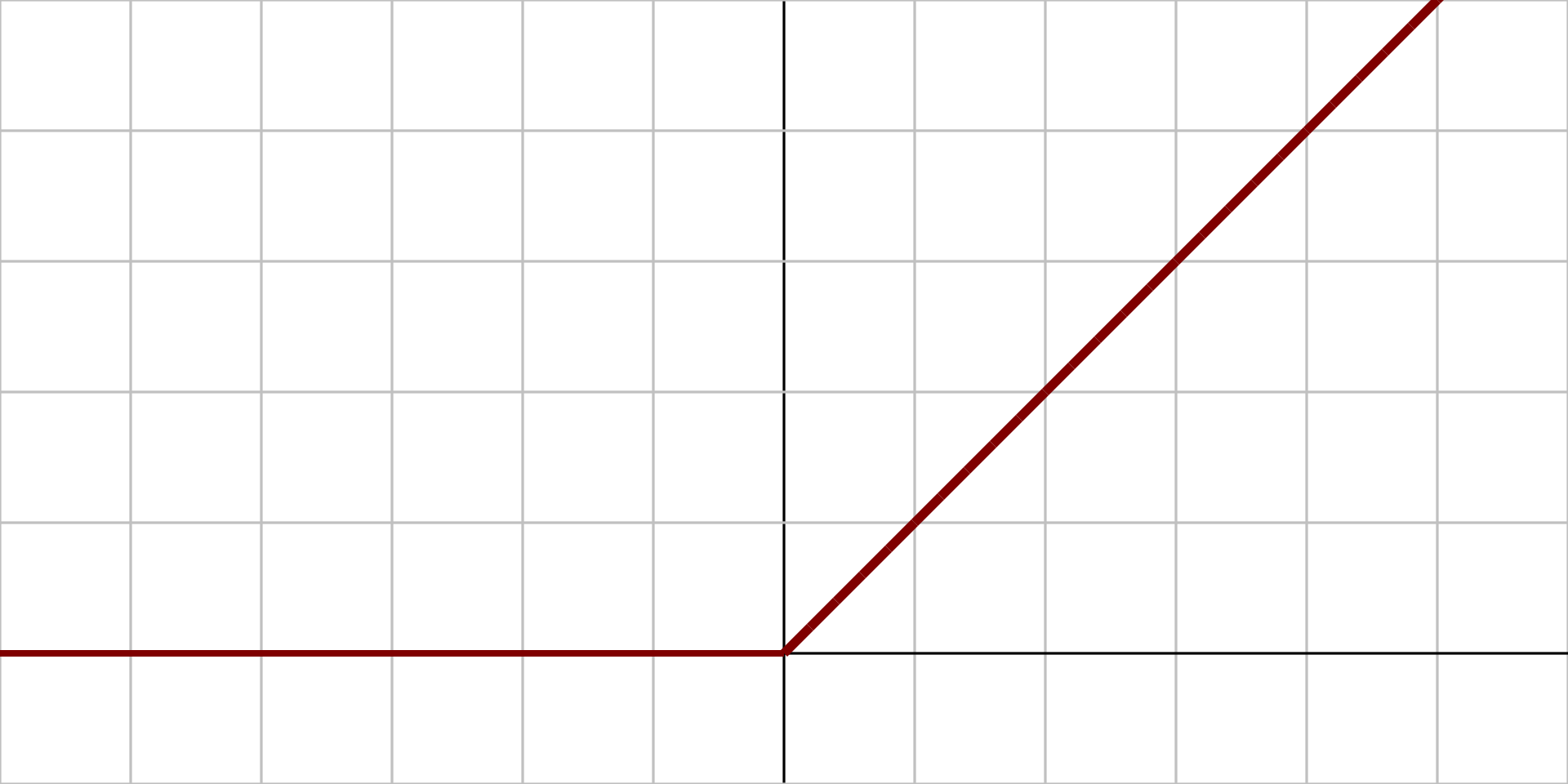

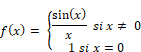

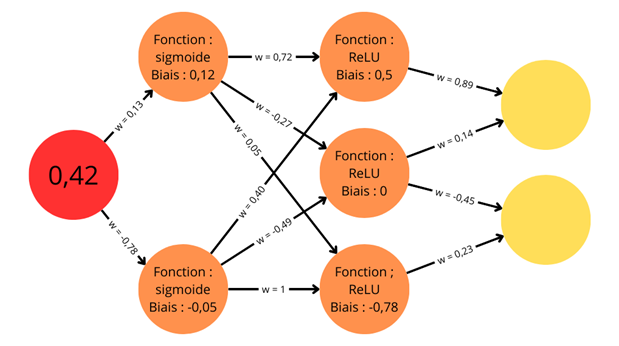

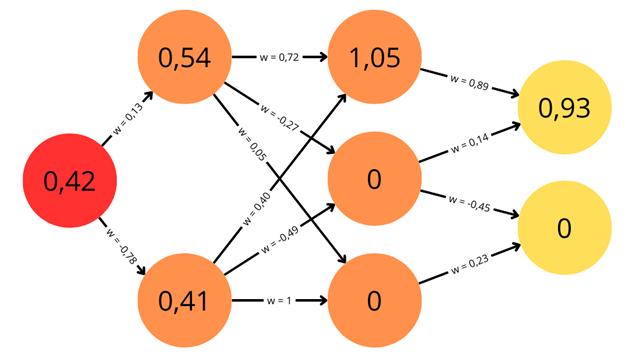

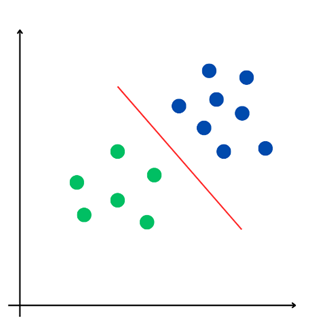

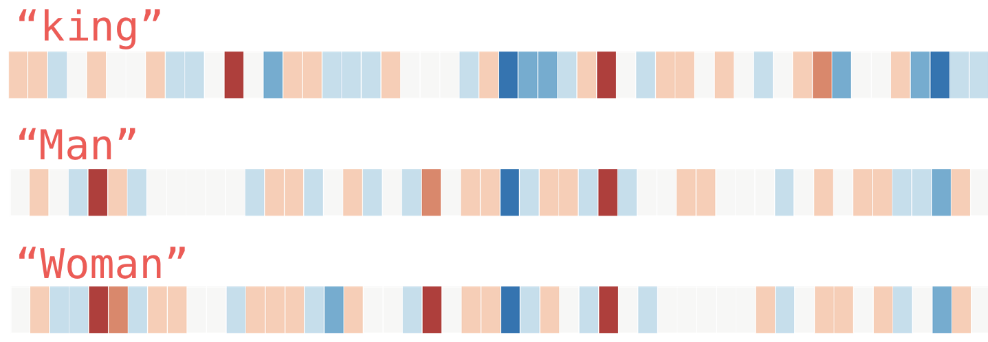

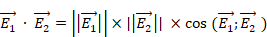

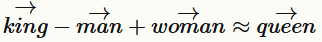

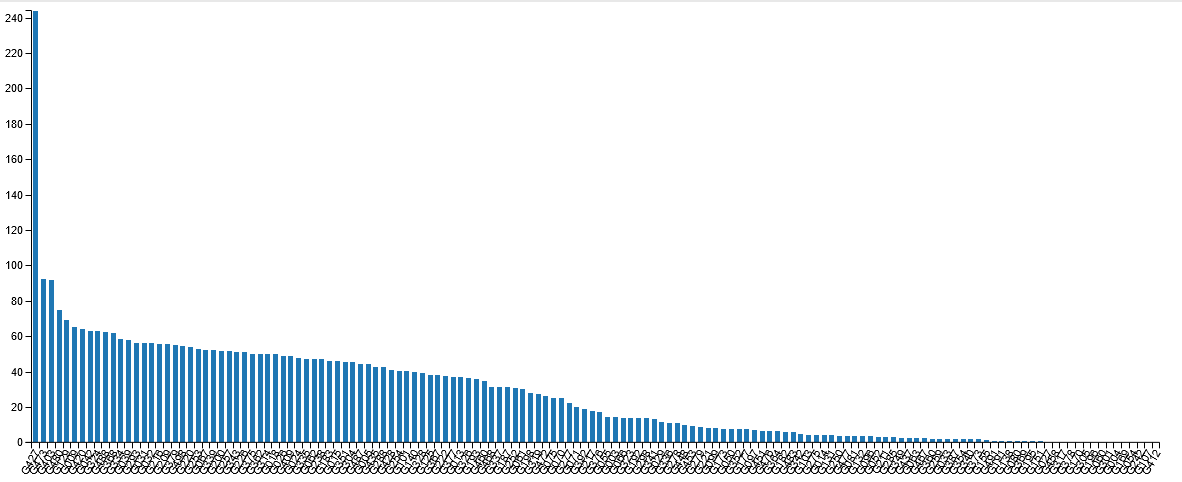

Un nouvel essor de l'IA a lieu depuis les années 2010 grâce aux progrès de l'apprentissage profond ou Deep Learning. L'apprentissage est dit « profond » car ses algorithmes reposent sur des réseaux de neurones artificiels composés de couches multiples. Chaque neurone représente une unité de calculs mathématiques qui correspond à une fonction d'activation. L'efficacité de ces modèles d'IA se développe dans les années 2010 grâce à trois éléments : la mobilisation de ces algorithmes, des corpus de données de taille inédite grâce à Internet, et une puissance de calcul des ordinateurs en augmentation rapide.

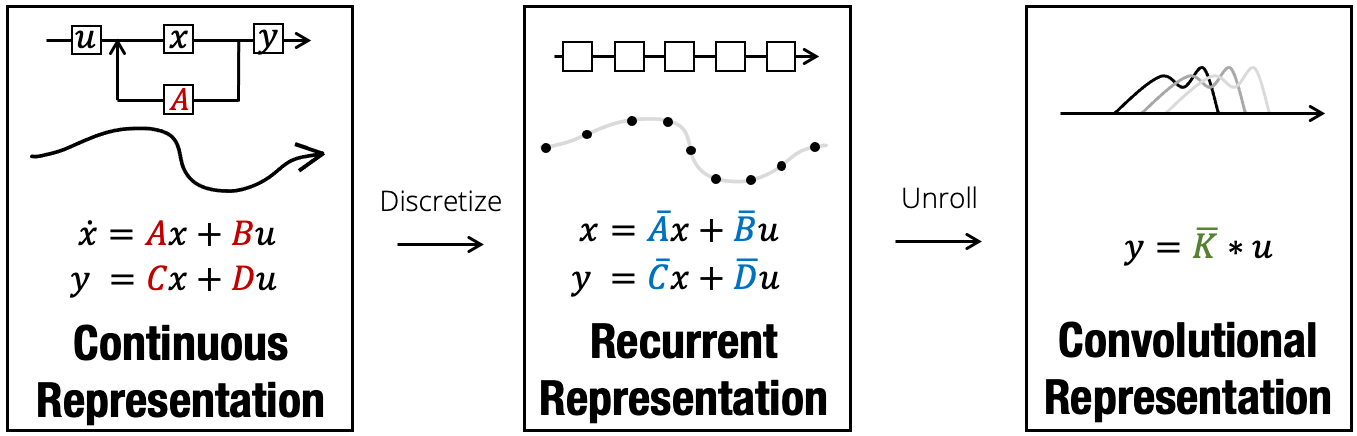

Depuis 2017, deux innovations majeures ont accéléré la mise en oeuvre de l'IA :

· l'architecture Transformer : cette innovation ajoute à l'apprentissage profond un meilleur traitement du contexte, grâce à un procédé appelé « mécanisme d'attention » ;

· l'application de cette architecture à la création de systèmes d'IA générative accessibles à tous. Ceci a donné naissance à des « modèles larges de langage » ou LLM comme ChatGPT mais aussi à des outils permettant de créer d'autres contenus : images, sons, vidéos, etc. Ces systèmes exploitent des milliards de données et mobilisent des centaines de milliards voire des milliers de milliards de paramètres de calcul pour générer du contenu. Certains systèmes d'IA générative se basent sur d'autres architectures mais ils ne donnent pas d'aussi bons résultats, sauf à être hybridés à l'architecture Transformer, par exemple selon une méthode dite du mélange d'experts (Mixture of Experts ou MoE). Ces systèmes donnent alors des résultats d'une précision inédite.

C. LES QUESTIONS TECHNOLOGIQUES ET LES PERSPECTIVES D'AVENIR

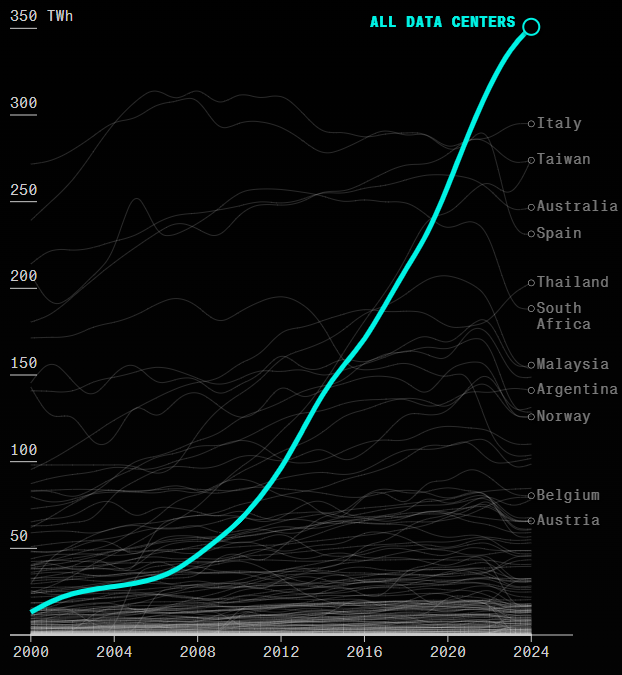

Quels sont les avantages et limites de ces technologies ? Et quelles perspectives s'ouvrent pour le futur ? Côté avantages, les applications sont innombrables, côté limites, les IA génératives doivent encore relever plusieurs défis technologiques. L'entraînement des modèles nécessite d'abord des ressources considérables, en infrastructures de calcul comme de stockage des données mais pas seulement : l'IA nécessite en effet des apports considérables d'énergie tout au long de son cycle de vie. Les modèles peuvent générer des erreurs appelées « hallucinations ». Leur production est sujette à des biais présents dans les données ou introduits au stade de leur programmation humaine ; certains ont d'ailleurs dénoncé des IA woke. Enfin, ces modèles continuent de poser les problèmes d'opacité déjà rencontrés pour les anciennes générations de Deep Learning : ces systèmes fonctionnent comme des « boîtes noires », rendant leur explicabilité complexe.

Ces défis nécessitent des efforts de recherche pour améliorer la fiabilité des résultats et réduire la consommation énergétique de ces systèmes. Faire plus avec moins : l'objectif est d'aller vers des IA frugales et efficaces. L'architecture Mamba, alternative aux Transformers repose sur les modèles en espace d'états structurés et articule plusieurs types d'IA. C'est une piste intéressante. Les perspectives pour l'IA seront donc sa frugalité mais aussi sa multimodalité et son agentivité.

Les IA multimodales traitent déjà des données variées (texte, image, son, etc.) et en traiteront bientôt davantage encore, en entrée comme en sortie, pour des usages de plus en plus diversifiés et intégrés. En 2024, GPT-4o (avec un « o » pour omni) a ajouté aux textes et aux images le traitement d'instructions vocales et même des interactions vidéo. La société xAI a ajouté à son modèle Grok 2 la génération d'images en septembre 2024 puis la compréhension d'images en octobre 2024.

L'agentivité est la capacité des systèmes à être autonomes et proactifs. La principale innovation en 2024 est celle des Agentic Workflows, IA basées sur des LLM et générant une série d'actions permettant une automatisation des tâches en s'adaptant en temps réel à la complexité des flux de travail. Ces outils devraient être particulièrement utiles pour les entreprises.

Les IA vont aussi devenir des interfaces et les principales plateformes d'accès aux services numériques. Ces interfaces rendront les interactions homme-machine plus fluides et pourraient devenir le point d'appui des smartphones et des ordinateurs, agrégeant les fonctionnalités de l'interface du système d'exploitation, des navigateurs web, des moteurs de recherche, des logiciels bureautiques, des réseaux sociaux et d'autres applications. Il est probable qu'à l'avenir les systèmes d'IA deviennent les colonnes vertébrales de contrôle des ordinateurs, à partir desquelles s'articuleront plusieurs services logiciels.

Des solutions technologiques sont également attendues pour faire face à la tendance des LLM à « halluciner », c'est-à-dire à générer des propos dénués de sens ou des réponses objectivement fausses sans émettre le moindre doute. La génération augmentée de récupération (Retrieval Augmented Generation ou RAG) constitue par exemple un moyen d'adjoindre une base de données à un LLM, qui, à l'aide d'un récupérateur, utilise les données de cette base en lien avec l'instruction de l'utilisateur.

D. LA CONJUGAISON ENTRE LA LOGIQUE DE L'IA SYMBOLIQUE ET L'EFFICACITÉ DE L'IA CONNEXIONNISTE

Les technologies d'IA peuvent être enchâssées les unes dans les autres et conjuguées pour produire de meilleurs résultats. Combiner l'IA connexionniste avec des modèles logiques ou des modèles de représentation du monde réel sera indispensable. L'espace-temps reste en effet inconnu des meilleures IA génératives.

On peut se rapprocher de telles articulations avec les Arbres de pensées ou Trees of Thoughts (ToT). Sans relever directement de l'IA symbolique, cette technique s'en rapproche par son recours à des étapes formelles de raisonnement, les idées venant s'articuler logiquement les unes par rapport aux autres. L'IA devient alors neuro-symbolique car empruntant à la fois des réseaux neuronaux et des raisonnements symboliques. Cette méthode peut être appliquée directement à tous les grands modèles de langage actuels grâce à une instruction décomposée en plusieurs phases de raisonnement. On parle pour ces techniques de prompt engineering. À l'avenir, outre cet art du prompt, on trouvera de nombreuses façons de combiner et d'hybrider les technologies, notamment les deux branches de l'IA, afin que les systèmes se rapprochent de nos raisonnements logiques.

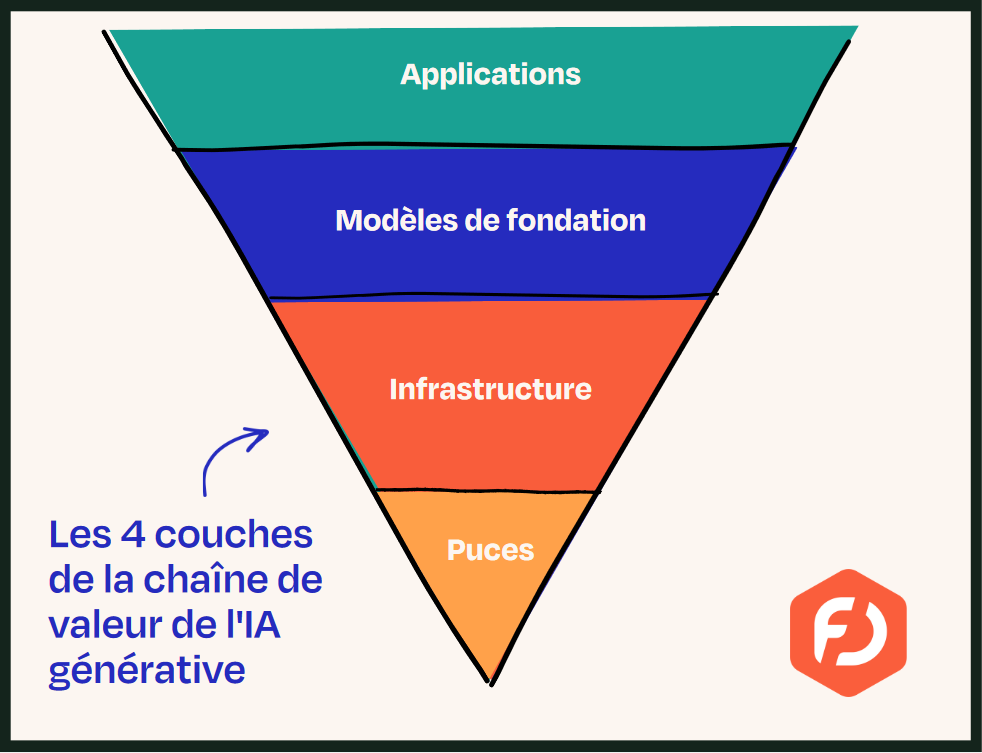

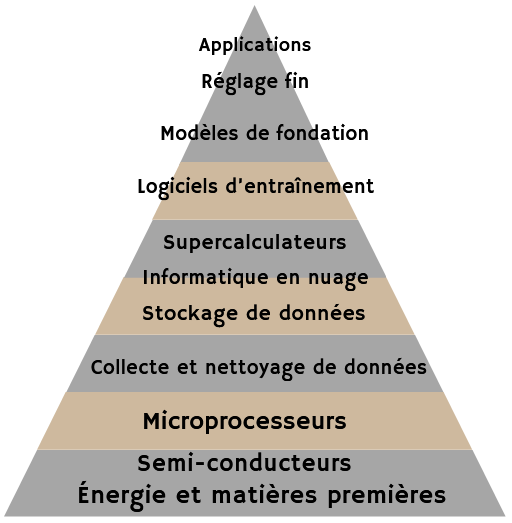

E. LA LONGUE ET COMPLEXE CHAÎNE DE VALEUR DE L'IA

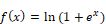

La chaîne de valeur de l'IA comporte une dizaine d'étapes. Tout commence avec l'énergie et les matières premières : les semi-conducteurs en silicium permettent la fabrication des puces, des logiciels permettent de concevoir ces microprocesseurs et des machines lithographiques gravent le silicium à l'échelle moléculaire. Nvidia est devenu, pour le moment, l'acteur dominant de ce premier maillon de la chaîne.

Le deuxième maillon, celui des infrastructures, se subdivise en de nombreuses couches :

- la collecte et le nettoyage de données ;

- le stockage de données dans de vastes data centers ;

- l'informatique en nuage (cloud) pour les calculs ;

- lors de la phase de développement des modèles, le recours spécifique à des supercalculateurs.

La multiplication de ces infrastructures entraîne des coûts très élevés et des impacts environnementaux considérables. Nvidia devra, par exemple, réaliser un chiffre d'affaires de 600 milliards de dollars pour lui permettre un retour sur investissement.

L'étape suivante est celle de la définition des modèles d'IA, elle-même subdivisée en plusieurs phases :

- la conception de l'architecture du modèle ;

- l'entraînement du modèle de fondation à l'aide des infrastructures et d'algorithmes ;

- le réglage fin par des apprentissages supervisés et une phase d'alignement.

Les modèles de fondation s'intercalent donc entre la définition de l'architecture du modèle et le fine-tuning, ce qui permet aux systèmes d'IA d'être déployés pour des applications spécifiques ou d'être diffusés auprès du grand public.

La dernière étape est celle des utilisateurs, les applications caractérisant l'aval. Les systèmes d'IA ne deviennent accessibles aux utilisateurs qu'à travers une couche de services applicatifs, dont les fameux LLM d'OpenAI, comme ChatGPT, conçu à partir du modèle de fondation GPT-4.

II. LES ENJEUX POLITIQUES, ÉCONOMIQUES, SOCIÉTAUX, CULTURELS ET SCIENTIFIQUES

Trois grandes catégories d'enjeux sont présentées : les problématiques politiques de l'intelligence artificielle, les transformations socio-économiques, et les défis culturels et scientifiques. L'IA est devenue une technologie incontournable, qui transforme nos sociétés et nos économies, mais aussi les rapports de force politiques et géopolitiques.

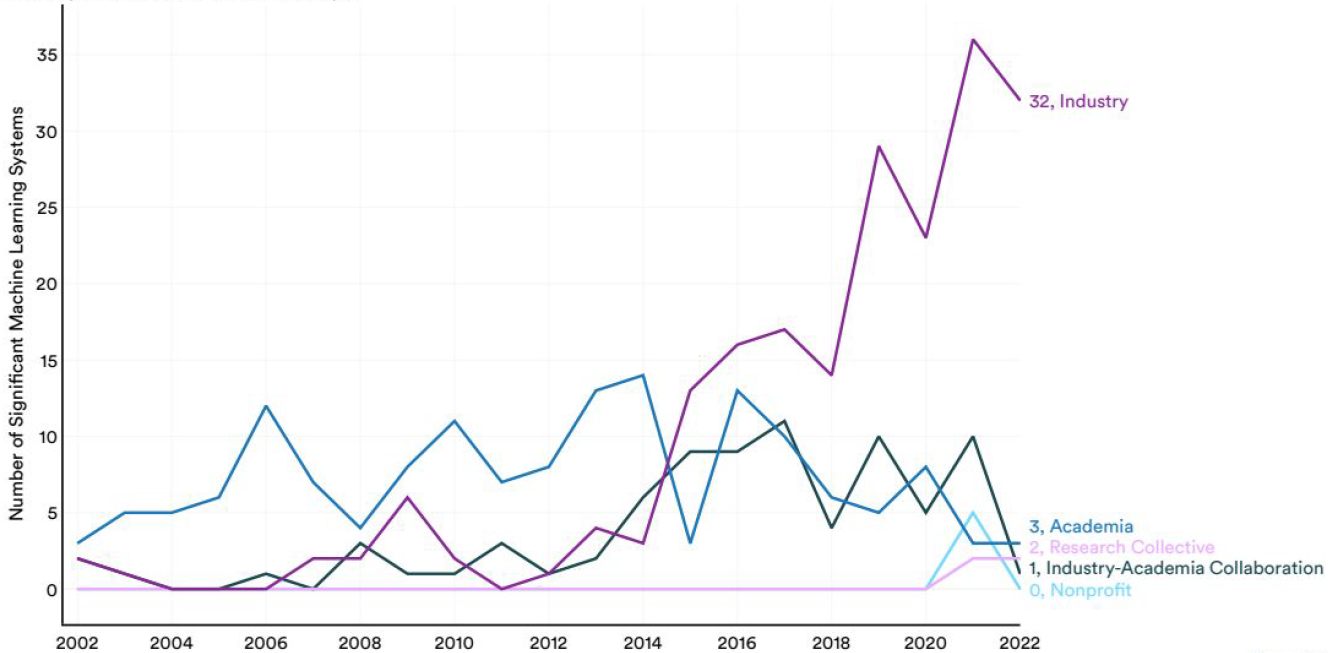

A. LES PROBLÉMATIQUES POLITIQUES

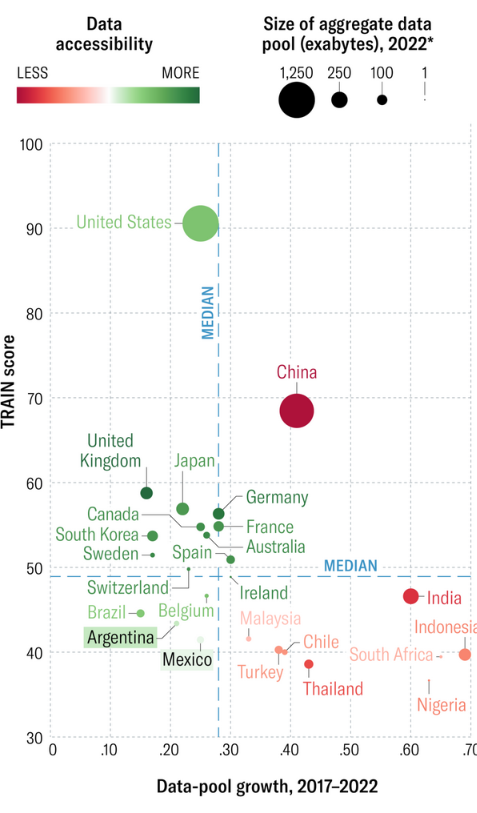

· La géopolitique de l'IA

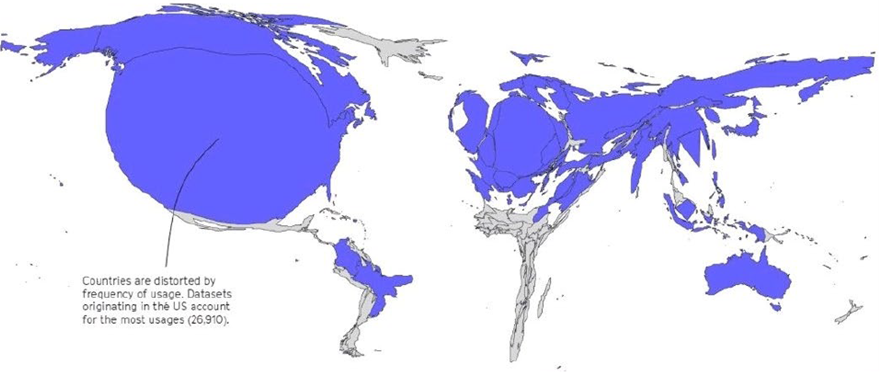

La recherche en IA est dominée par la recherche privée, principalement américaine. Les États-Unis, grâce à leurs géants technologiques - les GAFAM, devenus les MAAAM désignant, dans l'ordre, Microsoft, Apple, Alphabet, Amazon et Meta - dominent l'écosystème global de l'IA, avec Nvidia en sus, qui fournit toutes les entreprises en processeurs graphiques. Outre son impact économique, l'IA devient en elle-même un levier de pouvoir géopolitique.

En parallèle, la Chine aspire à devenir leader mondial d'ici 2030, investissant toute la chaîne de valeur, notamment les semi-conducteurs. Ces derniers sont devenus un enjeu de premier plan qui dépasse la seule filière de l'IA. Alors que les deux tiers des puces sont à ce jour fabriquées à Taïwan, les autorités américaines et chinoises cherchent à attirer une part croissante de cette production sur leur sol.

Pour l'Europe, et notamment la France, le défi est celui de la souveraineté numérique, afin d'éviter de devenir une pure et simple « colonie numérique ». L'Union européenne mise aujourd'hui sur la régulation de l'IA, mais cela reste insuffisant face à la taille et à l'avance des puissances américaine et chinoise. La souveraineté numérique contre la domination de la Big Tech américaine appelle au développement d'acteurs français et européens puissants.

· Les risques de manipulations politiques

L'IA génère de nouveaux risques, notamment à travers la désinformation et les hypertrucages (deepfakes). Les fausses informations ou les trucages ont toujours existé, mais l'IA fait changer d'échelle.

Ces technologies permettent de produire instantanément et massivement des contenus falsifiés réalistes, capables d'influer sur les élections ou de ternir la réputation d'une personnalité publique. Des régulations imposant des filigranes sur ces contenus constituent une réponse, mais elles seront difficiles à appliquer.

· Les menaces pour la sécurité et le risque existentiel

L'IA facilite les attaques à grande échelle, à travers la création de logiciels malveillants ou la capture de données sensibles. Ces risques appellent des mesures de sécurité renforcées : sécurisation des modèles, analyse des risques et formation en cybersécurité des développeurs.

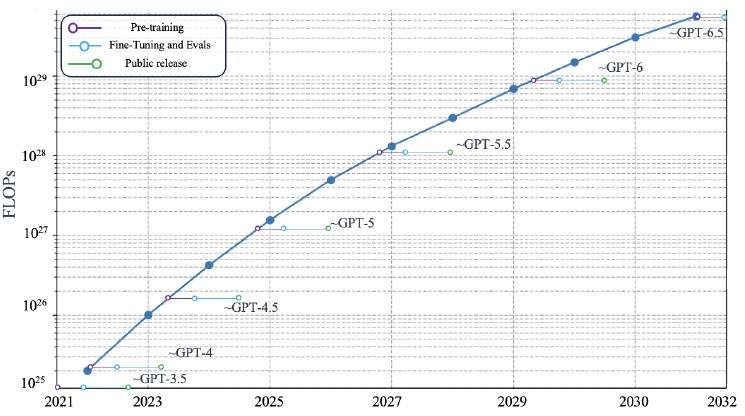

L'intelligence artificielle générale (IAG) qui dépasserait les capacités humaines reste une hypothèse incertaine. Bien qu'elle suscite des débats passionnés, ses bases scientifiques comme les lois d'échelle (scaling laws) restent fragiles. Certains craignent que cette IAG fasse courir un « risque existentiel » à l'humanité, comme Elon Musk qui prône même une hybridation homme-machine pour « rivaliser » avec l'IA tandis que d'autres, comme Yann LeCun, estiment que l'IA actuelle demeure très loin du tournant de la Singularité, n'ayant toujours pas de sens commun ou de capacités autonomes réelles.

B. LES IMPACTS SOCIÉTAUX ET ÉCONOMIQUES

· Santé et bien-être

L'IA améliore déjà la vie, à travers une multitude d'outils pour nous aider au quotidien. Elle optimise nos parcours de transport et surveille notre rythme cardiaque grâce des applications de santé. À l'avenir, diagnostics, dépistages précoces et traitements seront optimisés grâce à l'IA, la recherche médicale sera accélérée et des capteurs permettront d'anticiper des urgences médicales, comme des crises cardiaques. En dépit de tous ces avantages pour la santé, l'utilisation massive de l'IA pourrait aussi avoir des conséquences négatives sur la santé psychologique.

· Un impact économique incertain

Les travaux qui tentent de prédire l'impact de l'intelligence artificielle sur la croissance ou son potentiel en termes de gains de productivité divergent. L'IA peut stimuler certains secteurs, mais son impact global sur la croissance reste incertain dans un contexte de faible diffusion des technologies. La direction générale du Trésor (DGT) estime qu'il est encore trop tôt pour pouvoir estimer des prévisions chiffrées. Le paradoxe de Solow (« on voit des ordinateurs partout sauf dans les statistiques de productivité ») pourrait se confirmer pour l'IA. Il est vrai que la diffusion de l'innovation est toujours difficile à observer et encore plus à quantifier.

Le coût énergétique de l'IA conduit à un impact environnemental considérable et grandissant : ces systèmes ont une empreinte carbone et un impact sur la ressource en eau élevés, qui ne font que croître car les besoins en énergie de l'IA explosent. Le développement de l'IA menace donc l'atteinte des objectifs climatiques.

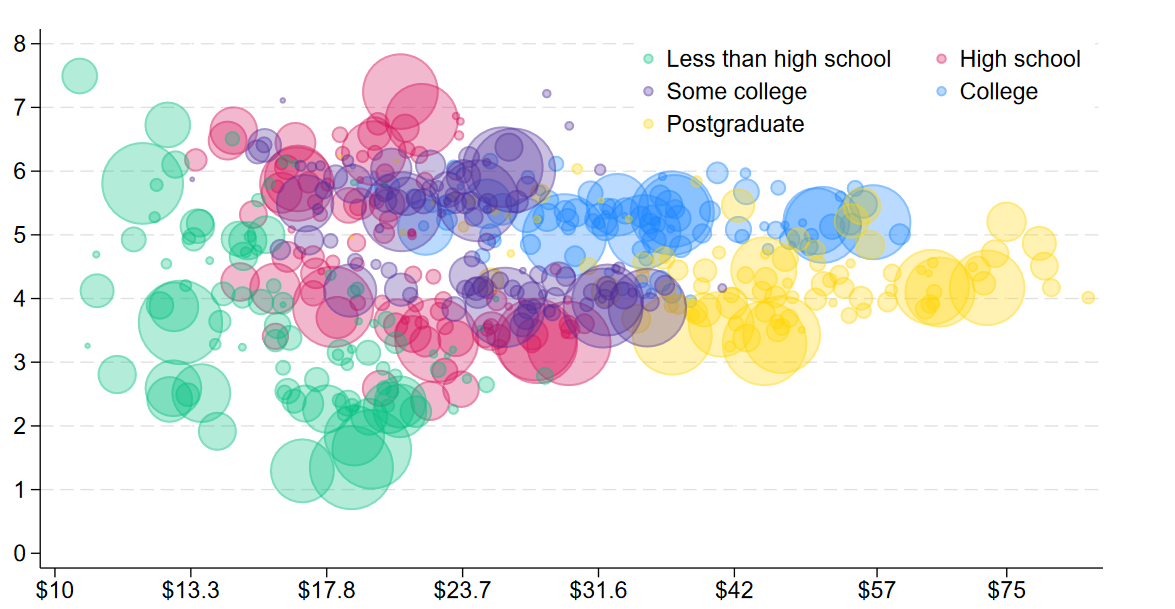

· Une transformation du marché du travail

Il est difficile d'évaluer précisément l'impact de ces technologies sur le marché du travail. Un consensus semble cependant se dégager : plus qu'un remplacement des emplois par l'IA, on va assister à une transformation des tâches et des métiers par ces technologies. L'ampleur et les modalités de ces transformations ne sont cependant pas mesurées de la même façon par toutes les études. Même si ces effets restent encore incertains, ils appellent un dialogue social pour accompagner les transitions. L'IA pourrait augmenter la productivité et parfois exacerber les inégalités, cela appelle une certaine vigilance.

Elle nécessite la mise en place de politiques publiques de formation initiale et de formation continue, dans le but d'anticiper les évolutions et d'accompagner les travailleurs. Des politiques de requalification ambitieuses sont indispensables.

C. LES DÉFIS CULTURELS ET SCIENTIFIQUES

· Une uniformisation cognitive

L'IA, dominée par des acteurs anglo-saxons, risque d'accentuer fortement l'hégémonie culturelle des États-Unis. Ce phénomène d'uniformisation culturelle appauvrit la diversité culturelle et linguistique, mais crée aussi une uniformisation cognitive. Le capitalisme cognitif qui repose sur la conjugaison des écrans et de l'IA conduit à une « économie de l'attention » préoccupante, notamment car elle enferme l'utilisateur des technologies dans des bulles de filtres. Cet enfermement informationnel polarise les visions de chacun dans des croyances subjectives. Ce sont autant de prisons mentales qui se déclinent à l'échelle individuelle. Cette tendance n'est que d'apparence paradoxale : on assiste, dans le même temps, à une polarisation marquée des opinions et des identités (selon les variables de la culture américaine, avec une forte dimension émotionnelle) et à une uniformisation culturelle doublée d'une uniformisation cognitive.

Ces conséquences de l'IA, des écrans et du numérique sur la cognition doivent nous mobiliser, surtout en direction des jeunes générations et des petits enfants, particulièrement victimes de ces impacts cognitifs, et ce de manière irréversible. L'éducation au numérique en général et à l'IA en particulier est une urgence impérieuse pour la cohésion de nos sociétés et la santé de chacun.

La France doit défendre sa langue et ses spécificités culturelles face à des systèmes d'IA comme les grands LLM qui privilégient l'anglais et la culture américaine sur un plan linguistique et culturel. Nous ne devons pas donner notre langue à ChatGPT ! Il faut conserver la diversité linguistique et culturelle de l'humanité. La France a besoin de modèles d'IA les plus souverains possibles, reflétant sa culture, entraînés avec des données qui la reflètent fidèlement et qui mobilisent des sources issues de son riche patrimoine culturel et linguistique.

Par ailleurs, si les raisonnements par induction, probabilistes, sont prometteurs et donnent souvent des résultats impressionnants, ils tendent à faire oublier le grand intérêt des raisonnements déductifs, sur lesquels s'est construite la plus grande partie des connaissances scientifiques. La généralisation de cas particuliers sous l'effet des données massives traitées par l'IA connexionniste est devenue la règle, or le résultat d'une inférence suivant un raisonnement inductif, même fondé sur des milliards d'exemples, peut toujours être démenti par un ou plusieurs contre-exemples.

Les deux formes de raisonnement - déductif et inductif - doivent continuer à cohabiter de manière plus équilibrée sans quoi cette ère de l'IA et du Big Data va conduire tous les habitants de la planète à penser selon le même mode, non seulement, sans le savoir, avec les mêmes cadres en termes de références culturelles, mais aussi selon les mêmes structures cognitives, tournées vers l'induction.

· Propriété intellectuelle et création artistique

L'IA mobilise des données protégées par le droit d'auteur ou par le copyright. Les artistes et les créateurs sont confrontés à des questions inédites relatives aux droits d'auteur et à leurs modèles économiques. Par exemple, les oeuvres générées par IA peuvent brouiller les frontières entre originalité et imitation, remettant en question les régimes traditionnels de protection de la propriété intellectuelle. Une réflexion doit s'ouvrir sur le sujet de la propriété intellectuelle et de la création artistique à l'heure de l'intelligence artificielle. Dans ce contexte d'incertitudes, les risques contentieux sont de plus en plus grands, qu'il s'agisse de l'utilisation d'oeuvres protégées pour entraîner les modèles, de la protection des oeuvres générées par des systèmes d'IA ou de tout autre litige qui pourrait émerger. En l'absence de règles claires, il reviendra aux juges de trancher les litiges. Le rôle de la jurisprudence sera donc central et laisse les artistes, les entreprises et les utilisateurs dans un flou juridique anxiogène, avec des risques financiers potentiellement non négligeables. C'est pourquoi une clarification de ces enjeux et des régimes juridiques applicables est indispensable.

· Une révolution scientifique

Dans le domaine scientifique, l'IA fertilise les autres disciplines et ouvre des perspectives immenses, comme en témoignent les exemples de la génomique, de la modélisation du repliement des protéines ou de la création de jumeaux numériques. Ces avancées permettront de résoudre de plus en plus de problèmes complexes et d'accélérer les découvertes. Il n'est pas anodin que les prix Nobel 2024 de Physique et de Chimie soient l'un et l'autre revenus à des chercheurs en IA. Les bénéfices potentiels de ces technologies nécessitent une adaptation de nos politiques de recherche.

Si l'intelligence artificielle est porteuse d'immenses opportunités, elle implique aussi de relever des défis complexes. L'IA soulève plusieurs questions éthiques, ce qui renvoie au thème de son alignement : comment garantir que l'IA s'aligne sur nos valeurs, respecte les droits de l'homme et les principes humanistes ? Il est à cet égard crucial de partager des bonnes pratiques, d'élaborer des cadres réglementaires, de renforcer la souveraineté technologique, et surtout d'éduquer nos sociétés aux enjeux de ces technologies. Ces perspectives nécessitent une gouvernance internationale pour encadrer les développements en cours et anticiper d'éventuels risques.

III. LA GOUVERNANCE ET LA RÉGULATION DE L'INTELLIGENCE ARTIFICIELLE

Plusieurs initiatives ont été prises en matière de régulation de l'IA, à l'échelle de chaque pays à travers des stratégies nationales en IA, ainsi qu'au niveau international.

A. UNE STRATÉGIE NATIONALE POUR L'IA EN DEMI-TEINTE

Depuis 2017, la France a tenté de structurer une stratégie nationale mais le plan « France IA » lancé en janvier 2017 a été rapidement abandonné.

Un an plus tard, sur la base d'un rapport émanant de l'ancien président de l'Office, Cédric Villani, le Président de la République a annoncé le 29 mars 2018 une « stratégie nationale et européenne pour l'intelligence artificielle », qui visait à faire de la France un leader mondial en IA.

Cette stratégie a permis la labellisation de quatre Instituts Interdisciplinaires en Intelligence artificielle (3IA), le financement de chaires et de doctorats ainsi que l'investissement dans des infrastructures de calcul comme les supercalculateurs Jean Zay, inauguré en 2019, et Adastra, inauguré en 2023, et dont les performances atteignent respectivement 36,85 pétaflops et 74 pétaflops (Jean Zay devrait toutefois atteindre 125,9 pétaflops à la fin de cette année).

À titre de comparaison, l'entreprise d'Elon Musk xAI qui développe le système Grok s'est dotée du supercalculateur Colossus développant 3,4 exaflops, composé de 100 000 processeurs Nvidia Hopper 100. Sa taille devrait doubler d'ici quelques mois pour atteindre 200 000 processeurs. Le supercalculateur Jean Zay, après son extension prévue d'ici la fin de l'année 2024, sera quant à lui doté de 1 456 puces Nvidia Hopper 100.

D'autres limites de cette stratégie nationale en IA sont notamment relevées par la Cour des comptes dans un rapport d'avril 2023 qui fait apparaître :

- des résultats insuffisants, la France ayant continué à décrocher au niveau international depuis 2018 ;

- une coordination interministérielle insuffisante.

Le pilotage de la stratégie nationale en IA reste toujours défaillant en 2024 : le coordinateur rattaché initialement à la direction interministérielle du numérique et des systèmes d'information et de communication (DINSIC), puis à la direction générale des entreprises (DGE) du ministère de l'économie, est sans autorité réelle sur la stratégie et sa mise en oeuvre. L'instabilité du titulaire de cette fonction et les vacances répétées du poste témoignent d'une mauvaise définition du rôle de ce coordinateur national. La stratégie demeure en réalité sans pilote, évoluant au gré des annonces de l'exécutif et des événements organisés autour de l'IA.

La Commission de l'intelligence artificielle a proposé en 2024 un investissement massif de 27 milliards d'euros sur cinq ans pour la formation, la recherche, et le développement d'un écosystème robuste en IA. La mise à disposition de sommes aussi conséquentes pour la stratégie nationale en IA semble peu probable. Lors du rassemblement des plus grands talents français de l'IA à l'Élysée le 21 mai 2024, le Président de la République a annoncé un plan d'investissement de 400 millions d'euros pour financer neuf pôles d'excellence en IA, comprenant les quatre anciens Instituts 3IA, l'objectif étant de passer de 40 000 à 100 000 personnes formées à l'IA par an. Il pourrait être judicieux de commencer par reconduire le programme Confiance.ai, peu coûteux pour les finances publiques (3,75 millions d'euros par an).

B. LES COMPARAISONS INTERNATIONALES ET LES PROJETS DE GOUVERNANCE MONDIALE DE L'IA

Le rapport décrit près de vingt autres stratégies nationales, six mises en place dans l'Union européenne et onze dans le reste du monde.

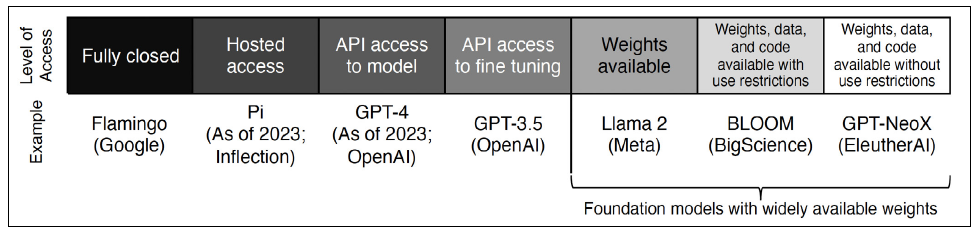

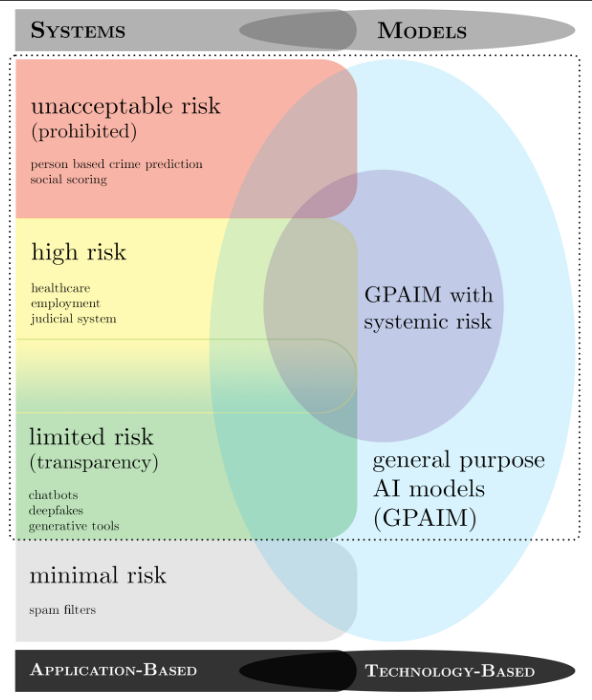

La réglementation de l'Union européenne, complexe et peu propice à l'innovation, est analysée en détail dans le rapport. L'AI Act conjugue un dispositif régulant les usages de l'IA selon leur niveau de risque et un encadrement des modèles d'IA selon leur puissance.

Le rapport recense également toutes les initiatives ayant pour objet une gouvernance mondiale de l'IA. On en compte une dizaine, ce qui n'est pas efficace : les projets de l'ONU, de l'Unesco, de l'OCDE, du Conseil de l'Europe, du G20, du G7, du Partenariat mondial sur l'intelligence artificielle (PMIA) (ou Global partnership on artificial intelligence - GPAI), du Conseil du commerce et des technologies (CCT) UE-États-Unis, du Forum économique mondial, des BRICS, de la Chine, etc., s'accumulent.

Ceci plaide pour une convergence autour d'une régulation internationale unique.

Le rapport met en évidence des efforts nationaux inégaux pour réguler l'IA, tout en soulignant le besoin d'une approche la plus coordonnée possible.

Le prochain sommet sur l'IA qui sera organisé par la France en 2025 sera une bonne occasion de promouvoir une gouvernance mondiale cohérente pour aborder les enjeux de l'IA dans leur globalité, sans se limiter au sujet de la sécurité.

L'Office a un rôle à jouer dans cette révolution technologique, pour aider le gouvernement à structurer sa propre stratégie, mais aussi pour contribuer à cette future gouvernance mondiale de l'IA.

IV. LES PROPOSITIONS DE L'OFFICE

Le rapport propose 18 recommandations, dont cinq sont consacrées à la préparation du futur sommet de l'IA qui se tiendra à Paris les 10 et 11 février prochain.

LES PROPOSITIONS À SOUTENIR DANS LE CADRE DU FUTUR SOMMET DE L'IA

1°. Faire reconnaître le principe d'une approche transversale de l'IA et renoncer à l'approche exclusivement tournée vers les risques

Cinq thèmes seront l'objet du sommet (l'IA au service de l'intérêt public avec la question des infrastructures ouvertes ; l'avenir du travail ; la culture ; l'IA de confiance ; et la gouvernance mondiale de l'IA). Il faudra que le sommet aille plus loin et permette d'inscrire solennellement le principe d'une approche transversale des enjeux de l'IA au sein d'une déclaration des participants. Les cinq thèmes retenus pour le sommet éludent deux dimensions qu'il faudrait prendre en compte de manière prioritaire :

- l'éducation, qui pourrait être ajoutée à la verticale culture avec pour intitulé « éducation et culture » ;

- la souveraineté numérique, qui pourrait être ajoutée à la verticale « l'IA au service de l'intérêt public » avec pour intitulé « souveraineté numérique et intérêt général ».

2°. Proposer de placer la gouvernance mondiale de l'IA sous l'égide d'une seule organisation internationale

Le sommet doit être l'occasion de clarifier et rationaliser la dizaine de projets visant à créer une gouvernance mondiale de l'IA. Aussi, il est proposé de placer la gouvernance mondiale de l'IA sous l'égide d'une seule organisation internationale, à savoir l'ONU, seule organisation pleinement légitime sur le plan multilatéral.

3°. Initier le cadre d'une régulation globale et multidimensionnelle de l'IA en s'inspirant des travaux de l'OCDE et de l'UE

L'approche de la régulation mondiale de l'IA doit être multidimensionnelle, afin de traiter la question de l'ensemble de la chaîne de valeur de l'IA et comme le montrent les travaux de l'OCDE et de l'UE.

4°. Annoncer un programme européen de coopération en IA

Ce programme doit associer plusieurs pays dont au moins la France, l'Allemagne, les Pays-Bas, l'Italie et l'Espagne, ces pays partageant une vision similaire de l'IA et de ses enjeux.

5°. Associer plus étroitement le Parlement à son organisation

Afin de garantir une plus grande légitimité du futur sommet, l'Office demande que le Parlement soit plus étroitement associé à son organisation. La présence d'un député et d'un sénateur au sein du comité de pilotage du sommet serait un gage de crédibilité. Elle marquerait l'attention portée par les pouvoirs publics à l'indispensable dimension démocratique d'un encadrement de l'IA à l'échelle internationale.

LES PROPOSITIONS EN FAVEUR D'UNE VÉRITABLE POLITIQUE NATIONALE DE L'IA

6°. Développer une filière française ou européenne autonome sur l'ensemble de la chaîne de valeur de l'intelligence artificielle

Un objectif doit mobiliser les pouvoirs publics nationaux et locaux, les décideurs économiques, les associations et les syndicats : viser le développement d'une filière française ou européenne autonome sur l'ensemble de la chaîne de valeur de l'intelligence artificielle, même sans chercher à rivaliser avec les puissances américaine et chinoise.

En effet, mieux vaut une bonne IA chez soi qu'une très bonne IA chez les autres. Que ce soit au niveau européen, dans le cadre de l'UE ou avec une coopération renforcée entre quelques pays, ou directement au niveau national, la France doit relever ce défi de construire pour elle, en toute indépendance, les nombreux maillons de la chaîne de valeur de l'intelligence artificielle.

7°. Mettre en place une politique publique de l'IA avec des objectifs, des moyens et des outils de suivi et d'évaluation

Pour être efficace, la stratégie nationale pour l'IA ne peut se passer d'objectifs clairement définis, de moyens réels dont une gouvernance digne de ce nom, et d'outils de suivi et d'évaluation. Ces éléments sont aujourd'hui cruellement absents des politiques publiques menées en France en matière d'IA. Plus largement, la politique de la Start-up Nation avec son bras armé la French Tech, trop élitiste et souvent inadaptée, est à abandonner au profit d'une politique de souveraineté numérique, cherchant à construire notre autonomie stratégique et à mailler les territoires.

8°. Organiser le pilotage stratégique de la politique publique de l'IA au plus haut niveau

La stratégie nationale pour l'IA ne dispose pas d'une gouvernance digne de ce nom, il faudra mieux coordonner la politique publique nationale de l'intelligence artificielle et lui donner une réelle dimension interministérielle.

9°. Former les élèves de l'école à l'Université, former les actifs et former le grand public à l'IA

Il est indispensable de lancer de grands programmes de formation à l'IA à destination des scolaires, des collégiens, des lycéens, des étudiants, des actifs et du grand public. Les politiques conduites en ce domaine par la Finlande sont des modèles à suivre. La démystification de l'IA est une première étape importante et nécessaire pour favoriser la diffusion de la technologie.

10°. Accompagner le déploiement de ces technologies dans le monde du travail et la société, notamment par la formation permanente

S'il est difficile de prévoir l'impact précis que l'IA aura sur le marché du travail, il faut tout de même accompagner le déploiement de ces technologies, notamment l'IA générative, dans le monde du travail, en particulier par des programmes de formation permanente ambitieux. Des études qualitatives et quantitatives sur l'impact de l'IA sur l'emploi, le tissu social (dont les inégalités) et les structures cognitives devront également être régulièrement menées.

11°. Lancer un grand dialogue social autour de l'intelligence artificielle et de ses enjeux

Le dialogue social par la négociation collective peut être renouvelé par l'introduction de cycles de discussions tripartites autour de l'IA et de ses enjeux. Une opération d'envergure nationale, comme un Grenelle de l'IA, pourrait également être organisée. Le dialogue social autour de l'IA devra se décliner dans les entreprises pour permettre une meilleure diffusion des outils technologiques et un rapport moins passionné à leurs conséquences.

12°. Mobiliser et animer l'écosystème français de l'IA

Tous les acteurs de l'IA, la recherche publique et privée, les grands déployeurs de systèmes mais aussi l'ensemble des filières économiques doivent s'insérer dans une grande mobilisation générale. Le rapport préconise aussi des pôles d'animation régionaux. Des expériences étrangères peuvent être des sources d'inspiration comme la structure NL AI Coalition, créée par le gouvernement néerlandais, qui rassemble depuis cinq ans l'écosystème public et privé de l'IA aux Pays-Bas, avec le concours du patronat, des universités et des grands centres de recherche. Elle s'appuie sur sept centres régionaux.

13°. Reconduire le programme « Confiance.ai » ou mettre en place un projet équivalent

Le programme « Confiance.ai » réunissait dans une logique partenariale de grands acteurs académiques et industriels français dans les domaines critiques de l'énergie, de la défense, des transports et de l'industrie et avait pour mission de permettre aux industriels d'intégrer des systèmes d'IA de confiance dans leurs process. Il ne coûtait pas cher et était efficace. Or il s'est interrompu en 2024. Il est proposé de le reconduire ou de mettre en place un projet équivalent.

14°. Soutenir la recherche publique en intelligence artificielle selon des critères de transversalité et de diversification des technologies

La recherche privée en intelligence artificielle a pris beaucoup d'avance sur la recherche publique, mais cette dernière doit revenir dans la course. La soutenir davantage est un impératif. L'Office juge pertinent de l'orienter vers des activités transdisciplinaires et, plus globalement, transversales autour de « projets de recherche » en IA.

La diversification des technologies est également fondamentale : les avancées en IA se font par la combinaison et la recomposition de savoirs et de savoir-faire, pas par l'enfermement dans un modèle unique.

Par exemple, l'IA symbolique ne doit pas être abandonnée, elle peut s'hybrider avec les IA connexionnistes pour forger de nouvelles approches logiques, imbriquant le signifiant et le signifié, plus proches des raisonnements humains.

D'autres technologies permettant d'apporter plus de logique aux systèmes d'IA générative peuvent également inspirer de nouvelles perspectives pour la recherche, comme les modèles Mixture of Experts (MoE), des modèles de représentation du monde (World Models), la génération augmentée de récupération ou Retrieval Augmented Generation (RAG) ou encore les arbres de pensées ou Trees of Thoughts (ToT).

Pour paraphraser Rabelais qui écrivait que « Science sans conscience n'est que ruine de l'âme », on peut affirmer que « l'IA sans logique n'est qu'illusion d'intelligence ».

15°. Relever le défi de la normalisation en matière d'intelligence artificielle

Il faut permettre à la France de défendre au mieux l'intérêt national ainsi que les intérêts de ses entreprises nationales en matière de normalisation de l'IA, ce qui implique de mobiliser davantage l'Afnor et le Cofrac.

La France doit également inviter ses partenaires européens à faire preuve d'une plus grande vigilance dans le choix de leurs représentants dans les comités responsables de la normalisation en IA : s'appuyer sur des experts issus d'entreprises extra-européennes, le plus souvent américaines ou chinoises, n'est pas acceptable.

16°. S'assurer du contrôle souverain des données issues de la culture française et des cultures francophones et créer des bases de données autour des cultures francophones

Il s'agit d'un acte de résistance face à la domination linguistique et culturelle américaine, qui caractérise l'IA aujourd'hui et qui fait courir un risque grave d'uniformisation culturelle et d'appauvrissement linguistique. Les initiatives conduites par certains pays, en particulier l'Espagne, peuvent inspirer notre pays.

17°. Préparer une réforme des droits de propriété intellectuelle, dont le droit d'auteur, pour les adapter à l'IA et surtout aux usages de l'IA générative

L'objectif d'une telle réforme sera à la fois de clarifier les régimes juridiques applicables, de protéger les ayants droit des données ayant servi à l'entraînement des modèles mais aussi les créateurs d'oeuvres nouvelles grâce à l'IA.

18°. Confier à l'OPECST le suivi et l'évaluation régulière de la politique publique conduite par le Gouvernement

Les aspects scientifiques et technologiques de l'intelligence artificielle ainsi que les enjeux qu'ils soulèvent appellent une expertise à la croisée des mondes politique et scientifique, ce qui est la mission de l'OPECST. C'est pourquoi, comme l'avait d'ailleurs proposé la commission des lois de l'Assemblée nationale dans un rapport, il semble judicieux de confier à l'OPECST le suivi permanent des questions relatives à l'intelligence artificielle.

AVANT-PROPOS

Le présent rapport répond à une saisine de l'Office par les bureaux de l'Assemblée nationale et du Sénat en juillet 2023, ce qui est exceptionnel1(*). Il s'agissait de manifester un soutien au plus haut niveau des deux assemblées aux travaux de l'OPECST à l'occasion de son 40e anniversaire. Quatre rapporteurs ont été désignés le 26 octobre 2023 dans une composition doublement paritaire : deux députés et deux sénateurs, deux femmes et deux hommes. Ils représentaient, de plus, la diversité de l'éventail politique national.

Le présent rapport n'est pas le premier travail de l'Office sur le thème de l'intelligence artificielle : en 2016 et 2017, nos anciens collègues Claude de Ganay et Dominique Gillot ont ainsi conduit des investigations très poussées sur ce sujet d'intérêt capital. Le rapport pionnier qu'ils ont rendu au nom de l'Office2(*) a marqué l'histoire des analyses relatives à ces technologies et il y sera parfois renvoyé dans le cadre des développements du présent rapport.

Ce rapport exigeait, dans une modernité notable face à l'évolution rapide de ces techniques et du vocabulaire qui leur est associé, que l'ensemble de ces technologies soient en effet « maîtrisées, utiles et fassent l'objet d'usages conformes à nos valeurs humanistes »3(*) : même si le fait de concevoir des machines réellement intelligentes restait surtout selon eux une préoccupation de long terme, la « question de savoir comment aligner les valeurs de ces machines avec les valeurs morales humaines mérite d'être posée dès aujourd'hui » disaient très sagement nos collègues.

Leur rapport a même apporté quelques réponses solides et argumentées à la question tout en précisant que ses préconisations devraient être « remises en débat au fur et à mesure des nouvelles découvertes scientifiques, de leurs transferts et de leurs usages ». Les deux rapporteurs tenaient surtout à ce que « le point d'équilibre qu'ils ont cherché à atteindre dans leur rapport puisse évoluer, en fonction des évolutions du contexte résultant du jeu de ces variables »4(*).

Parmi les 15 propositions de ce rapport en mars 2017 figurait, par exemple, le fait de :

- favoriser des algorithmes et des robots sûrs, transparents et justes ;

- prévoir une charte de l'intelligence artificielle et de la robotique ;

- confier à un institut national de l'éthique de l'intelligence artificielle et de la robotique un rôle d'animation du débat public sur les principes éthiques qui doivent encadrer ces technologies ;

- encourager la constitution de champions européens en intelligence artificielle et en robotique ;

- redonner en IA une place essentielle à la recherche fondamentale et revaloriser la place de la recherche publique par rapport à la recherche privée ;

- mobiliser la communauté française de la recherche en intelligence artificielle ;

- accompagner les transformations du marché du travail en menant une politique de formation continue ambitieuse visant à s'adapter aux exigences de requalification et d'amélioration des compétences ;

- élargir l'offre de cursus et de modules de formation aux technologies d'intelligence artificielle dans l'enseignement supérieur et créer, en France, au moins un pôle d'excellence international et interdisciplinaire en IA ;

- former à l'éthique de l'intelligence artificielle et de la robotique dans les cursus spécialisés de l'enseignement supérieur :

- former à l'informatique dans l'enseignement primaire et secondaire ;

- former et sensibiliser le grand public à l'intelligence artificielle et à ses conséquences pratiques ;

- assurer une meilleure prise en compte de la diversité et de la place des femmes dans la recherche en intelligence artificielle.

Ces propositions, quand elles n'ont pas encore été traduites dans les faits, restent d'actualité.

Le dernier point a, par exemple, justifié l'organisation au Sénat d'une audition sur la place des femmes dans l'intelligence artificielle, le 7 mars 2024, au cours de laquelle on s'est demandé pourquoi on dénombrait si peu de femmes dans les métiers de l'IA5(*).

Le présent rapport répond à une saisine assez précise puisqu'il s'agit de traiter des « nouveaux développements » de l'IA, ceux intervenus en particulier depuis le premier rapport de 2017.

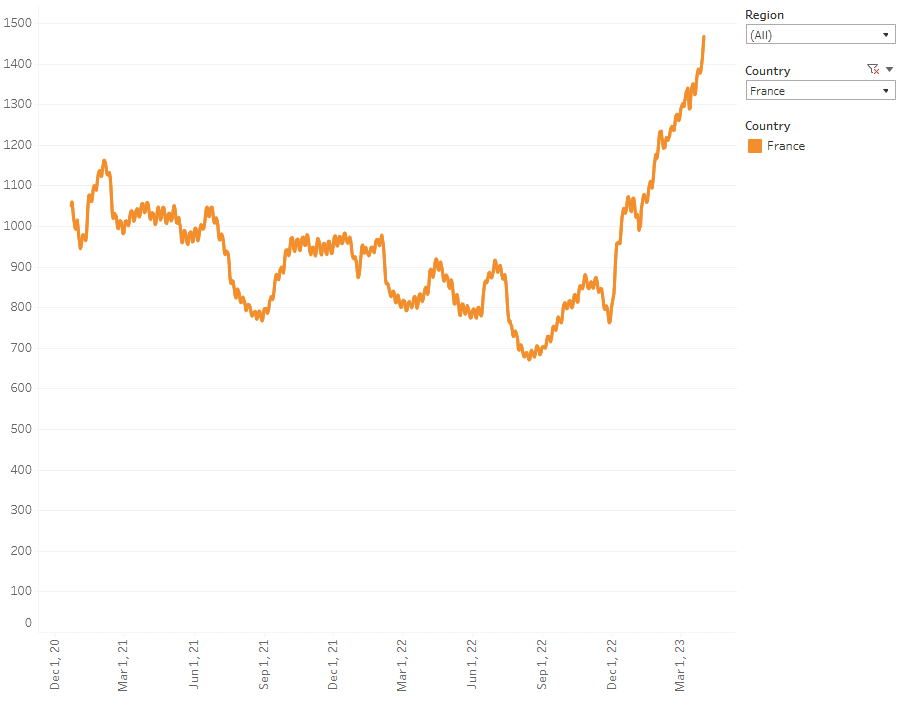

Et de nouveaux développements, il y a eu. Les innovations s'accélèrent trimestre après trimestre. Depuis quelques années, on observe en effet que les cycles de révolution en IA sont en moyenne de trois mois.

En septembre 2017, quelques mois après la publication du rapport de l'OPECST, une nouvelle architecture d'intelligence artificielle était ainsi proposée par des chercheurs de Google : les Transformers. Ces algorithmes, comprenant des centaines de milliards voire des milliers de milliards de paramètres sont devenus des systèmes d'IA générative accessibles au grand public et ont notamment abouti à des applications populaires telles que ChatGPT, lancée en novembre 2022 et à laquelle le titre du rapport fait un clin d'oeil appuyé en se demandant ce qui se joue au-delà de cette application en elle-même.

Ces technologies, capables de générer du texte, des images ou d'autres contenus en réponse à des commandes en langage naturel (ou prompts en anglais), représentent une nouvelle étape significative dans la longue histoire de l'intelligence artificielle et posent de nouvelles questions à nos sociétés.

Si c'est au milieu du XXe siècle, en même temps que l'informatique, que se développe et qu'apparaît formellement la notion d'intelligence artificielle, il ne fait aucun doute que les sept dernières années ont marqué une étape fondamentale dans les progrès de ces technologies. Ce constat valide près de 80 ans après le propos de Georges Bernanos placé en ouverture liminaire du présent rapport, qui nous rappelle avec un ton mi-positiviste, mi-nostalgique, que « le progrès n'est plus dans l'homme, il est dans la technique, dans le perfectionnement des méthodes capables de permettre chaque jour une utilisation plus efficace du matériel humain »6(*). À l'heure des IA génératives, cette phrase nous a semblé faire écho à la riche actualité de ces systèmes de plus en plus présents dans nos vies et dans nos sociétés.

Après le premier rapport de l'Office sur l'IA rendu public en mars 2017, il est nécessaire de remettre l'ouvrage sur le métier pour analyser le fonctionnement de ces nouvelles IA et leurs défis, sans chercher à récapituler tous leurs domaines d'application et leurs cas d'usage, qui sont innombrables.

Cette nécessité apparaît d'autant plus grande que très peu de travaux parlementaires sont consacrés à l'intelligence artificielle. Outre le rapport de l'Office précité, on peut relever un ensemble de travaux de la délégation à la prospective du Sénat7(*) et le rapport d'information de la commission des lois de l'Assemblée nationale déposé le 14 février 2024 en conclusion des travaux de sa mission d'information sur les défis de l'intelligence artificielle générative en matière de protection des données personnelles et d'utilisation du contenu généré dont les rapporteurs étaient nos collègues députés Philippe Pradal et Stéphane Rambaud8(*). Deux autres rapports établis au nom de la commission des affaires européennes du Sénat et proposant des résolutions en réponse à la stratégie européenne pour l'intelligence artificielle de la Commission européenne en 20199(*) et à la proposition de règlement européen sur l'intelligence artificielle en 202310(*) peuvent aussi être mentionnés. En outre, la commission des lois du Sénat a mis en place une mission d'information sur le point de rendre un rapport sur l'impact de l'IA sur les professions du droit11(*).

Vos rapporteurs ont voulu fournir des éléments de réponse à plusieurs interrogations. Comment fonctionnent ces technologies, en particulier les IA génératives ? Quels avantages et quels inconvénients présentent-elles ? Quels biais persistent dans l'usage des données et dans les programmations ? Posent-elles des difficultés en termes de souveraineté, de sécurité ou de régulation ? Quelles gouvernances nationales, européennes voire internationales sont mises en place ? Faut-il faire évoluer ces cadres de régulation ? Si oui, dans quelles directions ? Comment la France doit-elle se positionner par rapport à ces enjeux de gouvernance et par rapport aux évolutions technologiques et économiques en cours ? Et quelles perspectives la recherche permet-elle de dessiner pour le futur ? Va-t-on vers l'intelligence artificielle générale (IAG), voire vers une IA qui nous serait même supérieure ? Dans cette perspective, appelée singularité, devons-nous considérer que nous aurons à faire face à un risque existentiel ?

PREMIÈRE PARTIE

COMPRENDRE LES TECHNOLOGIES

D'INTELLIGENCE ARTIFICIELLE

Vos rapporteurs ont jugé indispensable, pour traiter des nouveaux développements de l'IA depuis 2017, de retracer tout d'abord l'histoire de ces technologies, en mettant l'accent sur leur fonctionnement ainsi que sur le contenu et les contours du concept d'IA.

Avant même d'évoquer l'histoire de l'intelligence artificielle, il est proposé de reconstruire brièvement sa préhistoire.

Cette archéologie du savoir - pour reprendre la démarche de Michel Foucault - est utile en ce qu'elle permet d'identifier l'ensemble des représentations et des enjeux qui relèvent de ces technologies, en particulier d'un point de vue culturel. Ces perceptions traditionnelles de l'IA, qui peuvent être certes différentes de la réalité effective de ces technologies, influencent du reste la façon dont ces dernières sont conçues.

Ainsi que l'exprimait Marie Curie « dans la vie, rien n'est à craindre, tout est à comprendre », alors plutôt que de s'épouvanter en débattant des risques que ferait courir l'IA, il est en effet primordial en suivant l'invite de Marie Curie (un prompt dirait-on en anglais) de commencer par chercher à comprendre ce que recouvre exactement la notion d'intelligence artificielle et d'appréhender avec rigueur le fonctionnement de ces technologies complexes.

C'est là tout l'objet de cette première partie.

I. HISTOIRE DE LA NOTION D'INTELLIGENCE ARTIFICIELLE

A. LA PRÉHISTOIRE DE L'INTELLIGENCE ARTIFICIELLE ET SES REPRÉSENTATIONS CULTURELLES

En 2021, a été mis en place un séminaire pluridisciplinaire autour de l'histoire culturelle de l'intelligence artificielle12(*), quelques années après le rapport précité de l'OPECST qui, en 2017, jugeait nécessaire, pour mieux comprendre les IA modernes, de les replacer dans le contexte des incarnations de l'intelligence artificielle qui ont jalonné notre longue histoire, qu'il s'agisse de mythes anciens ou de projets imaginés par des écrivains et des scientifiques13(*).

Le Conseil d'État explique dans une étude sur l'IA14(*) que « la très forte charge symbolique de l'expression intelligence artificielle, ainsi que l'absence de définition partagée et de consensus sur le contenu même de la notion, contribuent puissamment à la confusion et compliquent l'examen rationnel des avantages et des inconvénients de ce qui est, d'abord et avant tout, un ensemble d'outils numériques au service de l'humain ». Démystifier l'IA impose de déconstruire les apports culturels ayant produit la cristallisation de cette très forte charge symbolique.

1. De la mythologie antique aux machines à calculer

Il est fait mention dès l'Égypte ancienne de statues articulées, animées par la vapeur et par le feu, qui hochaient la tête et bougeaient les bras, véritables ancêtres des automates. Homère a décrit dans L'Iliade des servantes en or douées de raison : « Fabriquées par Héphaïstos, le dieu forgeron, elles ont, selon le poète, voix et force ; elles vaquent aux occupations quotidiennes à la perfection, car les immortels leur ont appris à travailler. Ce sont donc des robots, au sens étymologique de travailleurs artificiels » ainsi que le rappelle Jean-Gabriel Ganascia, entendu par vos rapporteurs. Ovide dans ses « Métamorphoses » crée la figure de Galatée, statue d'ivoire sculptée par Pygmalion et à laquelle Vénus, déesse de l'amour, accepte de donner vie. La Bible, par le Psaume 139:16, a fondé le mythe du Golem, cette créature d'argile humanoïde que l'on retrouve souvent dans la tradition cabalistique juive.

Parallèlement à ces développements mythologiques, la science tâtonne pendant des siècles mais pose tout de même des jalons concernant la future intelligence artificielle. Ces technologies d'IA sont filles des mathématiques et se basent sur des algorithmes15(*).

Le mot algorithme est issu de la latinisation du nom du mathématicien Al-Khawarizmi, dont le titre d'un des ouvrages (« Abrégé du calcul par la restauration et la comparaison »), écrit en arabe entre 813 et 833, est également à l'origine du mot algèbre. Il est le premier à proposer des méthodes précises de résolution des équations du second degré, du type « ax² + bx + c =0 ».

La longue histoire des algorithmes est bien décrite par Serge Abiteboul et Gilles Dowek, dans leur ouvrage Le temps des algorithmes. Ils y rappellent que les algorithmes sont utilisés depuis des milliers d'années : Euclide a inventé en l'an 300 avant notre ère un algorithme de calcul du plus grand diviseur commun de deux nombres entiers. Pour se représenter au sens familier ce qu'est un algorithme, il faudrait penser à une sorte de recette de cuisine : en suivant une série d'instructions, un ensemble d'ingrédients (les inputs) permettent de parvenir à un plat précis (les outputs).

En 1495, en vue de festivités organisées à Milan, Léonard de Vinci imagine puis construit, bien que ce dernier point reste débattu, un « chevalier mécanique », sorte de robot automate revêtu d'une armure médiévale. Sa structure interne en bois, avec quelques parties en métal et en cuir, était actionnée par un système de poulies et de câbles.

Avec ses « animaux-machines », René Descartes proposa, quant à lui, dans la première moitié du XVIIe siècle, de reproduire artificiellement les fonctions biologiques, y compris la communication et la locomotion. Blaise Pascal à 19 ans réfléchit à la création d'une machine à calculer mécanique et, trois ans plus tard, aboutit à la création en 1645 de sa « machine d'arithmétique », initialement désignée ainsi puis dénommée roue pascaline et, enfin, pascaline. Projet qu'il abandonnera tout comme ses autres entreprises scientifiques pour se consacrer à l'étude de la philosophie et à la religion16(*). À la fin du XVIIe siècle, Gottfried Leibniz imagine ensuite une machine à calculer capable de raisonner. Il construit lui aussi un prototype de machine à calculer en 1694, basée sur un cylindre cannelé17(*).

Pendant le siècle des Lumières, le philosophe français Julien de la Mettrie anticipe le jour où les progrès de la technique permettront de créer un homme-machine tout entier, à l'âme et au corps artificiels. L'abbé Mical et Kratzenstein imaginent une machine à parler en 1780, bientôt construite par le baron Von Kempelen grâce à une cornemuse à tuyaux multiples, aujourd'hui propriété du « Deutsches Museum » de Munich.

Au milieu du XIXe siècle, le logicien britannique George Boole appelle à mathématiser la logique en faisant du raisonnement déductif une série de calculs18(*), l'économiste britannique William Stanley Jevons inspiré par Boole imagine puis construit un piano mécanique capable de raisonner selon des prémisses de logique pure19(*) et, surtout, le mathématicien britannique Charles Babbage conçoit, avec sa « machine analytique », l'ancêtre mécanique des ordinateurs modernes20(*) en associant les inventions de Pascal et de Jacquard : à savoir, d'une part, la machine à calculer, d'autre part, les programmes des métiers à tisser inscrits sur des cartes perforées. C'est sur cette machine, qu'à 27 ans, Ada Lovelace écrit en 1842 le premier véritable programme informatique21(*), selon le calcul des nombres de Bernoulli, allant au-delà du simple calcul numérique. Celle que son père Lord Byron appelait, enfant, la princesse des parallélogrammes avait choisi, par passion pour les mathématiques, et dès ses 17 ans, de s'associer aux recherches de Babbage, dont elle travaillera à la promotion jusqu'à sa mort prématurée en 1852.

En 1870, dans son ouvrage ambitieux en deux volumes De l'Intelligence, Hippolyte Taine propose de traiter les facultés cognitives à travers des lois mathématiques comme on le ferait pour n'importe laquelle des sciences expérimentales, dont la physique. Pour lui, « la perception extérieure est une hallucination vraie » et « tous les problèmes concernant un être quelconque, moral ou physique, seraient au fond des problèmes de mécanique ».

2. Un thème traditionnel de la science-fiction

Dès 1818, Mary Shelley publie son roman « Frankenstein ou le Prométhée moderne », dans lequel elle imagine un savant capable de créer un être artificiel, le monstre Frankenstein. Jules Verne, dans son roman, La Maison à vapeur, paru en 1880, imagine un éléphant à vapeur géant capable de traverser l'Inde, sur terre, comme sur l'eau. Sa machine n'est cependant pas autonome.

Alors qu'Isaac Asimov affirmait que l'« on peut définir la science-fiction comme la branche de la littérature qui se soucie des réponses de l'être humain aux progrès de la science et de la technologie », force est de constater que l'intelligence artificielle est un thème de science-fiction particulièrement fécond pour la littérature, le cinéma et les jeux vidéo.

Dans le célèbre roman Erewhon de Samuel Butler, paru en 1872, en particulier dans les trois chapitres qui forment The Book of the Machines, les machines sont douées d'une intelligence comparable à celle des êtres humains et risquent de nous dépasser. Quelques années plus tôt, sous le pseudonyme de Cellarius, dans un article publié le 13 juin 1863 dans le journal néo-zélandais The Press et intitulé « Darwin among the Machines », il jugeait inéluctable qu'à long terme « les machines détiendront la réelle suprématie sur le monde et ses habitants, c'est ce qu'aucune personne d'un esprit vraiment philosophique ne peut un instant remettre en question »22(*). Il concluait en appelant à la destruction de toutes les machines dans cette guerre à mort.

En 1920, le terme « robot » apparaît avec la pièce de théâtre de science-fiction de Karel Èapek « R. U. R. Rossum's Universal Robots », ce néologisme ayant été créé par son frère Josef à partir du mot tchèque robota qui signifie travail. Arthur C. Clarke met l'ordinateur CARL au centre de l'intrigue de ses romans La Sentinelle, en 1951, À l'aube de l'histoire, en 1953, et 2001, L'Odyssée de l'espace, en 1968.

L'un des pères fondateurs de l'IA, Marvin Minsky en l'occurrence, servit d'ailleurs de conseiller à Stanley Kubrick et à Arthur C. Clarke pour l'adaptation de ces romans au cinéma, avec l'une des premières apparitions de l'IA dans la culture populaire : l'ordinateur CARL rebaptisé HAL 9000, dans le film 2001 : l'Odyssée de l'espace, sorti en 1968. Dans ce film, la communication avec l'ordinateur passe par une interface de synthèse vocale qui permet d'interagir avec le système par le langage naturel. Son nom correspond à un rétrodécalage de chacune des lettres d'IBM et l'acronyme signifie Heuristically programmed ALgorithmic Computer, dont on serait à la version 9000.

Les nombreux ouvrages devenus des classiques d'Isaac Asimov et d'Arthur C. Clarke, mais aussi de Philip K. Dick, de William Gibson, de Frank Herbert, de Francis Rayer ou de Iain Banks, illustrent cet intérêt marqué de la science-fiction pour le thème de l'IA, intérêt qui se poursuit aujourd'hui comme en témoignent les romans de Becky Chambers ou d'Alain Damasio23(*).

L'intelligence artificielle est aussi omniprésente au cinéma, et ce depuis 1927, avec de nombreux films, comme par exemple, chronologiquement : « Metropolis », « 2001 : l'Odyssée de l'espace », « Le Cerveau d'acier », « THX 1138 », « Mondwest », « Les Femmes de Stepford », « Les Rescapés du futur », « Génération Proteus », « Star Wars », « Blade runner », « Alien », « Tron », « Wargames », « Terminator », « Virtuosity », « Matrix », « L'Homme bicentenaire », « A.I. », « I, Robot », « Iron Man », « Wall-E », « Eva », « The Machine », « Transcendance », « Chappie », « Her », « Ex Machina », « Ghost in the Shell », « Interstellar », ou, encore, « Ready Player One ».

Des séries télévisées comme « Lost in Space », « Star Trek : La Nouvelle Génération », « Battlestar Galactica », « K 2000 », « Person of interest », « Emma », « Westworld », « Silicon Valley », « Better than us », « Star Wars : The Clone Wars » ou, surtout, « Black Mirror », « Real Humans » et « Humans » ont également exploité ce sujet.