- AVANT-PROPOS

- QUELQUES DÉFINITIONS D'INTÉRÊT

GÉNÉRAL

- L'ESSENTIEL

- PREMIÈRE PARTIE

LES AVANCÉES MAJEURES PROMISES PAR L'IA DANS LA MOBILISATION DES DONNÉES ENVIRONNEMENTALES AU SERVICE DE LA TRANSITION ÉCOLOGIQUE

- I. L'IA POUR CONNAÎTRE L'ENVIRONNEMENT,

SIMULER ET PRÉDIRE

- A. LA CONNAISSANCE DE L'ENVIRONNEMENT

- B. LES POSSIBILITÉS AUGMENTÉES DE

SIMULATION ET DE PRÉDICTION

- A. LA CONNAISSANCE DE L'ENVIRONNEMENT

- II. L'IA POUR S'ADAPTER AUX ENJEUX ENVIRONNEMENTAUX

ET CONTRIBUER À LA DÉCARBONATION

- III. LA RECHERCHE SUR LES TECHNIQUES D'IA FRUGALE

POUR CONCILIER APPORT DE L'IA ET SOBRIÉTÉ NUMÉRIQUE

- I. L'IA POUR CONNAÎTRE L'ENVIRONNEMENT,

SIMULER ET PRÉDIRE

- DEUXIÈME PARTIE

UNE ACTION PUBLIQUE QUI SE STRUCTURE POUR FAVORISER L'ÉMERGENCE DE SOLUTIONS D'IA AU SERVICE DE L'ENVIRONNEMENT, MAIS DES ÉVOLUTIONS ENCORE TRÈS EXPLORATOIRES

- I. FAIRE ÉMERGER DES SOLUTIONS

D'« IA FOR GREEN » : UNE AMBITION DE L'ACTION

PUBLIQUE AUX NIVEAUX NATIONAL ET EUROPÉEN

- II. LE RECOURS AUX TECHNIQUES AVANCÉES

D'IA PAR LES OPÉRATEURS PUBLICS DANS LE DOMAINE DE

L'ENVIRONNEMENT : UNE ÉVOLUTION ENCORE EXPLORATOIRE

- I. FAIRE ÉMERGER DES SOLUTIONS

D'« IA FOR GREEN » : UNE AMBITION DE L'ACTION

PUBLIQUE AUX NIVEAUX NATIONAL ET EUROPÉEN

- TROISIÈME PARTIE

LES CONDITIONS DE RÉUSSITE DE L'IAAU SERVICE DE L'ENVIRONNEMENT : RENFORCER L'« EXPLOITABILITÉ » DES DONNÉES ET LA GOUVERNANCE, FAVORISER LA RECHERCHE ET TROUVER LE BON MODÈLE ÉCONOMIQUE

- I. FAVORISER LA DISPONIBILITÉ ET LA

QUALITÉ DE LA DONNÉE POUR L'IA

- II. RENFORCER LA COORDINATION DANS LA GOUVERNANCE

EN MATIÈRE D'IA POUR L'ENVIRONNEMENT

- III. CHERCHER LA MEILLEURE ORIENTATION POSSIBLE

DES SUJETS DE RECHERCHE SUR L'IA POUR L'ENVIRONNEMENT

- IV. TROUVER LE BON MODÈLE

ÉCONOMIQUE

- I. FAVORISER LA DISPONIBILITÉ ET LA

QUALITÉ DE LA DONNÉE POUR L'IA

- EXAMEN EN DÉLÉGATION

- LISTE DES PERSONNES ENTENDUES ET DES

CONTRIBUTIONS ÉCRITES

N° 379

SÉNAT

SESSION ORDINAIRE DE 2024-2025

Enregistré à la Présidence du Sénat le 20 février 2025

RAPPORT D'INFORMATION

FAIT

au nom de la délégation

sénatoriale à la prospective (1)

sur

« IA et

environnement »,

Par M. Jean-Baptiste BLANC, Mmes Nadège HAVET

et

Christine LAVARDE,

Sénateurs et Sénatrice

(1) Cette délégation est composée de : Mme Christine Lavarde, président ; MM. Christian Bruyen, Guislain Cambier, Mme Cécile Cukierman, M. Bernard Fialaire, Mme Nadège Havet, M. Jean-Raymond Hugonet, Mme Annick Jacquemet, MM. Yannick Jadot, Jean-Jacques Michau, Mme Vanina Paoli-Gagin, M. Christian Redon-Sarrazy, Mme Anne Ventalon, vice-présidents ; MM. Bruno Belin, Rémi Cardon, Stéphane Sautarel, secrétaires ; MM. Pierre Barros, Jean-Baptiste Blanc, François Bonneau, Christophe Chaillou, Raphaël Daubet, Vincent Delahaye, Mme Patricia Demas, M. Éric Dumoulin, Mme Amel Gacquerre, MM. Roger Karoutchi, Khalifé Khalifé, Vincent Louault, Louis-Jean de Nicolaÿ, Alexandre Ouizille, Didier Rambaud, Mme Marie-Pierre Richer, MM. Pierre-Alain Roiron, Jean Sol, Mmes Sylvie Vermeillet, Mélanie Vogel.

AVANT-PROPOS

Christine Lavarde, présidente de la délégation à la prospective

À l'instar des révolutions technologiques générales que furent la machine à vapeur, l'électricité ou encore Internet, l'intelligence artificielle (IA) pourrait profondément changer la façon dont nous vivons et travaillons, et ceci dans tous les domaines. Pourtant, dans le secteur public, les expérimentations restent à ce jour limitées, les annonces modestes, et la parole très prudente.

Pour l'État, les collectivités territoriales et les autres acteurs publics, le potentiel de l'IA générative est immense. Bien utilisée, elle pourrait devenir un formidable outil de transformation de l'action publique, rendant celle-ci non seulement plus efficace - qu'il s'agisse de contrôle fiscal ou de diagnostic médical - mais aussi plus proche des citoyens, plus accessible, plus équitable, plus individualisée et finalement plus humaine - avec une capacité inédite à s'adapter aux spécificités de chaque élève, de chaque demandeur d'emploi, de chaque patient ou de chaque justiciable.

Pour autant, le secteur public n'est pas un secteur comme les autres. Si l'IA n'est qu'un outil, avec ses avantages, ses risques et ses limites, son utilisation au service de l'intérêt général ne pourra se faire qu'à condition que les agents, les usagers et les citoyens aient pleinement confiance.

La confiance, cela passe d'abord par la connaissance : par son approche sectorielle, la délégation espère contribuer à démystifier une technologie qui suscite encore beaucoup de fantasmes, et à en montrer concrètement les possibilités comme les limites.

La confiance, c'est aussi et surtout l'exigence : une IA au service de l'intérêt général, c'est une IA au service des humains (agents et usagers), et contrôlée par des humains (citoyens). C'est aussi une IA qui s'adapte à notre organisation administrative et à notre tradition juridique, et qui garantit le respect des droits et libertés de chacun. C'est, enfin, une IA qui n'implique ni dépendance technologique, ni renoncement démocratique.

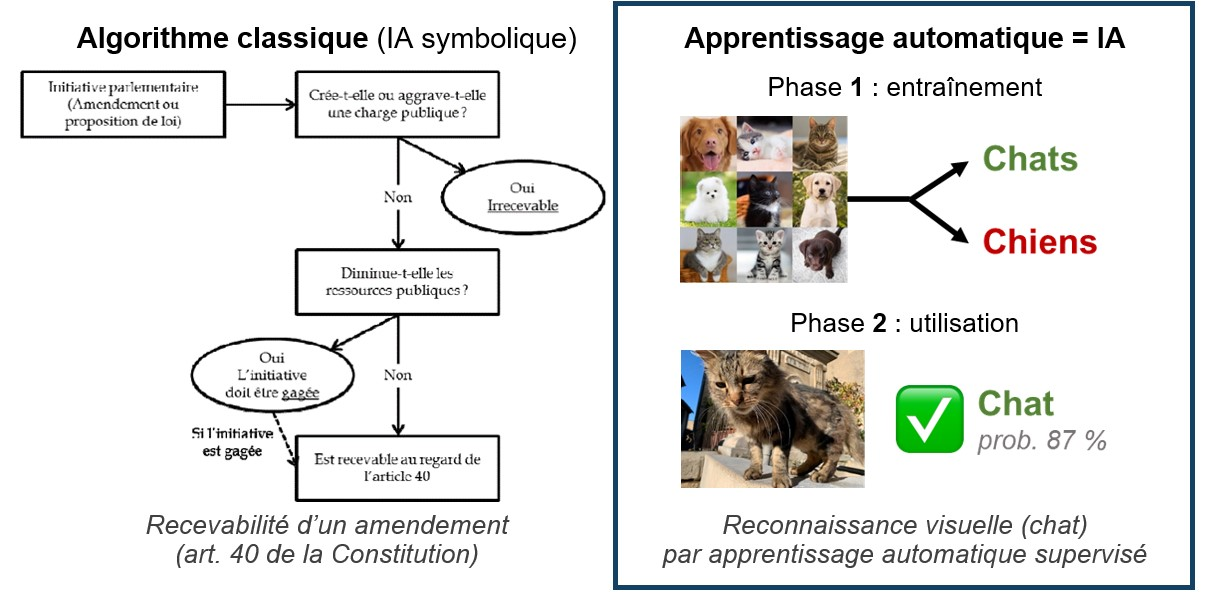

QUELQUES DÉFINITIONS D'INTÉRÊT GÉNÉRAL

· Intelligence artificielle (IA) : terme apparu en 1956 qui, dans son sens actuel, désigne un programme informatique (algorithme) fondé sur l'apprentissage automatique, ou apprentissage machine (machine learning). Cette technique permet à la machine d'apprendre par elle-même à effectuer certaines tâches à partir d'un ensemble de données d'entraînement. Elle repose sur une approche statistique (IA connexionniste), par opposition à l'informatique « classique » (IA symbolique), qui consiste à suivre une suite de règles logiques préétablies (de type « SI... ET... ALORS... »).

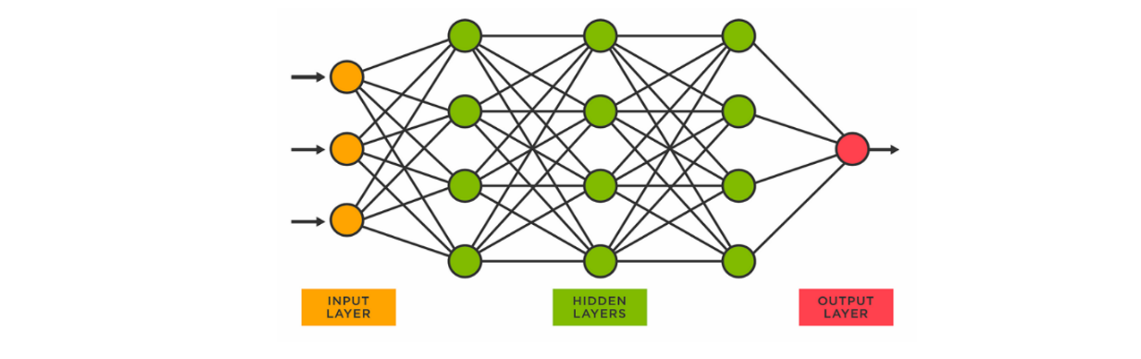

· Apprentissage profond (deep learning) : perfectionnement de l'apprentissage automatique grâce à une organisation en réseaux de neurones artificiels, où chaque « neurone » est une fonction mathématique qui ajuste ses paramètres au fur et à mesure de l'entraînement.

Les progrès sont spectaculaires à partir des années 2010 du fait de 3 facteurs : la sophistication des modèles, la disponibilité des données, et surtout l'explosion de la puissance de calcul.

L'IA est désormais présente dans de très nombreuses applications de notre quotidien.

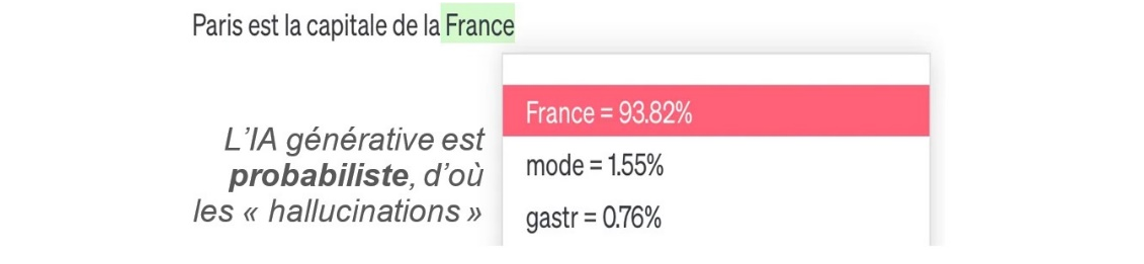

· IA générative : modèles d'IA comme ChatGPT spécialisés dans la création de contenus originaux et réalistes, en réponse à une instruction formulée en langage naturel (le prompt). Le contenu peut être du texte, mais aussi du code informatique, un fichier Excel, une image (Dall-E, Midjourney), un fichier audio ou vidéo (Sora), etc.

· Grands modèles de langage ou LLM (large language models) : modèles d'IA spécialisés dans le traitement du langage naturel, dans toutes les langues.

Entraînés sur d'immenses quantités de textes, ils établissent des relations mathématiques entre les mots et les notions sous-jacentes, à partir de calculs de probabilités.

Les IA génératives sont construites sur des LLM (ex. modèle GPT-4 pour ChatGPT).

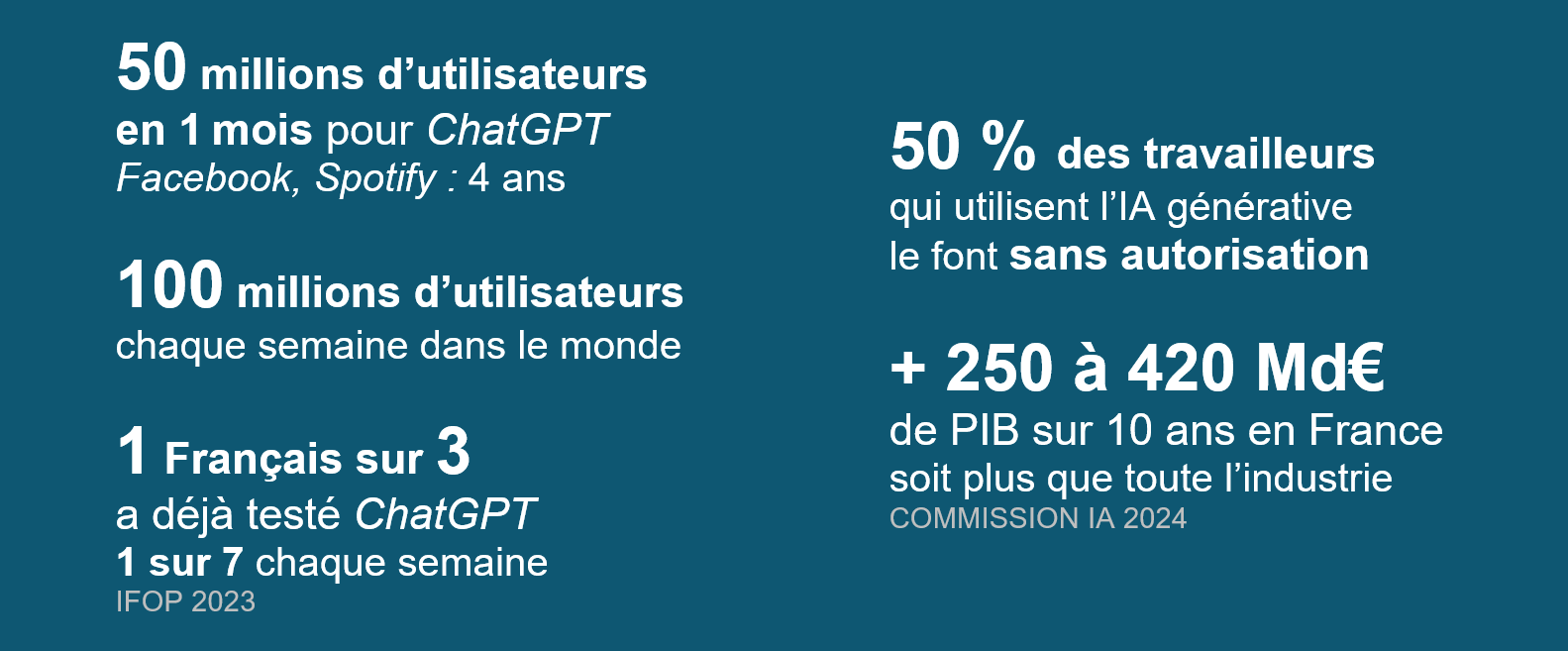

Le lancement de ChatGPT, fin 2022, par la société OpenAI a provoqué dans le monde entier une prise de conscience du potentiel de l'IA générative.

Ce robot conversationnel (chatbot) permet à chacun d'accéder à un modèle à la fois :

- généraliste : il peut traiter tout type de demande, là où la plupart des modèles sont spécialisés dans une tâche précise ;

- multimodal : il peut générer différents contenus (texte, image, graphique, etc.), faire une recherche en ligne ou exécuter un programme informatique ;

- ergonomique : les échanges se font simplement (dans un chat), en langage naturel, et ne demandent aucune compétence technique particulière ;

- peu coûteux : 22 euros par mois pour le modèle le plus puissant du marché (GPT-4), gratuit pour GPT-3.5.

Quelques grands modèles de langage (LLM) concurrents de ChatGPT/GPT-44

L'ESSENTIEL

L'intelligence artificielle (IA) est appelée à jouer un rôle majeur dans l'action publique à l'ère de l'anthropocène, caractérisée par des tensions croissantes sur les ressources naturelles et des changements rapides de l'environnement.

Dès 2018, le rapport « Villani » soulignait que l'IA allait « nous permettre de comprendre la dynamique et l'évolution des écosystèmes en se basant sur la réalité de leur complexité biologique, d'optimiser la gestion de nos ressources, notamment énergétiques, de préserver notre environnement et d'encourager la biodiversité »1(*). Depuis, ce potentiel de l'IA au service de l'environnement n'a cessé de trouver des applications concrètes et les innovations se poursuivent.

Lutte contre les îlots de chaleur dans l'aménagement urbain, suivi du recul du trait de côte, réduction de la pollution en ville, amélioration du tri des déchets ou aide au déploiement des sources d'énergie renouvelable : les exemples sont nombreux.

Associée à une puissance de calcul sans précédent, l'IA est en effet capable de traiter et de mettre en relation une grande quantité de données, ce qui en fait un outil particulièrement intéressant dans un domaine où les enjeux d'adaptation de nos sociétés répondent à une équation complexe. L'urgence à agir est grande, mais la difficulté à faire émerger une vision collective, qui puisse concilier transition écologique et transformation économique et sociale, ne l'est pas moins.

10 exemples parmi d'autres où l'IA change la donne en matière d'environnement

|

Secteur |

Objectif |

Exemple de solution fondée sur l'IA |

|

Énergie |

Réduction des consommations énergétiques dans le bâtiment |

Le dispositif « Advizeo » utilise l'IA pour automatiser le suivi et le pilotage des bâtiments à distance, pour plus de flexibilité dans la gestion énergétique. |

|

Agriculture |

Aide à la décision pour les exploitants agricoles |

L'outil Pixagri développé par TerraNIS permet d'évaluer la biomasse des cultures intermédiaires pour aider les agriculteurs à réduire l'apport d'engrais tout en optimisant leurs pratiques. |

|

Gestion des déchets |

Amélioration du tri des déchets |

Avec Max AI, l'entreprise Veolia utilise des caméras optiques et l'IA pour améliorer les performances du tri. |

|

Gestion de l'eau |

Amélioration de la maintenance prédictive pour une gestion durable des ressources hydriques |

« Mission 90 + » s'appuie sur l'IA pour la détection acoustique de fuites dans le réseau d'eau potable. |

|

Mobilité |

Mesure de l'impact de la mobilité sur l'air et le climat |

Le projet « Predict AI'r » a permis la création d'un dispositif prédictif des impacts de la mobilité grâce à l'IA, en analysant les données de bornage téléphonique et en quantifiant l'empreinte climatique quotidienne des trajets. |

|

Biodiversité |

Connaissance et préservation des habitats naturels |

Le projet « CarHab » a pour objectif de cartographier d'ici 2026 la végétation de tout le territoire français pour établir une carte nationale des habitats naturels et semi-naturels. |

|

Lutte contre les incendies |

Estimer le risque d'incendie |

Le projet GOLIAT utilise l'IA pour représenter le risque de survenue d'incendie par commune en Corse. |

|

Prévision de phénomènes extrêmes |

Alerte sur le risque de canicule |

Utilisation du machine learning sur des données du modèle de simulation « PlaSim » par une équipe du CNRS de Lyon pour démontrer la capacité de l'IA à prédire les canicules jusqu'à un mois à l'avance |

|

Forêts |

Mesurer le stock de carbone contenu dans la biomasse végétale |

L'entreprise KANOP utilise des techniques d'apprentissage profond pour mettre en évidence le stock de carbone contenu dans la biomasse végétale et qualifier la capacité des forêts à séquestrer le carbone atmosphérique. |

|

Urbanisme et aménagement du territoire |

Urbanisme durable |

Avec « Urba AI », l'IA est utilisée pour prendre en compte les enjeux écologiques dans les PLU et suivre les objectifs environnementaux du schéma directeur francilien. |

Sans verser dans le « solutionnisme technologique », la question posée aujourd'hui est de savoir dans quelle mesure l'IA peut contribuer à l'accélération de la transition écologique. Quels sont par exemple ses apports concrets à des politiques comme celle du « Zéro artificialisation nette » (ZAN) ou pour répondre aux difficultés posées par le retrait-gonflement des argiles, qui nécessite de connaître la nature du sous-sol sur une dizaine de mètres ? Quelle place occupe-t-elle dans les travaux des opérateurs publics sur les problématiques environnementales ?

Les avancées promises par l'IA dans la mobilisation des données environnementales au service de la transition écologique étant réelles, l'action publique tente de se structurer pour favoriser l'émergence de solutions d'IA au service de l'environnement. Les usages avancés se trouvent cependant encore en phase très exploratoire.

Le renforcement de l'« exploitabilité » des données, l'amélioration de la gouvernance ainsi que la mise en place d'un modèle économique adapté font partie des conditions de réussite de l'IA pour l'environnement.

*

Le rapport ne prétend pas réaliser un inventaire exhaustif des cas d'usage de l'IA dans le domaine de l'environnement mais a pour objectif de fournir un état des lieux objectif des contributions possibles de l'IA à l'action publique dans ce domaine et des difficultés rencontrées dans l'émergence de solutions.

Il n'a par ailleurs pas pour objet d'approfondir la question de plus en plus prégnante et transversale des conséquences environnementales de l'IA, que nos choix politiques et sociétaux ne peuvent ignorer.

L'empreinte environnementale de l'IA : une question équivoque

Le caractère immatériel de l'IA ne doit pas faire oublier que celle-ci consomme d'importantes quantités de ressources et d'énergie. Elle tend ainsi à aggraver l'empreinte environnementale du numérique2(*).

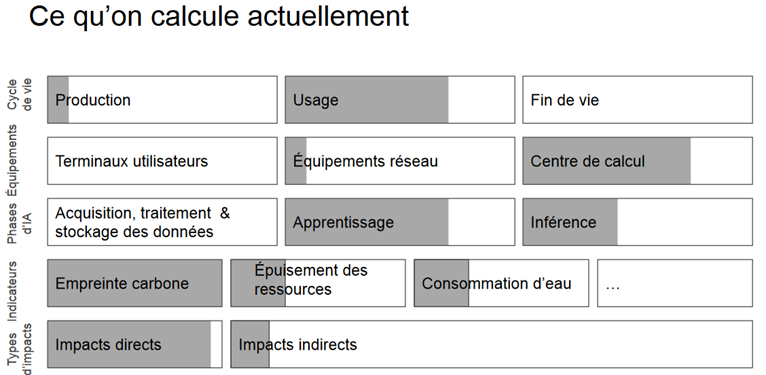

La quantification précise des impacts de l'IA sur l'environnement reste toutefois délicate :

Elle suppose en effet de mesurer la totalité des conséquences directes et indirectes de l'exécution d'un programme d'IA, en ne se limitant pas à son empreinte carbone (émissions de gaz à effet de serre).

Cela signifie qu'il faut prendre en compte chaque étape du cycle de vie des infrastructures et des équipements numériques (calculateurs, matériels présents dans les centres de données, terminaux des utilisateurs), de leur fabrication jusqu'à leurs fin de vie et éventuel recyclage en passant par leur utilisation.

Doivent être intégrées au raisonnement les conséquences de l'extraction des matières premières (minerais et métaux précieux), de la consommation d'énergie et d'eau nécessaires au fonctionnement des centres de données et au refroidissement des serveurs ou encore l'emprise au sol de l'implantation de nouveaux centres de données.

Or comme le montre le schéma ci-après, ces éléments ne font pas tous l'objet d'une évaluation approfondie aujourd'hui.

Source : Anne-Laure Ligozat, Enjeux environnementaux de l'IA, 20243(*)

Il manque en outre des données ouvertes relatives, par exemple, à la part représentée par l'IA dans la consommation énergétique totale des serveurs au sein des centres d'hébergement ou encore à celle des usages faisant intervenir des systèmes d'IA parmi les différentes utilisations des terminaux.

Enfin, la question de savoir si les services apportés par l'IA dans les politiques environnementales sont globalement susceptibles de compenser l'empreinte écologique de cette même IA reste ouverte, les relations entre l'IA et l'environnement étant à double tranchant.

Il n'en demeure pas moins que face aux besoins croissants en infrastructures matérielles et en ressources énergétiques des nouvelles IA, les alertes sur leur empreinte écologique grandissante se multiplient.

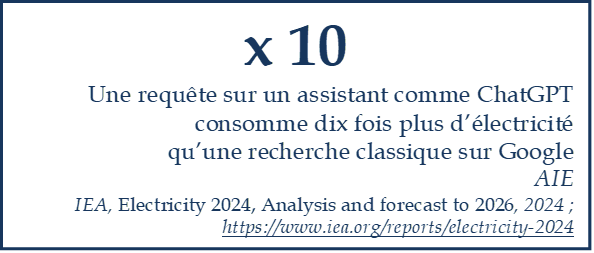

L'IA est l'une des raisons principales de la croissance des besoins en électricité des centres de données.

Comme en témoignent les récents rapprochements des géants du numérique avec l'industrie nucléaire, les besoins en électricité des centres de données sont appelés à croître de façon soutenue.

Selon l'Electric Power Research Institute (EPRI), ces centres pourraient compter pour 10 % de la consommation électrique des États-Unis en 2030 contre 4 % aujourd'hui4(*). Les data centers étant concentrés géographiquement, cette évolution soulève des enjeux localement importants, comme par exemple en Irlande où la consommation électrique des centres a dépassé celle du secteur résidentiel en 2024.

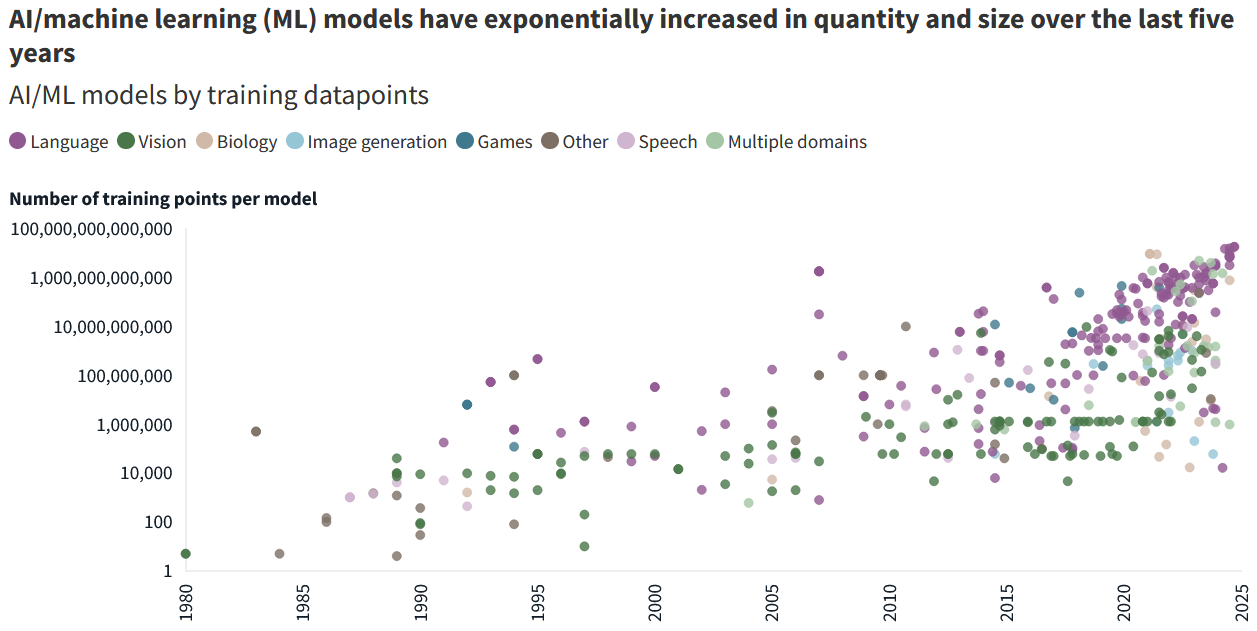

Cette croissance s'explique en grande partie par l'essor de systèmes d'IA de plus en plus grands et généralistes - comme l'illustre le graphique ci-après -, fondés sur des techniques d'apprentissage profond et des opérations d'inférence très énergivores.

Source : JLL Research, 2024, OurWorldInData, EpochAI

Les grands modèles de langage (LLM) des IA génératives s'appuient en effet sur des réseaux profonds de neurones artificiels entraînés sur des volumes de données considérables, ce qui nécessite une puissance de calcul et une capacité de stockage toujours plus élevées.

Selon OpenAI, l'entraînement du modèle de langage GPT-3 a consommé une quantité d'énergie équivalente à la consommation annuelle de 120 foyers américains. Quant à son successeur, GPT-4, il aurait nécessité une consommation d'électricité quarante fois supérieure, soit l'équivalent de celle de près de 5 000 foyers américains5(*).

Compte tenu de l'utilisation de sources très majoritairement carbonées pour produire l'électricité nécessaire au fonctionnement des serveurs, les émissions de CO2 liées à l'IA générative et aux LLM sont particulièrement élevées.

Selon des chercheurs de l'Université du Massachusetts, le seul entraînement d'un modèle d'IA comptant 200 millions de paramètres représente une empreinte carbone supérieure à celle de cinq voitures pendant leur cycle de vie6(*). L'entraînement de GPT-3.5 aurait coûté l'équivalent carbone de 136 allers-retours Paris-New-York. Pour un modèle de langage de 1,75 milliard de paramètres, une phase d'entraînement peut nécessiter plus de 650 000 kWh d'électricité et générer 280 tonnes de CO2, ce qui correspond à un vol entre New York et San Francisco pour 300 passagers.

À titre de comparaison, la consommation annuelle moyenne d'un foyer de deux personnes en France est d'environ 4 679 kWh7(*) et les modèles d'IA les plus avancés, tels que ChatGPT-4, Gemini Ultra ou encore LlaMa-3 utilisent désormais des centaines de milliers de paramètres à des fins d'apprentissage.

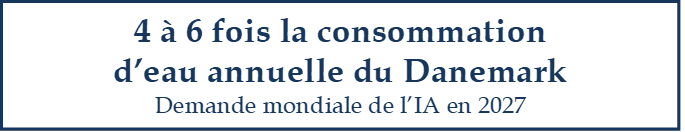

La consommation d'eau liée à l'IA est également en forte hausse.

Les processeurs graphiques (GPU) spécifiques aux IA étant très sollicités, ils produisent beaucoup de chaleur, laquelle est évacuée par un système de refroidissement à eau. De grandes quantités d'eau sont ainsi utilisées pour refroidir les serveurs des centres de données.

En 2023, des chercheurs de l'Université de Californie ont révélé que l'entraînement de GPT-3 dans les centres de données de Microsoft aux États-Unis avait nécessité près de 700 000 litres d'eau douce potable8(*). Leur étude anticipe qu'en 2027, l'IA pourrait être à l'origine de prélèvements d'eau s'élevant entre 4,2 et 6,6 milliards de mètres cubes, soit l'équivalent de quatre à six fois la consommation annuelle du Danemark ou de la moitié de celle du Royaume-Uni. Des conflits d'usage pourraient apparaître dans les zones exposées à un risque de stress hydrique ou de sécheresse.

Dans ce contexte, plusieurs solutions sont mises en avant pour aller vers une IA plus frugale.

Parmi les solutions identifiées pour réduire l'empreinte environnementale de l'IA figurent la conception d'algorithmes optimisés (« green algorithms »), l'amélioration de l'efficacité énergétique des matériels informatiques et le recours accru à des sources d'électricité décarbonées, comme un mix énergétique intégrant le nucléaire et les énergies renouvelables9(*).

Le développement de systèmes d'IA plus frugaux ne doit toutefois pas faire oublier le risque d'un effet rebond des consommations, qui pourrait venir contrarier les effets vertueux escomptés. Ce phénomène est observé lorsque les économies d'énergie attendues avec l'utilisation d'une technologie énergétiquement plus efficace conduisent in fine à un accroissement des usages et donc des consommations. À titre d'exemple, une IA permettant un trafic plus fluide sera à l'origine d'un gain de temps pour les utilisateurs, d'un éloignement des domiciles et d'une augmentation des distances parcourues, donc paradoxalement d'une hausse de la consommation de carburant.

À défaut de régulation juridique fine, les outils et référentiels en faveur d'une IA frugale se développent.

Compte tenu de ces enjeux, la protection de l'environnement fait désormais partie intégrante des considérations sur l'éthique de l'IA adoptées au niveau international. Il en va notamment ainsi dans la Recommandation du Conseil de l'OCDE adoptée le 22 mai 2019 par 42 pays10(*), dont la France, et de la Recommandation sur l'éthique de l'IA de l'Unesco adoptée en 202111(*).

À l'échelle européenne, le livre blanc sur l'IA de la Commission européenne adopté en février 202012(*) met également en avant cet enjeu écologique.

En France, la loi « Réduire l'empreinte environnementale du numérique » du 15 novembre 202113(*) traite quant à elle de l'empreinte écologique du numérique sans aborder spécifiquement l'IA.

Cependant, sous l'impulsion de l'Ademe et de l'Inria notamment, les travaux d'évaluation, de certification et de normalisation des systèmes fondés sur l'IA se poursuivent. C'est l'une des missions de l'observatoire Ademe/RCEP sur les impacts environnementaux du numérique, qui intègre les aspects liés à l'IA générative et tient compte de la nécessité de disposer d'une connaissance fine du cycle de vie des outils et des composants numériques. En collaboration avec l'Afnor, l'Écolab a par ailleurs publié un référentiel général pour l'IA frugale. Il fournit une méthodologie d'évaluation de l'impact environnemental et met en avant les bonnes pratiques.

Des outils ouverts tels que « Green Algorithms » ou « Code Carbon » sont également mis en place pour aider les développeurs à évaluer l'impact énergétique des algorithmes d'IA14(*).

Le recours à l'IA et le choix de l'outil doivent idéalement faire l'objet d'une balance environnementale au cas par cas, les IA spécialisées demeurant par exemple moins énergivores et plus efficaces que les IA polyvalentes.

PREMIÈRE PARTIE

LES AVANCÉES MAJEURES

PROMISES PAR L'IA DANS LA MOBILISATION DES DONNÉES

ENVIRONNEMENTALES AU SERVICE DE LA TRANSITION ÉCOLOGIQUE

L'IA constitue un puissant outil d'aide à la décision dans le domaine de l'environnement, où elle offre des perspectives de progrès très prometteuses. Les avancées permises sont principalement de trois ordres :

- une meilleure connaissance de l'environnement, pour une prise de décision plus éclairée ;

- une amélioration de la capacité de simulation et de prévision, pour anticiper et s'adapter aux enjeux, en particulier dans les situations de crise ;

- un renforcement des processus de décarbonation et d'optimisation énergétique dans des secteurs variés.

L'attention portée à l'IA frugale permet par ailleurs de concilier innovation et durabilité environnementale dans le cadre d'un numérique plus responsable.

I. L'IA POUR CONNAÎTRE L'ENVIRONNEMENT, SIMULER ET PRÉDIRE

L'IA permet de mieux connaître, comprendre ou anticiper des situations ou phénomènes qui relevaient jusqu'alors de la résolution numérique d'équations physiques.

A. LA CONNAISSANCE DE L'ENVIRONNEMENT

La contribution des techniques d'IA à la connaissance de notre environnement ou de certaines de ses composantes fait partie de ses apports les plus importants. Cela concerne en particulier les sols et la biodiversité sur terre comme en mer.

1. La quantification et la qualification des sols

La nécessité de disposer de données précises et fiables sur l'usage des sols et leur qualité constitue un enjeu de taille pour le suivi de leur occupation et l'atteinte du « zéro artificialisation nette » (ZAN) à l'horizon 205015(*). Il s'agit d'accompagner les choix de renaturation des sols en fonction de leurs propriétés.

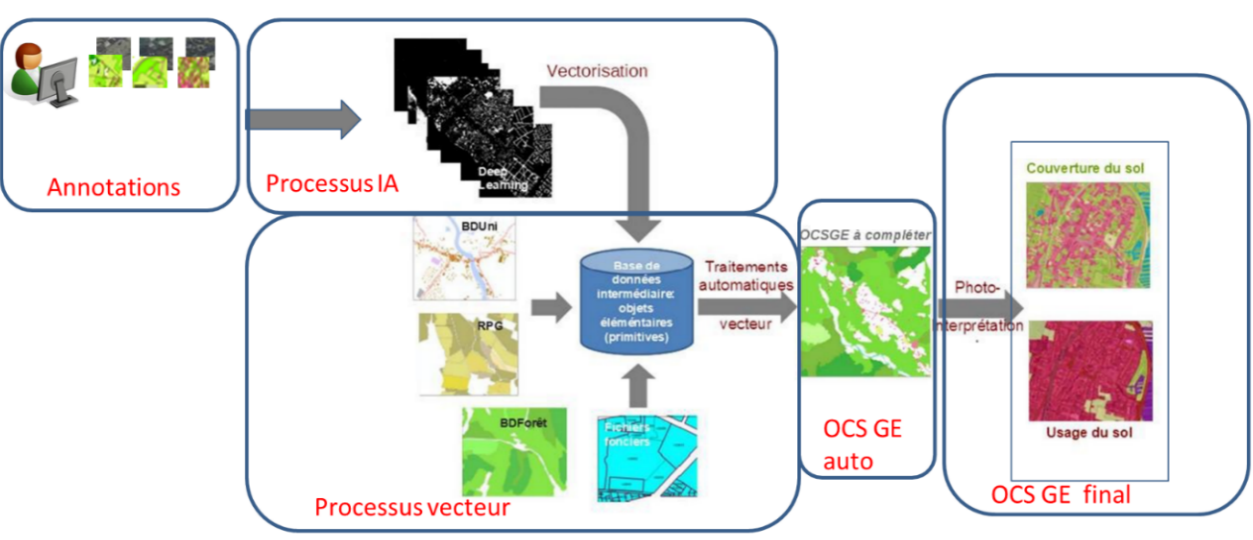

Dans cet objectif, l'automatisation permise par l'IA a apporté une contribution décisive à la production d'une nouvelle génération du référentiel national d'occupation des sols (l'OCS GE16(*)), qui a vocation à être utilisé à différents échelons territoriaux pour la mise en oeuvre des politiques publiques d'aménagement et d'urbanisme.

Produit par l'IGN17(*) à partir principalement des prises de vue aériennes du territoire mises à jour tous les trois ans, puis valorisé par le Cerema18(*), il constitue une base de données vectorielle de référence pour la description de l'occupation et de l'usage du sol de l'ensemble de la France hexagonale et ultramarine (DROM).

L'optimisation de la chaîne de production passe par la recherche d'une automatisation la plus complète possible. Le recours à des techniques d'IA de type « deep learning », associé à l'utilisation d'une infrastructure dotée de capacités de calcul importantes et d'un vaste espace de stockage, permet de répondre à cet objectif.

À l'issue d'une phase d'annotations et d'entraînement, l'analyse des images fait intervenir des réseaux de neurones profonds et le recours à l'IA permet de structurer des données non structurées.

L'IA peut également contribuer à améliorer la qualité des images en faisant de la « super résolution » : lorsque les pixels sont trop gros, des méthodes d'IA sont mises en oeuvre pour retrouver de la résolution, en combinant plusieurs images ou en utilisant des exemples pour essayer de prédire ce que serait une image mieux résolue dans un domaine particulier.

Le processus de production de l'OCS GE dans le cadre de l'observatoire de l'artificialisation

Source : IGN, CNIG commission « besoins et usages » (juin 2022)

L'utilisation de l'IA dans la nouvelle chaîne de production de l'OCS GE a d'abord été expérimentée dans le cadre d'un prototype réalisé sur le territoire du SCOT du bassin d'Arcachon, puis le département pilote du Gers. Cette expérimentation est achevée depuis septembre 2022. Le déploiement national et la production industrielle sont désormais en cours, l'intégralité de la France devant être couverte en 2025.

Dans ce cas d'espèce, le recours à l'IA permet à la fois une réduction importante des coûts19(*), en réduisant la part humaine dans l'interprétation des photos, et une diminution des délais de production, avec un rythme de couverture d'un tiers de la France par an en régime de croisière.

Par comparaison, la première génération de l'OSC GE, produite selon des méthodes traditionnelles, couvre seulement 40 % du territoire national.

« L'IA nous a permis, en gros, de le faire trois fois plus vite pour trois fois moins cher. »

Sébastien Soriano, directeur général de l'IGN, à propos de la cartographie de l'occupation des sols

L'IA permet ainsi d'affiner sensiblement notre connaissance du sol sur lequel viennent s'exercer de multiples pressions (urbanisation, intensification des pratiques agricoles, surexploitation, pollution, changement climatique, etc.).

2. La connaissance et la protection de la biodiversité et des écosystèmes

La connaissance de la biodiversité et des écosystèmes bénéficie également des progrès permis par l'IA.

· Pour la flore terrestre, l'outil participatif Pl@ntNet développé par une équipe de l'Inria20(*) permet à chacun d'identifier plantes et arbres, de détecter des maladies et de recenser les zones de présence à travers des inventaires. Accessible sur une application mobile, il utilise massivement des techniques avancées d'IA. Les observations les plus fiables sont désormais incluses dans la base de données internationales du système mondial d'information sur la biodiversité (« Global Biodiversity Information Facility » ou GBIF). Il s'agit d'un réseau international fournissant un accès libre aux données sur les formes de vie terrestre pour inviter à mieux les protéger.

L'Inria indique que sa nouvelle version (GeoPl@ntNet) permettra d'obtenir l'établissement de cartes de biodiversité, par exemple dans les zones faisant l'objet de projets d'aménagement, avec un rôle potentiel d'appui aux politiques publiques comme en matière de ZAN.

· Les techniques d'IA apportent également une contribution essentielle à la connaissance de la biodiversité marine, en particulier celle des espaces côtiers et dans les écosystèmes qui restent encore peu explorés comme ceux des grands fonds.

§ Mieux prédire la biodiversité des poissons récifaux

S'agissant des systèmes récifaux, il manque aujourd'hui un ensemble d'indicateurs écologiques et des modèles prédictifs pertinents pour connaître leur dynamique et mieux anticiper leurs évolutions. Cette insuffisance est liée au coût élevé des dispositifs de suivi dans ce domaine. L'amélioration de la connaissance requiert un haut niveau d'expertise mais aussi des modèles capables d'assurer un suivi plus global là où les connaissances existantes sont relativement circonscrites géographiquement et temporellement.

Dans ce contexte, l'IA et ses modèles d'apprentissage profond constituent un précieux atout du fait de leur capacité à analyser finement des données brutes non structurées telles que des images satellitaires, des vidéos sous-marines ou encore des données environnementales spatialisées (température de l'eau, profondeur des fonds marins...).

Ces techniques permettent d'envisager la définition d'une nouvelle génération d'indicateurs et de modèles à partir de données massives peu exploitables avec des approches classiques.

C'est l'objectif poursuivi par le projet FISH-PREDICT coordonné par l'Université de Montpellier21(*). Il consiste à analyser un volume très important de données afin de caractériser des écosystèmes côtiers de la mer Méditerranée et de l'océan Pacifique grâce à des modèles de distribution d'espèces d'un nouveau type. La technique s'appuie sur des modèles d'apprentissage profond tels que les réseaux neuronaux convolutifs ou des « vision transformers »22(*).

Elle permettra d'affiner la connaissance des paramètres environnementaux dans toutes leurs variations spatiales et de mieux expliquer la distribution des espèces. Des interactions complexes comme l'influence des bateaux de plaisance sur les ressources pélagiques ou l'impact de l'aménagement de la côte sur la biodiversité marine pourront également être analysés.

Source : https://dataanalyticspost.com/projet-fish-predict/

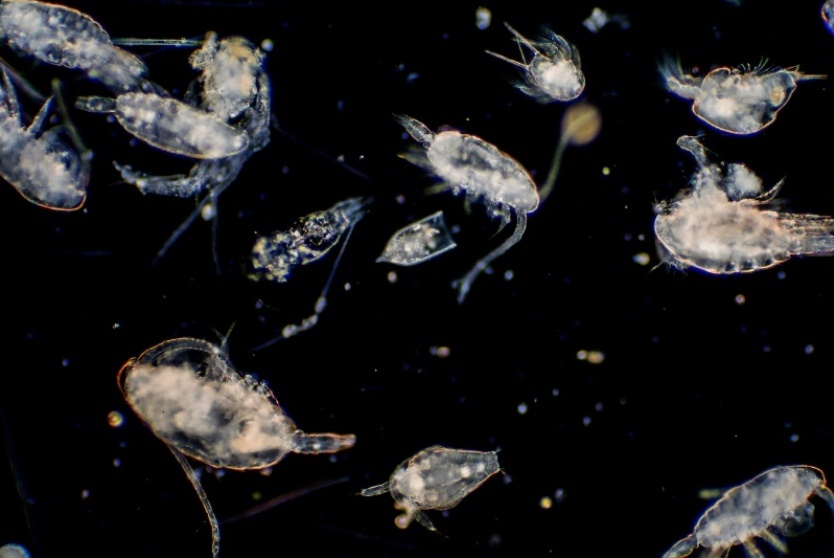

§ Répertorier la micro-faune des océans

Dans le cadre du projet « Meiodyssea », une équipe de chercheurs de l'Ifremer en collaboration avec d'autres scientifiques japonais, hollandais et allemands, entreprennent de décrire, en l'espace de trois ans, 125 à 200 nouvelles espèces de la « méiofaune », c'est-à-dire des petits organismes de moins d'un millimètre nichés dans les sédiments des cinq océans. Ce projet repose sur une méthode originale combinant les techniques d'imagerie 3D haute résolution et l'IA.

Un logiciel d'IA sera entraîné pour détecter, mesurer et décrire les caractéristiques morphologiques et morphométriques des nouvelles espèces, ce qui leur permettra de gagner en efficacité et en temps dans la structuration des nombreuses informations extraites de l'analyse des échantillons. Selon les chercheurs, grâce à cette méthode originale, les nouvelles espèces présentes dans un échantillon devraient pouvoir être détectées en 15 minutes au lieu de plusieurs semaines.

La description complète devrait prendre quelques jours au lieu de quelques mois23(*).

Le projet permettra plus généralement de mieux comprendre le rôle de ces espèces invisibles à l'oeil nu dans le fonctionnement et la dynamique des écosystèmes marins, certaines espèces, comme certains nématodes, jouant un rôle avéré de « sentinelles », c'est-à-dire d'indicateurs de contamination chimique de l'environnement.

Mieux connaître la méiofaune permettra ainsi de mieux cerner l'impact des activités humaines sur l'océan. En outre, ces espèces dotées d'une capacité hors norme de vivre dans des conditions extrêmes sont susceptibles d'inspirer des développements dans le secteur des biotechnologies.

· Pour l'exploration de l'océan profond et de ses ressources en métaux rares, l'IA pourrait également jouer un rôle transformateur grâce aux progrès des véhicules autonomes (AUV) et des robots télécommandés (ROV) sous-marins.

Équipés de capteurs et de technologies d'imagerie avancées, ces véhicules naviguent de manière autonome dans des milieux complexes. Les algorithmes d'IA permettent de collecter, traiter et analyser en temps réel des données environnementales et biologiques, rendant l'exploration sous-marine à la fois plus sûre et efficace.

L'IA et l'exploration des ressources des grands fonds marins

L'IA excelle dans le traitement des données sonar et d'imagerie pour créer des cartes détaillées des fonds marins et révéler de nouvelles caractéristiques géologiques et des habitats inconnus.

Les algorithmes d'IA identifient les zones écologiquement sensibles, comme les habitats marins vulnérables ou abritant une biodiversité unique24(*), des récifs coralliens profonds ou des zones de reproduction de certaines espèces, ce qui permet par exemple d'orienter les opérations d'exploration des ressources vers des zones moins exposées.

Dans le domaine de l'exploitation minière (deep sea mining), l'IA permet une détection précise des ressources. Les algorithmes analysent les données géologiques et les images des fonds marins pour localiser des dépôts de nodules polymétalliques ou de sources hydrothermales. L'IA peut ainsi fournir des informations que les méthodes traditionnelles ne permettaient pas d'obtenir, accélérant considérablement l'évaluation des ressources25(*). En outre, les robots avancés alimentés par l'IA peuvent automatiser des tâches complexes comme l'excavation ou le transport de matériaux, réduisant la nécessité d'intervention humaine dans des environnements dangereux.

Malgré ces avancées, des défis subsistent, tels que la robustesse des systèmes d'IA dans des conditions extrêmes où la communication et l'alimentation en énergie sont limitées. Les cadres réglementaires peinent par ailleurs à suivre le rythme des avancées technologiques dans un domaine qui demeure écologiquement controversé26(*). Enfin, les coûts initiaux élevés des systèmes d'IA freinent leur adoption à grande échelle.

B. LES POSSIBILITÉS AUGMENTÉES DE SIMULATION ET DE PRÉDICTION

Des techniques d'IA sont mises en oeuvre pour réaliser des simulations dans une démarche prédictive ou d'alerte précoce.

Elles permettent ainsi d'anticiper des changements à court, moyen ou long terme, en particulier dans le domaine des services météorologiques et climatiques.

1. L'état des nappes phréatiques et la gestion de l'eau

Pour le suivi des nappes phréatiques, le Bureau de recherches géologiques et minières (BRGM) utilise le machine learning comme un complément à la modélisation physique « classique » ou en substitution de modèles physiques pour développer l'outil « météaunappes ». À partir de séries temporelles de suivi du niveau des nappes et de leur composition chimique, celui-ci permet d'anticiper le comportement saisonnier de certaines nappes en fonction de scénarios climatiques.

L'IA permet en effet de construire des modèles statistiques de prévisions plus robustes en tenant compte de divers paramètres agissant sur le niveau des nappes (pluviométrie, température ou encore propriété du sol). Elle permet également d'obtenir une connaissance plus fine aux endroits ne disposant pas de relevés issus de capteurs (piézomètres) ou de définir un emplacement adapté pour ce type de capteur afin de parvenir à une estimation efficace du niveau d'un aquifère.

Cette utilisation permet de fournir aux autorités une information prédictive relativement fiable pour la gestion de l'eau à l'échelle de certains territoires.

2. La prévention des inondations

Pour la prévention des inondations, le projet AI4FLOOD27(*) auquel participe le Cerema s'appuie sur l'IA pour suivre les mesures hydrométéorologiques de terrain et contribuer à renforcer l'efficacité de leur analyse, en l'absence ou en complément de prévisionnistes experts. De façon complémentaire, l'analyse des images radar par l'IA a pour objectif d'améliorer les prévisions pluviométriques.

Le projet concerne quatre bassins pilotes frontaliers de l'Espagne situés en dehors du réseau de vigilance relevant de l'État. À terme, les jeux de données de référence des modèles doivent s'enrichir pour alimenter un méta-modèle qui sera capable de réaliser des calculs hydrauliques quasiment en temps réel sur quelques centaines de noeuds et de contribuer à un système d'alerte précoce. Une couverture plus exhaustive du territoire pourra ainsi être envisagée.

3. La modélisation des évolutions météorologiques et climatiques et des événements extrêmes

L'IA apporte également une contribution significative à la modélisation dans le domaine de la météorologie et des sciences du climat.

· L'IA et la prévision du temps

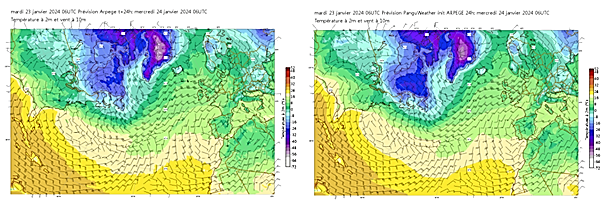

S'agissant de la météo, des techniques d'IA ont fait leur entrée à Météo-France dès les années 1990 afin d'améliorer notamment le « post-traitement » statistique des prévisions météorologiques, c'est-à-dire le processus visant à affiner des données brutes issues d'un modèle de calcul pour renforcer la pertinence des résultats.

Mais c'est surtout dans la période récente que des développements novateurs en IA ont permis de faire progresser certaines parties des modèles de prévision. Le recours à des méthodes d'apprentissage automatique comme des forêts d'arbres de décisions développées en interne est désormais habituel, notamment pour le post-traitement statistique des prévisions.

L'utilisation de réseaux de neurones convolutifs, adaptés au traitement d'image, est également fréquent. Les applications sont multiples : prévision à court terme de la couverture nuageuse, estimation des précipitations à partir d'images satellites, nettoyage d'images radar, détection de neige sur des images de webcams ou encore identification d'orages violents dans les résultats des modèles de prévision numérique du temps28(*).

Le recours à ces techniques permet de traiter en quelques secondes des images produites par des centaines de webcams sur le territoire français et, par exemple, d'identifier celles présentant de la neige ou du brouillard. Le prévisionniste est ainsi mis en capacité de localiser directement les zones concernées par des phénomènes potentiellement dangereux, alors qu'il devait auparavant visualiser les images une par une.

Dans ce contexte, le recours à l'IA fait gagner un temps considérable dans la prévision météorologique.

Les émulateurs par IA sur lesquels travaille Météo-France sont entraînés sur des données issues de relevés d'observations et de prévisions29(*). Ils sont ensuite capables de « produire l'équivalent de certaines prévisions ou d'affiner certaines d'entre elles avec une extrême rapidité, déplaçant le coût vers la production de l'information nécessaire à l'entraînement des systèmes »30(*). La question de savoir si des modèles météorologiques entièrement basés sur l'IA se substitueront aux modèles physiques peut ainsi se poser.

L'IA va-t-elle remplacer les modèles météorologiques actuels ?

La chaîne de production des prévisions météorologiques fait intervenir plusieurs étapes. Schématiquement :

- des données d'observation de l'atmosphère, des surfaces ou encore de l'océan sont collectées par satellites ou des moyens in situ ;

- ces données alimentent plusieurs fois par jour des modèles numériques représentant les processus atmosphériques ;

- les résultats de ces simulations brutes sont retraités pour produire les informations de prévision.

Depuis quelques années, les techniques d'apprentissage profond paraissent offrir une alternative intéressante à certaines composantes de cette chaîne. La recherche se poursuit pour le développement de systèmes de prévision intégralement fondés sur l'apprentissage capables d'égaler la finesse spatiale des modèles actuels (de l'ordre de 1 kilomètre à 500 mètres).

Cependant, l'amélioration des modèles de prévision actuels doit également se poursuivre pour les raisons suivantes rappelées par Météo-France :

- la bonne exploitation d'un système de prévision numérique fondé sur l'IA requiert l'accès à des données adéquates pour l'apprentissage. Or ces données sont aujourd'hui issues des modèles physiques et le modèle d'IA doit être régulièrement entraîné ;

- des progrès doivent encore être réalisés dans l'adaptation du post-traitement pour garantir la valeur des informations produites par ces nouveaux systèmes ;

- par rapport aux modèles physiques, les modèles fondés sur l'IA soulèvent un enjeu crucial de transparence (ou d'« explicabilité »), susceptible de freiner les développements en cours si la question de la « boîte noire » n'est pas réglée par la garantie d'une « IA de confiance ». Il s'agit de permettre aux prévisionnistes de s'approprier les nouveaux outils en en comprenant le fonctionnement.

Au total, les deux approches ont vocation à cohabiter à court et moyen terme, le passage à un modèle d'IA intégral étant encore une perspective relativement lointaine.

Selon les scientifiques, seule une utilisation régulière pendant plusieurs années permettra de savoir si les modèles d'IA pourront pleinement s'intégrer à la prévision d'un point de vue opérationnel.

· L'IA et la modélisation du climat

§ L'IA est également de plus en plus employée dans la science du climat.

Des méthodes d'IA sont utilisées pour « émuler » - simuler numériquement - des modèles climatiques régionaux. Des projections climatiques mondiales voient ainsi leur échelle réduite à 10 kilomètres horizontalement, ce qui permet de multiplier les possibilités de simulation régionale sans nouvelles modélisations.

Dans ce cadre, selon Météo-France, l'apport de l'IA est décisif pour caractériser de manière fine les sources d'incertitude telles que l'influence de la variabilité naturelle, c'est-à-dire les fluctuations du climat qui se produisent sans l'influence directe des activités humaines. De premiers développements en ce sens ont porté sur les températures et les précipitations.

Météo-France indique que l'IA peut également être utilisée pour remplacer certaines parties onéreuses des modèles climatiques globaux, y compris en l'absence d'observations de référence. Cela concerne en particulier la prise en compte du transfert radiatif, c'est-à-dire l'influence des rayonnements. Des simulations numériques sont alors produites, sur le fondement desquelles des paramétrages reposant sur l'IA sont développés. Cette technique permet à l'établissement de produire des simulations climatiques à un coût numérique réduit.

§ La prévision des phénomènes extrêmes

De nombreuses équipes à travers le monde contribuent à faire progresser la recherche sur l'apport de l'IA pour anticiper des phénomènes localement dangereux.

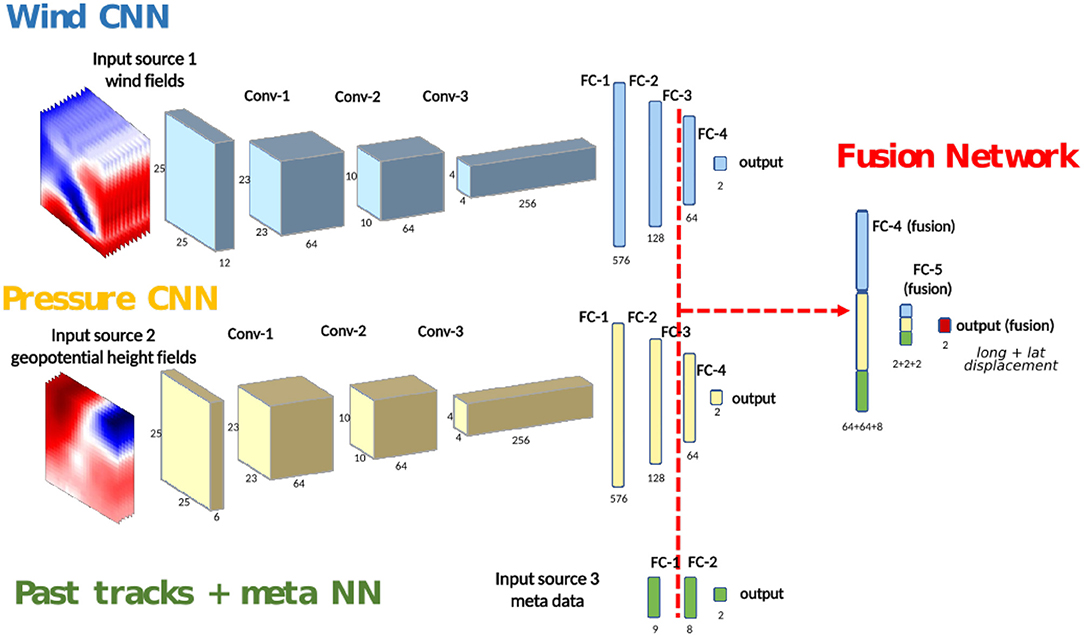

C'est le cas du projet « ARCHES »31(*) conduit par l'Inria en partenariat avec le laboratoire LATMOS/ISPL. Ce projet explore les perspectives d'utilisation de l'IA pour mieux prévoir des événements météorologiques extrêmes, notamment les « risques en cascade ».

Dans le cadre d'une approche interdisciplinaire, l'équipe de recherche a démontré qu'une adaptation des réseaux neuronaux convolutifs, un type avancé d'apprentissage profond, permettait de prédire avec précision la trajectoire des ouragans, qui sont connus pour être difficiles à anticiper. De nombreuses questions restent à explorer et la recherche se poursuit, en particulier sur la compréhension des changements soudains d'intensité des ouragans.

Trois réseaux neuronaux convolutifs (CNN) sont entraînés séparément à partir de trois catégories de données (vents ; géopotentiel ; historique et métadonnées). Le réseau final fusionné est réentraîné avant de fournir une prévision de déplacement de l'ouragan sur 24 heures.

Source : Giffard-Roisin et al., « Tropical Cyclone Track Forecasting Using Fused Deep Learning From Aligned Reanalysis », Frontiers in Big Data, 28 janvier 202032

L'IA trouve également des applications pour la prédiction des canicules. Une équipe interdisciplinaire de scientifiques français32(*), du CNRS, du CEA et de l'Université Claude-Bernard Lyon 1 a en effet mis au point une IA capable d'évaluer la probabilité de la survenue de vagues de chaleur, à partir de données environnementales telles que l'humidité des sols et l'état atmosphérique, jusqu'à un mois à l'avance.

Cette technologie de prévision climatique avancée utilise le deep learning et des modèles statistiques intégrant de nombreux paramètres. Entraînée sur 8 000 ans de données simulées avec le modèle climatique PlaSim de l'Université de Hambourg, cette IA génère des prévisions en quelques secondes, en complément des modèles météorologiques traditionnels.

Pour pallier le manque de données sur les événements rares, les chercheurs prévoient de combiner cette solution avec des algorithmes de simulation conçus il y a cinq ans, afin d'optimiser la fiabilité des prévisions et de comparer les résultats.

4. Les jumeaux numériques : une approche très prometteuse pour l'aide à la décision

L'approche des jumeaux numériques connaît des développements rapides sur les questions environnementales. Associées aux progrès permis par l'IA, ces techniques ouvrent de nouveaux horizons pour l'aide à la décision fondée sur les possibilités de simulation.

Le concept de « jumeau numérique » : bref détour historique

Un jumeau numérique constitue une réplique numérique d'une réalité physique. Il permet de suivre et d'anticiper les effets de divers facteurs sur cette réalité grâce à des modèles de simulation et de prévision. D'abord cantonné au secteur industriel, le terme recouvre aujourd'hui des réalités diverses, allant de la gestion d'un bâtiment ou d'une infrastructure à l'appréhension d'un territoire, qu'il s'agisse d'un quartier urbain, d'un espace rural, d'une ville dans son ensemble ou d'une étendue géographique encore plus vaste.

Le jumeau numérique est conçu pour être synchronisé avec le monde physique, à travers des flux de données arrivant par exemple de capteurs ou de systèmes qui extraient des informations sur la représentation modélisée.

Le sauvetage d'Apollo 13 : premier usage d'un réseau de « jumeaux numériques »

Si le concept de jumeau numérique a aujourd'hui le vent en poupe, sa première utilisation remonte à l'accident de la mission Apollo 13 en 1970.

À 330 000 kilomètres de l'équipage, les ingénieurs de la NASA disposaient de simulateurs du fonctionnement des principaux composants de la capsule endommagée. Contrôlés par un réseau d'ordinateurs, les simulateurs pouvaient être synchronisés avec les données provenant de l'engin spatial. L'opération de diagnostic et de sauvetage de la mission a ainsi été rendue possible en grande partie grâce à des « doubles numériques » en interaction les uns avec les autres.

Un concept popularisé dans l'industrie à partir des années 2000

Au plan conceptuel, le « jumeau numérique » trouve ses prémices dans l'idée de « monde miroir » tel que décrit par David Gelernter en 199333(*). Ce dernier imaginait un prototype complet d'une ville ou du monde peuplé de jumeaux numériques interconnectés.

Le concept a ensuite été popularisé dans l'industrie dans les années 2000, dans le cadre de la création d'un centre de gestion du cycle de vie des produits sous l'impulsion de Michael Grieves de l'Université du Michigan34(*). Il s'agissait d'associer un objet physique à un double numérique capable d'en observer le fonctionnement en temps réel afin d'en suivre le cycle de vie. La réplique numérique offrait un support sur lequel des forces pouvaient être appliquées afin de modéliser le comportement d'un l'objet physique et ses déformations.

Le jumeau numérique étant mis à jour par la réception de flux d'informations provenant de capteurs, senseurs et dispositifs électroniques, cela a ouvert la voie à une approche innovante fondée sur la possibilité de simulations.

Une utilisation croissante dans de multiples domaines, portée par les progrès de l'IA

Grâce au progrès technologique (accroissement des performances et miniaturisation du matériel informatique, rapidité croissante des réseaux de télécommunications avec le ultra haut débit), les techniques du jumeau numérique connaissent aujourd'hui de nombreuses applications avérées ou potentielles, non seulement dans le domaine industriel, pour optimiser les processus de production et la maintenance (aéronautique, industrie automobile, nucléaire), mais aussi en médecine par exemple (essais « in silico ») et désormais dans le domaine des sciences environnementales.

Par la prise en compte du comportement, dans le temps et l'espace, d'un objet qui évolue dans son environnement, le jumeau numérique permet d'adopter une approche holistique de la représentation : un seul espace doté d'échelles multiples et d'une représentation en quatre dimensions doit permettre d'offrir un double virtuel d'une réalité physique quelle qu'elle soit, comportant à la fois son passé, son présent et ses futurs possibles.

S'agissant de l'adaptation aux enjeux environnementaux, la combinaison de l'IA avec la modélisation en 3D très précise dans le cadre de jumeaux numériques permettra de tester des scénarios d'évolution en fonction de divers paramètres.

a) Une « carte du futur » pour connaître l'environnement, simuler et planifier

Les caractéristiques du jumeau numérique en font aujourd'hui un outil prisé pour l'adaptation aux enjeux environnementaux.

Son intérêt est qu'il peut apprendre en permanence à partir de multiples sources et, à mesure que la contrepartie physique change, se mettre à jour à une vitesse beaucoup plus rapide que les modèles de cartographie et de simulation précédents.

De multiples problématiques peuvent être concernées : gestion de l'énergie, évolution du trait de côte, suivi de la santé des forêts, transition agricole ou encore politique écologique.

L'IA intervient à différents niveaux pour intégrer et réduire la complexité des flux de données, par exemple avec des espaces latents (espaces identifiés comme optimaux pour résoudre une tâche), accroître la rapidité des simulations (métamodèle) et pour transformer les données du simulateur en aide à la décision.

b) Des échelles géographiques diverses, du niveau local à la Terre toute entière

§ Le développement d'un jumeau numérique sismique en milieu géologique complexe en Guadeloupe

L'École spéciale des travaux publics (ESTP)35(*) collabore avec le BRGM et d'autres partenaires à l'encadrement d'une thèse sur le développement d'un jumeau numérique sismique en milieu géologique complexe pour les risques industriels.

Lancé en octobre 2022, ce projet consiste en la construction de plusieurs jumeaux numériques dits « multi-physiques multi-échelles », interopérables par objet d'intérêt (faille, grandes structures sismologiques environnantes, lithostructure sous-jacente au site d'étude, etc.). L'étude concerne une zone de la commune de Capesterre-Belle-Eau en Guadeloupe, qui inclut le barrage hydraulique Dumanoir36(*).

Un double objectif est poursuivi : comprendre l'importance relative des différents processus qui expliquent la survenue des séismes et améliorer la prédiction fine des mouvements du sol. L'enjeu est d'assurer l'intégrité des installations industrielles critiques et d'accompagner le développement d'un territoire soumis à des pressions grandissantes en termes d'aménagement.

Le projet repose sur des outils comme du machine learning pour traiter automatiquement de très grandes quantités de données générées par les scénarios de séismes et sur le développement de workflows semi-automatiques.

Il est prévu que la méthodologie développée puisse être appliquée à d'autres sites concernés par des risques industriels avérés37(*).

§ Le jumeau numérique de la France et de ses territoires

À l'échelle de la France entière, un ambitieux projet de développement d'un jumeau numérique a récemment été lancé par l'IGN en collaboration avec le Cerema et l'Inria. À terme, ce « jumeau numérique de la France et de ses territoires » doit offrir une cartographie du futur du territoire en fonction de différents scénarios d'évolution des conditions climatiques et de l'action publique.

Pour ce faire, d'après les éléments communiqués par l'Inria, l'IA sera utilisée de façon massive : pour la spatialisation et les représentations polymorphes (paysages, ouvrages d'art, infrastructures) mais aussi pour des simulations (risques environnementaux, épidémiologie, biodiversité...)38(*).

Parmi les cas d'usage possibles touchant à l'environnement, on peut citer :

- la problématique de la gestion du littoral, pour laquelle le jumeau numérique permettra par exemple de visualiser en dynamique des scénarios d'évolution pour les infrastructures ou les biens menacés ;

- l'enjeu de la résilience du système agricole, avec l'anticipation du changement climatique sur les types de culture ou la modélisation à grande échelle des évolutions des pratiques agricoles ;

- la question de la gestion durable des forêts en simulant son évolution en fonction de diverses hypothèses climatiques.

Quelques exemples d'utilisateurs et d'usages possibles

Élu de collectivité, le jumeau numérique m'aide à prendre en compte l'objectif de Zéro artificialisation nette. Il me permet de calculer l'impact de mes choix d'aménagement sur l'artificialisation des sols et clarifie les arbitrages entre les contraintes de sobriété foncière et de réponse aux besoins.

Citoyen, je participe aux consultations publiques grâce au jumeau numérique national en accédant à un outil de médiation me permettant de visualiser simplement les choix d'aménagement et l'impact sur mon cadre de vie.

Bureau d'études, le jumeau numérique me donne accès à des données fiables et pertinentes ainsi qu'à des outils de simulation des risques de submersion à court et long terme.

Agence de l'eau, le jumeau numérique me permet de simuler l'effet de différentes pratiques agricoles sur l'eutrophisation des cours d'eau et la contamination éventuelle de nappes phréatiques par des produits phytosanitaires.

Pendant l'incendie [d'une forêt], le jumeau numérique sert de support d'information aux services de secours. Des simulations permettent d'anticiper l'évolution du feu et guide les pompiers dans leurs actions.

Source : IGN

La mobilisation de modèles de simulation facilitera l'élaboration d'outils d'aide à la décision mais aussi d'intermédiation pour éclairer le débat public.

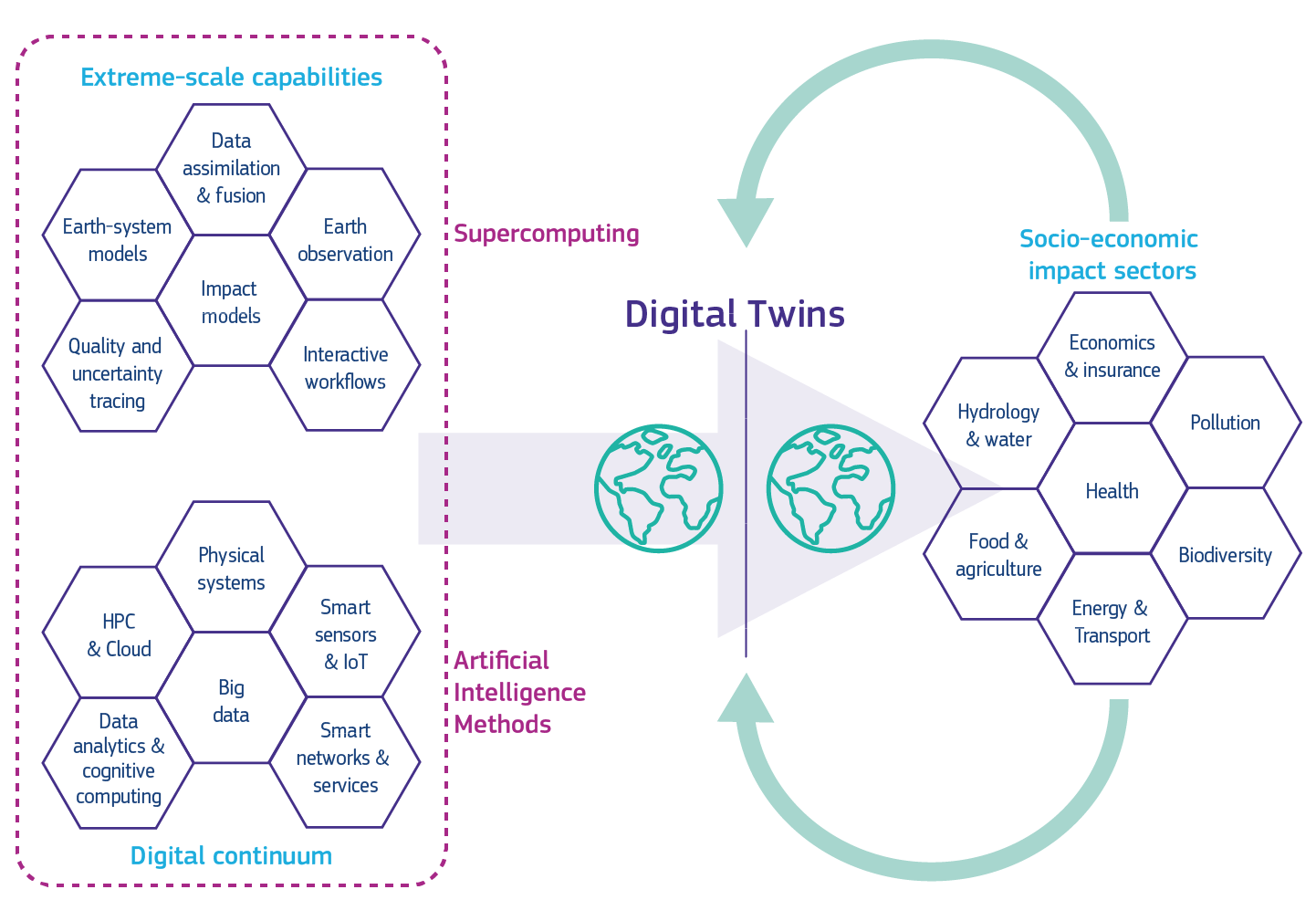

§ Du jumeau numérique de l'adaptation au changement climatique au jumeau numérique de la Terre

À l'échelle européenne, le lancement début 2022 de l'initiative « Destination Terre »39(*) doit permettre de développer un jumeau numérique très précis de la Terre à l'horizon 2030.

Il aura vocation à réunir dans un socle commun plusieurs jumeaux numériques thématiques, parmi lesquels les deux premiers, dévoilés en juin 2024, sont consacrés, d'une part, à l'adaptation au changement climatique40(*), d'autre part, aux phénomènes météorologiques extrêmes.

À terme, ces jumeaux numériques fonctionneront en synergie pour permettre la prise en compte des interactions entre le climat et d'autres dimensions environnementales ou sociales des politiques publiques. Ils permettront ainsi d'anticiper leurs impacts dans les différents secteurs des politiques concernées.

Source : Commission européenne

Les données sont collectées à partir de sources variées (satellites avec notamment le programme européen Copernicus, réseaux d'observation mondiaux, capteurs terrestres, observations in situ) et alimentent une base de données. Le jumeau intègre des modèles climatiques avancés, qui simulent les processus physiques, chimiques et biologiques et incluent des simulations des interactions entre l'atmosphère, les océans, les glaces polaires, les forêts et les activités humaines.

Les infrastructures de calcul à haute performance (HPC) permettent de gérer et de traiter les gigantesques quantités de données. L'IA, avec l'apprentissage automatique, est utilisée pour améliorer les modèles, détecter des motifs complexes dans les données et fournir des prévisions rapides et fiables.

Grâce à une plateforme de services, les utilisateurs pourront accéder à des outils d'IA, des analyses de données à grande échelle et des capacités de surveillance et de simulation du système terrestre. Les secteurs concernés par l'impact du changement climatique et les évènements extrêmes (agriculture, forêt, énergies renouvelables, santé publique, gestion de l'eau) pourront adapter les outils et données disponibles à leurs besoins.

Le jumeau numérique a ainsi vocation à devenir également un support pour la recherche scientifique, en laissant la possibilité aux chercheurs d'explorer les interactions complexes entre différents « sous-systèmes » comme les océans, l'atmosphère et la biosphère.

c) Des interrogations en suspens

Si la technologie du jumeau numérique laisse entrevoir des progrès considérables pour la simulation, des interrogations demeurent.

La réflexion sur sa place dans l'aide à la décision n'en n'est en effet qu'à ses débuts. En témoigne le groupe de travail du Conseil national d'information géolocalisée (CNIG) avec l'IGN, le Cerema et l'Inria41(*). Ses travaux visent notamment à clarifier la terminologie employée, recenser les cas d'usage et les bonnes pratiques des jumeaux numériques territoriaux en termes de capacités d'analyse et de simulation, et à évaluer l'apport véritable de l'IA dans la modélisation.

La réflexion porte également sur la capacité d'un jumeau numérique à être un parfait modèle de la réalité. Indépendamment de la question de la mise à jour des modèles et de la synchronisation des données, il s'agit des limites liées à la « calculabilité » d'une simulation de plus en plus complexe du monde42(*). Les progrès considérables de l'IA, en particulier de l'IA générative, semblent permettre de repousser les limites de la prédictibilité. La question peut néanmoins se poser de savoir à partir de quand ou dans quelles situations un jumeau ne parviendra plus à refléter correctement la réalité. En tout état de cause, l'enjeu d'intelligibilité des processus sur lesquels se fonde le modèle devra être pris en compte.

Enfin, de nombreux jumeaux numériques sont en cours de développement, y compris par de grands acteurs privés en France et surtout à l'étranger. NVIDIA a par exemple annoncé la création d'Earth-2, jumeau numérique du climat terrestre. Fujitsu exploite de son côté l'IA et les données des drones sous-marins pour créer un jumeau numérique de l'océan. Le CNES et QuantCube ont récemment élaboré un prototype de jumeau numérique pour la gestion des risques d'inondation. L'articulation entre ces différents modèles publics et privés et la façon dont les acteurs s'en saisiront restent des questions ouvertes.

II. L'IA POUR S'ADAPTER AUX ENJEUX ENVIRONNEMENTAUX ET CONTRIBUER À LA DÉCARBONATION

L'IA apporte une contribution significative à l'adaptation aux enjeux écologiques : décarbonation, gestion durable des ressources ou encore préservation de la biodiversité. Les dispositifs en place ou en développement concernent tous les secteurs, avec des degrés de recours à l'IA variables.

A. UN RECOURS DÉJÀ BIEN ANCRÉ POUR L'OPTIMISATION DES RESSOURCES ET DES INFRASTRUCTURES DANS DE NOMBREUX SECTEURS

Dans le cadre de la transition écologique, l'IA est identifiée comme un levier pour optimiser l'exploitation ou la gestion des ressources, des équipements et des infrastructures. De nombreuses entreprises sont à l'origine d'applications et de services innovants visant à améliorer les chaînes logistiques et l'aide à la décision ou à la maîtrise des risques.

1. L'agriculture

C'est le cas en particulier dans le domaine de l'agriculture, où le marché de l'IA connaît une croissance économique importante.

L'analyse d'images est par exemple déjà utilisée en viticulture, pour réaliser des « cartes de vigueur » ou détecter les attaques de mildiou, comme le propose l'entreprise « Chouette ». Cette technique permet de suivre en temps réel les parcelles pour en optimiser la gestion. Sur le fondement des images obtenues par des capteurs embarqués et des drones équipés de caméras, des analyses sont générées par croisement des algorithmes d'IA avec des modèles agronomiques. Des alertes ou bulletins de suivi sont ensuite émis pour des pratiques viticoles plus précises et raisonnées.

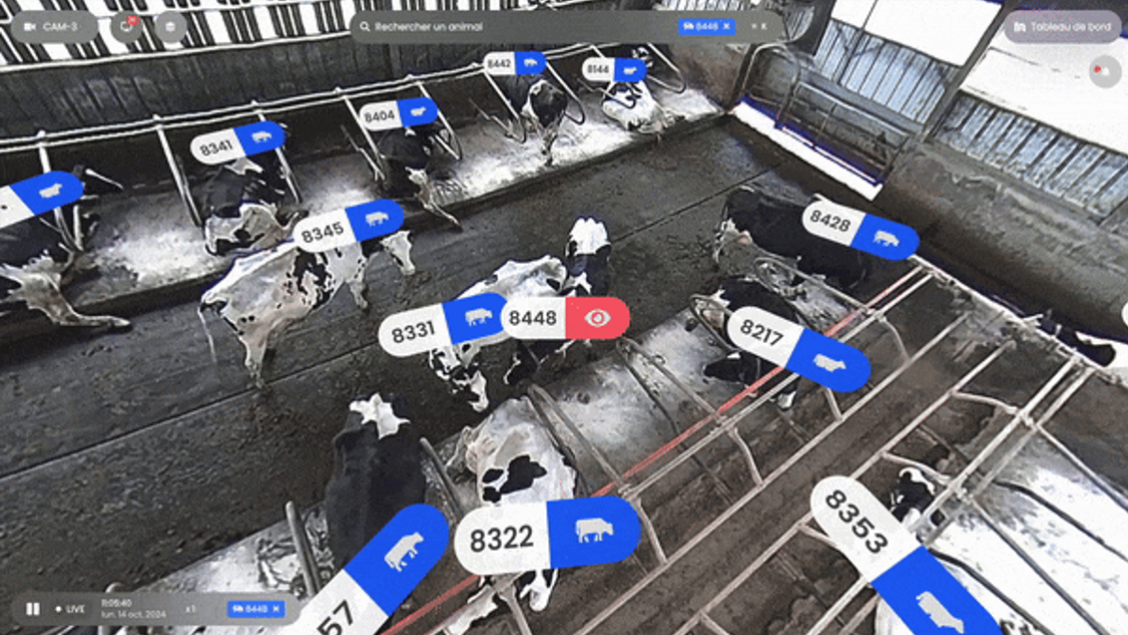

Cette technique est également appliquée à l'élevage, par exemple pour analyser le comportement des animaux à partir d'images vidéos et contribuer à leur suivi sanitaire. C'est ce que propose une entreprise comme « AI Herd » qui met en avant un outil permettant de détecter des signaux d'alerte dans les mouvements et les interactions des animaux dans les exploitations de vaches laitières.

Source : https://www.aiherd.io/fr

Avec les progrès de l'apprentissage automatique, l'IA est en outre de plus en plus utilisée pour analyser et contrôler une multitude de facteurs (température, hygrométrie, intrants, traitements mécaniques, type de semences...), pour limiter les émissions de CO2 et tendre vers des pratiques plus agroécologiques.

L'importance de la recherche en IA pour capturer les gaz à effet de serre dans l'agriculture

« Depuis quelques années, de nombreuses universités développent des systèmes à base d'intelligence artificielle, le plus souvent en open source, pour optimiser la capture de gaz à effet de serre dans l'agriculture. C'est par exemple le cas de l'école de la résilience Derr à Standford, qui travaille sur différents modèles à base de machine learning. C'est également le cas de l'Université du Minnesota, qui développe des solutions en partenariat avec le ministère de l'agriculture des États-Unis, ou encore de Cornell University, qui a monté un ensemble de cours sur cette pratique. Le secteur privé n'est pas en reste. Microsoft par exemple a initié le programme AI for Health, un programme de bourses sur différents thèmes, au sein desquels les sujets d'optimisation de l'agriculture à des fins environnementales sont particulièrement présents. Et, surtout, Google investit fortement dans sa filiale Mineral, visant à accroître la quantité de données disponibles dans l'agriculture afin de faciliter l'apprentissage des modèles d'IA. Enfin, de nombreuses start-up se sont également positionnées sur ce sujet. Terramera et Regen Network sont parmi celles dont les programmes sont les plus concrètement avancés et accessibles dans certains pays. »

Gilles Babinet, Green IA. L'intelligence artificielle au service du climat,2024, p. 150

L'entreprise « Assolia »43(*) commercialise par exemple une technologie pour aider les agriculteurs à optimiser la rotation des cultures sur leurs parcelles. Il s'agit d'un outil collaboratif qui propose de croiser des données sur les caractéristiques de l'exploitation avec des statistiques climatiques et météorologiques et des informations issues des coopératives et des marchés. L'objectif est ensuite d'identifier les meilleures combinaisons de cultures et de fournir des scénarios d'assolement sur trois à sept ans.

Enfin, l'IA offre des perspectives d'automatisation avancée, qu'il s'agisse de la robotisation du désherbage, de l'utilisation de tracteurs autonomes pour le labourage ou les récoltes, du contrôle de la qualité des sols ou encore de la robotisation de la cueillette ou du tri dans le maraîchage.

2. La pêche

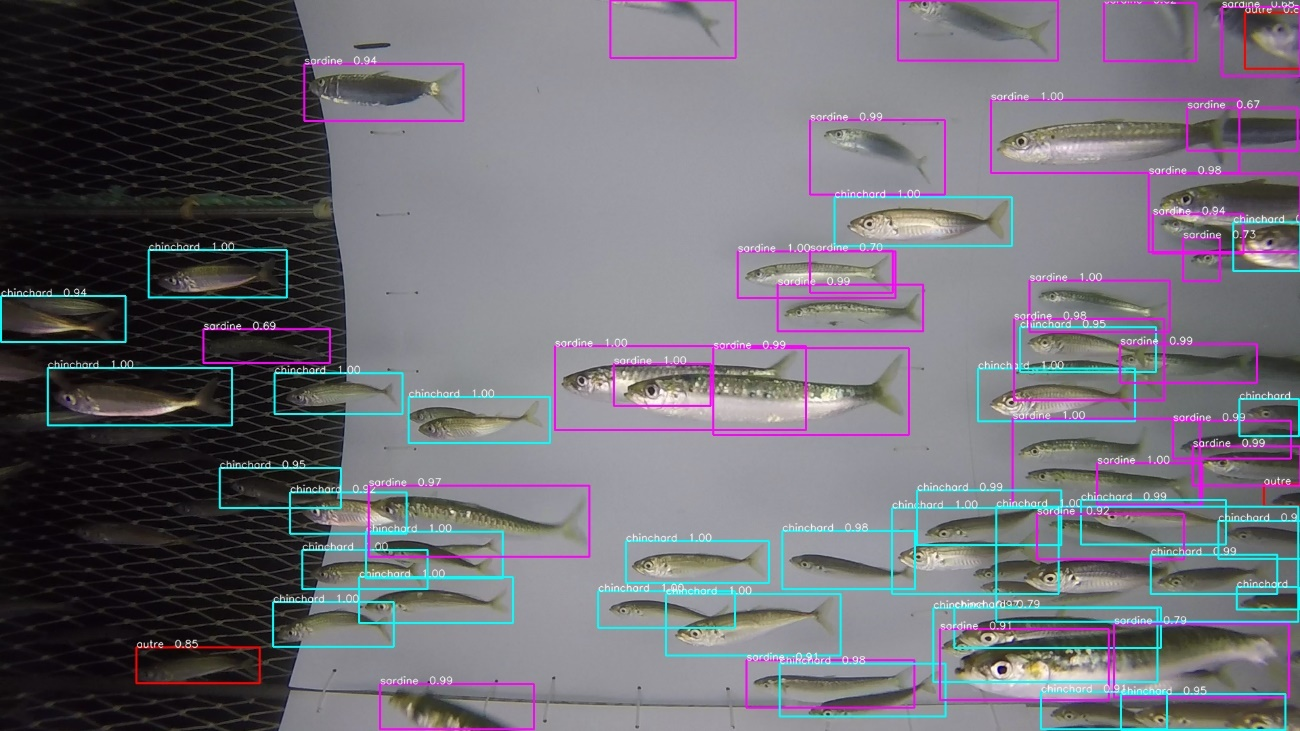

Dans le secteur de la pêche, des techniques d'IA sont utilisées pour développer des « filets intelligents » dans le cadre de la pêche au chalut. L'enjeu est de minimiser les captures aléatoires d'espèces sans distinction de poissons pour réduire le gaspillage et préserver les ressources.

Fondé sur le traitement d'images complexes, le projet « Game of Trawls »44(*) consiste à entraîner des réseaux de neurones sur une grande quantité de données afin qu'ils puissent mesurer l'impact des engins de pêche et identifier les espèces entrant dans les filets.

J. Simon - Ifremer - Projet Game of Trawls

Grâce à un réseau de capteurs et de vision par ordinateur, les pêcheurs sont informés en temps réel de la présence plus ou moins importante de bancs de poissons et des espèces concernées. Ils peuvent, à l'aide d'un dispositif d'évacuation (fermeture du cul de chalut, piège de dérivation, flash lumineux, signaux acoustiques...), trier les poissons sous l'eau pour ne garder que ceux qui les intéressent ou relever les filets de pêche pour ne plus racler les fonds marins.

3. L'énergie

Dans le domaine de l'énergie et de la gestion des réseaux électriques, l'IA peut permettre d'équilibrer l'offre et la demande et de passer à un système plus intermittent et distribué (smart grids) mais également d'améliorer la prévention des incidents sur le réseau.

L'outil d'IA « CartoLine BT » d'Enedis permet par exemple de renforcer l'efficacité de la maintenance prédictive sur le réseau de distribution d'électricité basse tension. L'analyse des données collectées grâce aux compteurs Linky sur la fourniture d'électricité conduit à l'identification automatique des situations pouvant entraîner des pannes.

4. L'économie circulaire

S'agissant de l'économie circulaire, le projet DiagTP 360 élaboré par le Cerema en partenariat avec LEXISTEMS permet de mobiliser l'IA pour réduire l'impact environnemental des travaux publics.

En ayant recours à un module d'IA générative, ce projet doit permettre aux maîtres d'ouvrage et maîtres d'oeuvre de réaliser un inventaire des matériaux présents sur le chantier, d'identifier des possibilités de réemploi et de valorisation, d'estimer les quantités de déchets à évacuer et de procéder à un calcul des indicateurs environnementaux (émissions de CO2, consommation d'énergie).

5. Les transports

Enfin, dans le secteur des transports et de la mobilité, l'IA peut contribuer à optimiser en temps réel les déplacements et à améliorer la maintenance et l'exploitation des infrastructures45(*).

À titre d'exemple, dans le transport maritime, l'IA sert à mieux utiliser les données météorologiques pour décarboner le secteur de la navigation en optimisant les trajets en mer. Fin 2023, le secrétariat d'État chargé de la mer a par exemple apporté son soutien à Marine Weather Intelligence, une start-up46(*) dont le projet porte sur l'identification des routes maritimes optimales.

L'objectif est d'entraîner des outils d'IA sur des modèles numériques qui intègrent de nombreuses données atmosphériques et océaniques (vents, courants, etc.) afin de réduire l'incertitude des prévisions. Après la sélection des données pertinentes pour chaque zone de navigation et une phase d'apprentissage s'appuyant sur les capacités du supercalculateur Datarmor, le modèle final doit être capable de fournir rapidement des prédictions des états de mer et des recommandations de routage. Celui-ci pourrait être mieux adapté aux conditions réelles, contribuant à une baisse de la consommation de carburant.

B. L'IA POUR RENFORCER LA RÉSILIENCE FACE AUX DÉFIS ÉCOLOGIQUES

La mobilisation de l'IA pour renforcer la résilience face aux conséquences du dérèglement climatique fait également l'objet de nombreuses initiatives.

Il s'agit d'accompagner les choix sociétaux et individuels (lieux de résidence à privilégier, types d'habitat à retenir, équipements et infrastructures à prévoir) pour s'adapter à la nouvelle donne environnementale.

· Optimiser le développement des énergies renouvelables

§ L'équipe « Arches » de l'Inria travaille en particulier sur des projets visant à optimiser la conception et l'implantation des énergies renouvelables.

À titre d'exemple, une collaboration avec EDF a pour objectif de mieux prévoir la circulation des vents à moyen terme (5-10 ans) de manière à ce que l'entreprise publique puisse mieux concevoir et positionner les éoliennes.

La circulation des vents étant affectée de changements comportant encore des incertitudes, des outils d'IA sont entraînés sur des données d'EDF portant sur le passé très récent afin de déterminer les localisations optimales.

Parallèlement, les impacts du changement climatique sur les températures et les radiations solaires sont étudiés pour concevoir de nouvelles générations de panneaux photovoltaïques.

Pour ces travaux, des modèles d'IA sont entraînés en utilisant les données actuelles ainsi que des simulations physiques récentes. Après entraînement, le modèle d'IA peut en quelque sorte « traduire » des simulations physiques et générer des prévisions des vents, des températures et de l'irradiance solaire à des échelles plus fines que celles accessibles via les simulations numériques.

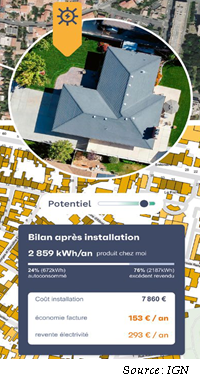

Pour connaître le potentiel photovoltaïque des bâtiments, la start-up NamR, partenaire de l'IGN47(*), a développé une IA capable de définir la configuration optimale pour l'installation de panneaux solaires sur les toits.

Plus largement, des techniques de machine learning, deep learning et vision par ordinateur permettent de modéliser des données sur les logements recueillies auprès de centaines de milliers de sources et de produire des propositions personnalisées pour une adresse donnée afin de transformer l'habitat par une rénovation énergétique et un plan d'adaptation au changement climatique. Chaque proposition s'accompagne d'une estimation des coûts et des bénéfices associés aux travaux conseillés.

· S'adapter aux îlots de chaleur

Dans les milieux fortement urbanisés, l'IA est également utilisée de façon croissante pour l'identification d'îlots de chaleur à partir de capteurs ou d'images satellites.

Elle peut ainsi apporter une aide précieuse pour prioriser les actions de renaturation en fonction de critères comme la faisabilité technique, les conséquences pour le confort de vie et les caractéristiques socio-économiques du lieu concerné.

· Exploiter les données génomiques pour l'adaptation au changement climatique

§ Dans un tout autre domaine enfin, le recours à l'IA pourrait, selon l'Inria, s'avérer utile pour détecter des séquences génétiques adaptées au changement climatique.

En effet, une masse considérable de données de séquençage d'ADN continue de croître dans les banques de données génomiques publiques. L'accès à ces données permet des avancées importantes non seulement en médecine mais aussi dans le domaine de l'écologie, de l'agronomie et pour la surveillance des océans. Or elles restent sous-exploitées.

Dans ce contexte, le projet « Omicfinder » de l'Inria a pour objectif la mise au point d'un nouveau moteur de recherche global par lequel interroger, grâce notamment au développement de nouveaux algorithmes, les séquences nucléotidiques à partir de l'immense quantité de données génomiques accessibles au public.

C. LE RECOURS À L'IA DANS LA GESTION DU RISQUE ET DES CRISES

Au-delà des enjeux de connaissance de l'environnement et d'adaptation, le recours à l'IA peut également s'avérer précieux pour la gestion de crise. C'est le cas par exemple face au risque de submersion marine ou d'incendie de forêt.

· Réagir à un risque de submersion lorsque le temps est un enjeu critique

Au titre de l'appui à la gestion de crise, le BRGM a développé un outil d'aide à la décision fondé sur la définition de scénarios de risques de submersion à l'échelle de collectivités.

Traditionnellement, les modèles de « risque submersion » sont complexes et consomment un temps de calcul important. En temps de crise, l'approche par métamodèles prédéfinis permet de contrer la relative lenteur des modèles physiques et de fournir aux cellules de crise des réponses sur les niveaux de risques.

Cette méthode a été testée récemment sur la côte Aquitaine48(*) : il s'agit d'un atlas de simulations numériques de submersion sur le bassin d'Arcachon obtenu par du machine learning non supervisé et des méthodes statistiques très avancées.

L'IA permet ici non seulement de renforcer la finesse de l'analyse mais aussi la réactivité grâce à un gain de temps considérable.

· Intervenir précocément en cas d'incendie

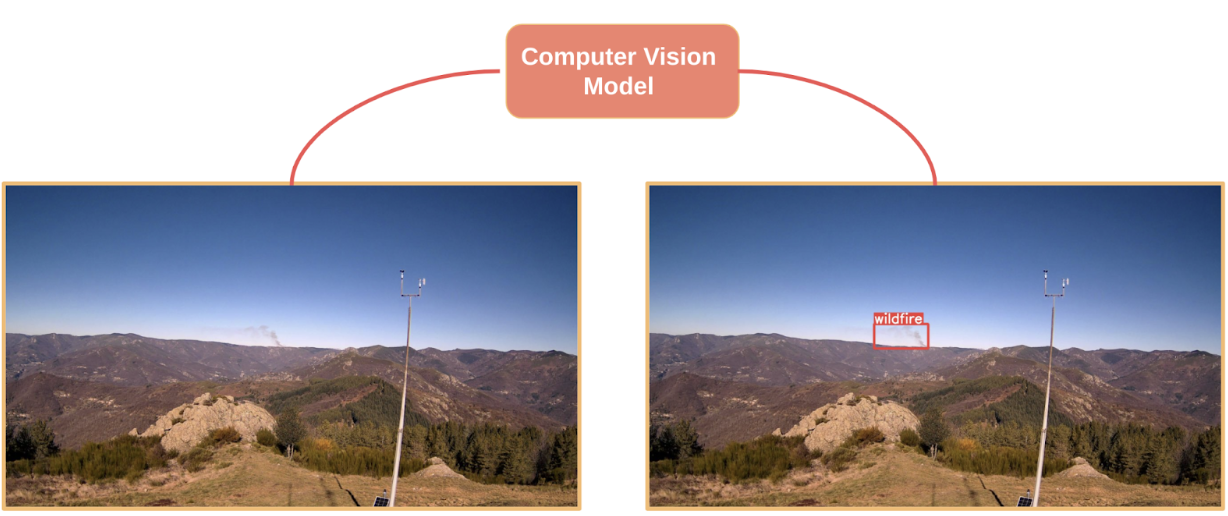

Des développements encourageants sont également en cours pour orienter l'usage de l'IA vers la détection de départs de feu de forêt afin de rendre la plus précoce possible l'intervention des services de secours.

En partenariat avec le service départemental d'incendie et de secours (SDIS) du département de l'Ardèche, l'association Pyronear propose depuis 2023 un système expérimental associant des caméras de vidéosurveillance à un micro-ordinateur équipé d'un logiciel d'apprentissage profond.

Source : https://pyronear.org/

Celui-ci a été entraîné à reconnaître des départs d'incendie sur des dizaines de milliers d'images de feux de forêt, avec des données provenant initialement de caméras situées dans les parcs nationaux américains et en libre accès.

Sous réserve de nouvelles évolutions permettant de réduire les faux positifs et d'affiner la capacité de détection et de prédiction, d'autres domaines tels que la détection d'inondations, de fortes crues ou encore d'avalanches pourraient être concernés par des techniques similaires.

D. L'IA ET LES ASSURANCES : COMMENT ASSURER LA CATASTROPHE ?

Face à l'intensification et à la multiplication des événements extrêmes, le modèle assurantiel actuel, combinant assurances privées et interventions publiques, est-il suffisamment robuste ?

En renforçant la précision des prévisions, les systèmes d'alerte précoce et la résilience des territoires, les techniques d'IA pourraient contribuer à l'adaptation du système d'assurance.

« Imaginez un jumeau numérique pour une propriété côtière qui surveille en permanence l'élévation du niveau de la mer, les conditions météorologiques et l'intégrité structurelle, ce qui permet d'alerter rapidement en cas de risque d'inondation et d'effectuer les travaux de maintenance préventifs.

Les jumeaux numériques permettent une évaluation et une atténuation proactives des risques. Les assureurs peuvent affiner les modèles de risque, personnaliser la couverture et proposer des primes compétitives sur la base de données en temps réel. »

Michel de La Bellière et Jochen Papenbrock, « IA et IA Générative : l'assurance est-elle à la veille d'une transformation fondamentale dans la couverture et la gestion des risques ? », L'Argus de l'assurance, 2023

Le prototype de jumeau numérique pour la gestion des risques d'inondation développé par le CNES et QuantCube va jusqu'à fournir une estimation du risque financier associé aux inondations dans les zones de test sélectionnées. Ces informations pourront être utilisées par les gouvernements et d'autres acteurs intéressés parmi lesquels les assureurs.

III. LA RECHERCHE SUR LES TECHNIQUES D'IA FRUGALE POUR CONCILIER APPORT DE L'IA ET SOBRIÉTÉ NUMÉRIQUE

Dans le cadre de la stratégie nationale pour l'IA, la recherche s'oriente également vers la contribution de l'IA à la sobriété numérique. Il s'agit de développer des modèles avec moins de données ou de paramètres mais autant, voire davantage, performants que les grands modèles disponibles sur le marché.

De fait, certains projets parviennent à combiner apports de l'IA à l'environnement « AI for green » et IA frugale (« green IA »).

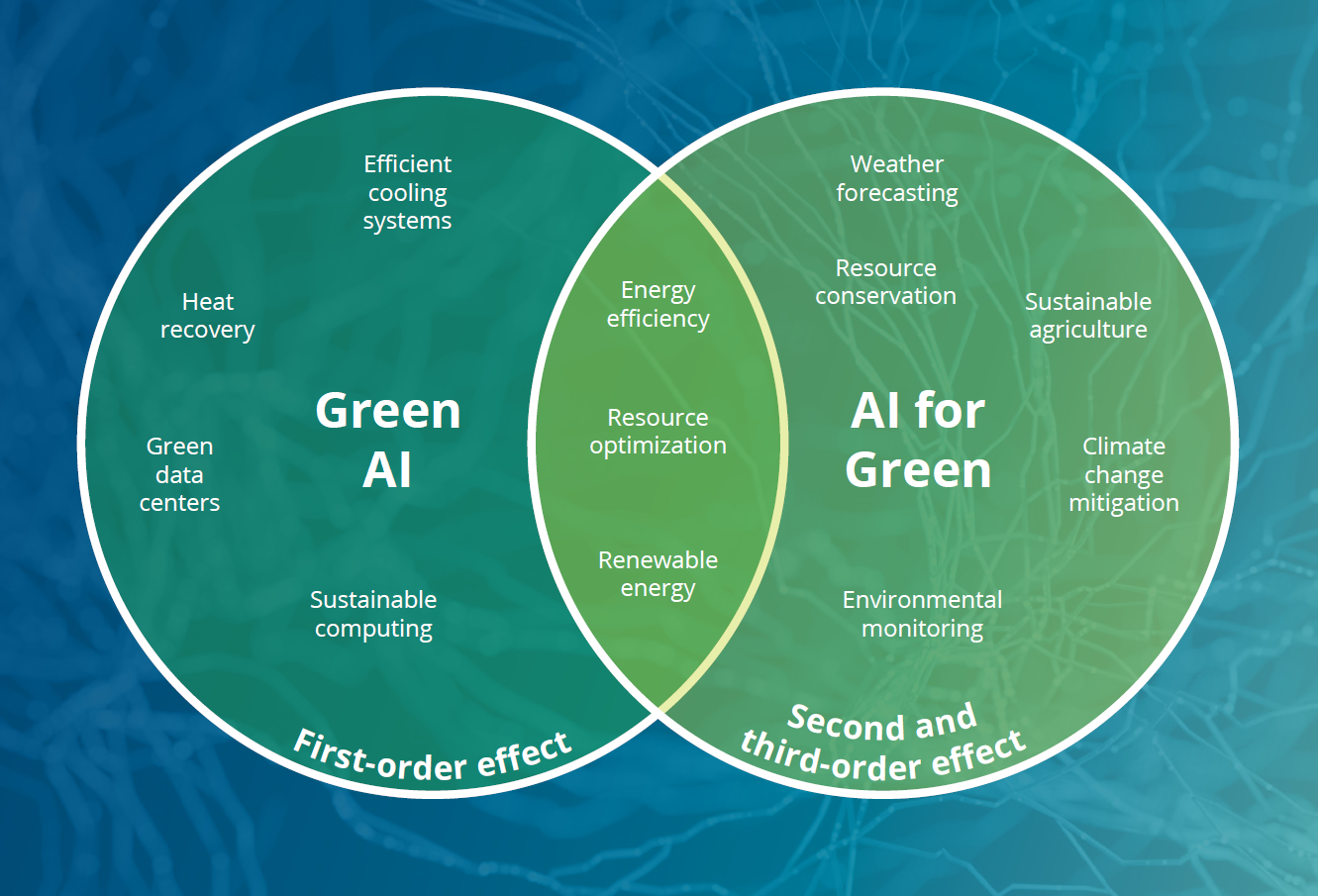

« Green AI » et « AI for Green » : deux dimensions complémentaires reliant l'IA et l'environnement

Source : Illustration Deloitte basée sur l'étude de L. Hilty et B.Aebisher

L'« IA verte » concerne les efforts réalisés pour réduire l'empreinte environnementale de l'IA tout au long de la chaîne de valeur (de l'approvisionnement en énergie à l'amélioration des matériels en passant par la transformation des centres de données). Parallèlement, l'« IA pour l'environnement » peut également favoriser une IA plus frugale à travers par exemple l'optimisation des ressources ou sa contribution au développement des énergies renouvelables.

Dans le domaine du changement climatique, l'Inria met ainsi en avant des initiatives visant à réduire l'empreinte environnementale du numérique tout en utilisant l'IA pour mieux comprendre et modéliser les phénomènes environnementaux.

Alors qu'un code numérique « traditionnel » pour la prévision météorologique peut comporter plusieurs centaines de milliers de lignes, les outils proposés par l'équipe « Arches » ne comportent que quelques milliers de lignes et réduisent donc le coût environnemental de la simulation.

Météo-France indique également que le rapport entre la performance et la frugalité des réseaux de neurones convolutifs apparaît très intéressant, les coûts d'inférence et d'apprentissage apparaissant raisonnables (quelques heures pour l'apprentissage et quelques minutes pour l'inférence).

S'agissant de l'IA générative, des systèmes d'IA plus spécifiques que les grands modèles développés et hébergés par les géants du numérique peuvent également être développés et permettre de concilier innovation et réduction de l'impact environnemental.

Combiner apport de l'IA au service de l'environnement et sobriété de l'IA est également le principe directeur que s'est donnée l'action publique au niveau de l'État à travers la promotion de l'IA frugale.

DEUXIÈME PARTIE

UNE ACTION PUBLIQUE QUI SE

STRUCTURE POUR FAVORISER L'ÉMERGENCE DE SOLUTIONS D'IA AU SERVICE DE

L'ENVIRONNEMENT, MAIS DES ÉVOLUTIONS ENCORE TRÈS

EXPLORATOIRES

I. FAIRE ÉMERGER DES SOLUTIONS D'« IA FOR GREEN » : UNE AMBITION DE L'ACTION PUBLIQUE AUX NIVEAUX NATIONAL ET EUROPÉEN

A. UN CADRE EUROPÉEN QUI ENTEND CONCILIER INNOVATION TECHNOLOGIQUE ET PROTECTION DE L'ENVIRONNEMENT

Le règlement européen sur l'intelligence artificielle (AI Act) du 13 juin 202449(*) ne comporte pas de chapitre dédié à l'environnement.